Prompt Engineering entwickelte sich im letzten Jahr zu einem gefragten Job in der KI-Branche, doch es scheint, dass Anthropic nun Tools entwickelt, um es zumindest teilweise zu automatisieren.

Anthropic hat am Dienstag mehrere neue Funktionen veröffentlicht, die Entwicklern helfen sollen, mit dem Sprachmodell des Startups, Claude, nützlichere Anwendungen zu erstellen, so ein Blogbeitrag des Unternehmens. Entwickler können jetzt Claude 3.5 Sonnet verwenden, um Eingabeaufforderungen zu generieren, zu testen und zu bewerten. Dabei können sie Prompt-Engineering-Techniken verwenden, um bessere Eingaben zu erstellen und Claudes Antworten für spezielle Aufgaben zu verbessern.

Sprachmodelle sind ziemlich nachsichtig, wenn Sie sie bitten, bestimmte Aufgaben auszuführen, aber manchmal können kleine Änderungen an der Formulierung einer Eingabeaufforderung zu großen Verbesserungen der Ergebnisse führen. Normalerweise müssten Sie sich diese Formulierung selbst ausdenken oder einen Eingabeaufforderungsingenieur damit beauftragen, aber diese neue Funktion bietet schnelles Feedback, das die Suche nach Verbesserungen erleichtern könnte.

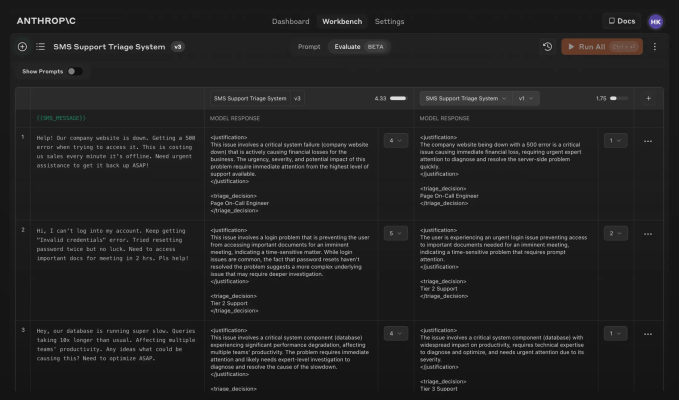

Die Funktionen sind in der Anthropic Console unter einer neuen Registerkarte „Evaluate“ untergebracht. Console ist die Testküche des Startups für Entwickler und wurde geschaffen, um Unternehmen anzuziehen, die Produkte mit Claude entwickeln möchten. Eine der im Mai vorgestellten Funktionen ist Anthropics integrierter Prompt-Generator. Dieser nimmt eine kurze Beschreibung einer Aufgabe und erstellt einen viel längeren, ausführlicheren Prompt, wobei er Anthropics eigene Prompt-Engineering-Techniken verwendet. Auch wenn Anthropics Tools Prompt-Engineers nicht vollständig ersetzen werden, sagte das Unternehmen, dass sie neuen Benutzern helfen und erfahrenen Prompt-Engineers Zeit sparen würden.

Innerhalb von Evaluate können Entwickler testen, wie effektiv die Eingabeaufforderungen ihrer KI-Anwendung in einer Reihe von Szenarien sind. Entwickler können Beispiele aus der Praxis in eine Testsuite hochladen oder Claude bitten, eine Reihe von KI-generierten Testfällen zu erstellen. Entwickler können dann die Effektivität verschiedener Eingabeaufforderungen nebeneinander vergleichen und Beispielantworten auf einer Fünf-Punkte-Skala bewerten.

In einem Beispiel aus dem Blogbeitrag von Anthropic stellte ein Entwickler fest, dass seine Anwendung in mehreren Testfällen zu kurze Antworten lieferte. Der Entwickler konnte eine Zeile in seiner Eingabeaufforderung so anpassen, dass die Antworten länger wurden, und dies gleichzeitig auf alle Testfälle anwenden. Dies könnte Entwicklern viel Zeit und Mühe sparen, insbesondere solchen mit wenig oder keiner Erfahrung in der Eingabeaufforderungsentwicklung.

Anthropic CEO und Mitbegründer Dario Amodei sagte, dass eine schnelle Entwicklung eines der wichtigsten Dinge für eine breite Einführung generativer KI in Unternehmen sei. Interview von Google Cloud Next Anfang des Jahres. „Es klingt einfach, aber 30 Minuten mit einem schnellen Techniker können oft dafür sorgen, dass eine Anwendung funktioniert, die vorher nicht funktioniert hat“, sagte Amodei.