Chatgpt, die Chatbot-Plattform von OpenAI, ist möglicherweise nicht so leistungsstark wie einmal angenommen. Der Appetit hängt jedoch weitgehend davon ab, wie ChatGPT verwendet wird, und die KI -Modelle, die laut einer neuen Studie die Anfragen beantworten.

A Aktuelle Analyse Von Epoch AI, einem gemeinnützigen AI -Forschungsinstitut, versuchte zu berechnen, wie viel Energie eine typische Chatgpt -Abfrage verbraucht. A häufig zitiert STAT ist, dass ChatGPT rund 3 Wattstunden Kraft benötigt, um eine einzige Frage zu beantworten, oder zehnmal so viel wie eine Google-Suche.

Epoch glaubt, dass dies eine Überschätzung ist.

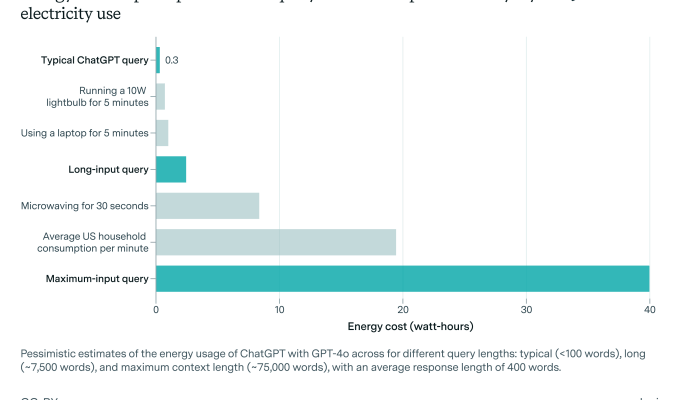

Als Referenz von OpenAIs neuestem Standardmodell für Chatgpt, GPT-4O, stellte Epoch fest, dass die durchschnittliche Chatgpt-Abfrage rund 0,3 Wattstunden verbraucht-weniger als viele Haushaltsgeräte.

„Der Energieverbrauch ist im Vergleich zur Verwendung normaler Geräte oder Heizung oder Kühlung Ihres Hauses oder beim Fahren eines Autos wirklich keine große Sache“, sagte Joshua, der Datenanalyst bei Epoch, der die Analyse durchführte, gegenüber Tech.

Der Energieverbrauch von AI – und ihre Umweltauswirkungen im Großen und Ganzen sind Gegenstand umstrittener Debatten, da KI -Unternehmen ihre Infrastruktur -Fußabdrücke schnell erweitern wollen. Erst letzte Woche eine Gruppe von über 100 Organisationen veröffentlichte einen offenen Brief Fordern Sie die KI-Industrie und die Aufsichtsbehörden auf, sicherzustellen, dass neue AI-Rechenzentren keine natürlichen Ressourcen abbauen und die Versorgungsunternehmen dazu zwingen, sich auf nicht erneuerbare Energiequellen zu verlassen.

Sie haben Tech mitgeteilt, dass seine Analyse durch das beflügelt wurde, was er als veraltete frühere Forschungen bezeichnete. Sie haben zum Beispiel darauf hingewiesen, dass der Autor des Berichts, der bei der 3-Watt-Schätzung ankam, angenommen wurde, dass Openai ältere, weniger effiziente Chips zum Ausführen seiner Modelle verwendete.

„Ich habe viel öffentlichen Diskurs gesehen, die richtig erkannt haben, dass AI in den kommenden Jahren viel Energie verbrauchen würde, aber die Energie, die heute zu AI ging, nicht genau beschrieben“, sagten Sie. „Außerdem stellten einige meiner Kollegen fest, dass die am weitesten verbreitete Schätzung von 3 Wattstunden pro Abfrage auf ziemlich alten Forschungen beruhte und auf einigen Serviettenmathematik zu hoch zu sein schien.“

Zugegeben, Epochs 0,3-Watt-Stunden-Zahl ist ebenfalls eine Annäherung; OpenAI hat die Details, die erforderlich sind, um eine genaue Berechnung vorzunehmen, nicht veröffentlicht.

Die Analyse berücksichtigt auch nicht die zusätzlichen Energiekosten, die durch CHATGPT -Funktionen wie Bildgenerierung oder Eingabebereich entstanden sind. Sie bestätigten, dass ChatGPT -Abfragen von „Long Input“ – beispielsweise Abfragen mit langen angehängten Dateien – wahrscheinlich mehr Strom im Voraus verbrauchen als eine typische Frage.

Sie sagten, er erwarte jedoch, dass der Basis -Chatgpt -Stromverbrauch steigt.

“[The] KI wird fortgeschrittener werden, wenn diese KI wahrscheinlich viel mehr Energie erfordern, und diese zukünftige KI kann viel intensiver verwendet werden – um viel mehr Aufgaben und komplexere Aufgaben zu erledigen, als die Art und Weise, wie Menschen Chatgpt heute verwenden “, sagte Sie.

Obwohl in den letzten Monaten bemerkenswerte Durchbrüche in der KI-Effizienz geboten wurden, wird erwartet, dass die Ausweitung der KI eingesetzt wird, die eine enorme, krafthungrige Infrastrukturausdehnung erzielt. In den nächsten zwei Jahren müssen KI -Rechenzentren möglicherweise in der Nähe der gesamten 2022 -Leistungskapazität von Kalifornien (68 GW) erforderlich sind. Laut einem Rand -Bericht. Bis 2030 könnte das Training eines Frontier -Modells eine Leistung erfordern, die dem von acht Kernreaktoren (8 GW) entspricht, prognostizierte der Bericht.

Allein Chatgpt erreicht eine enorme und expandierende Anzahl von Personen, wodurch der Server ähnlich massiv ist. OpenAI plant zusammen mit mehreren Investitionspartnern, in den nächsten Jahren Milliarden von Dollar für neue AI -Rechenzentrumsprojekte auszugeben.

Die Aufmerksamkeit von OpenAI-zusammen mit dem Rest der KI-Branche-verlagert sich auch zu sogenannten Argumentationsmodellen, die in Bezug auf die Aufgaben, die sie ausführen können, im Allgemeinen fähiger sind, erfordern jedoch mehr Computer. Im Gegensatz zu Modellen wie GPT-4O, die fast sofort auf Anfragen reagieren, „denken“ die Argumentation von „Denken“ für Sekunden bis Minuten vor der Beantwortung „denken“, ein Prozess, der mehr Computer saugt-und damit die Stromversorgung.

„Argumentationsmodelle werden zunehmend Aufgaben übernehmen, die ältere Modelle nicht können, und mehr generieren [data] Dazu und beide erfordern mehr Rechenzentren “, sagten Sie.

OpenAI hat begonnen, leistungsstärkere Argumentationsmodelle wie O3-Mini freizusetzen. Aber es scheint unwahrscheinlich, dass zumindest an diesem Punkt die Effizienzgewinne die erhöhten Stromanforderungen aus dem „Denken“ -Prozess von Argumentationsmodellen und dem wachsenden KI -Gebrauch auf der ganzen Welt ausgleichen werden.

Sie schlugen vor, dass die Menschen sich Sorgen machen, dass ihre KI -Energie -Fußabdruck Apps wie ChatGPT selten verwenden oder Modelle ausgewählt haben, die das erforderliche Computer minimieren – soweit realistisch.

„Sie könnten versuchen, kleinere KI -Modelle wie zu verwenden [OpenAI’s] GPT-4O-Mini “, sagten Sie,„ und verwenden Sie sie sparsam auf eine Weise, bei der eine Menge Daten verarbeitet oder generiert werden muss. “