Jensen Huang, Gründer und CEO von Nvidia, sagte heute, dass das Unternehmen im Jahr 2018 eine existenzielle Geschäftsentscheidung getroffen habe, von der nur wenige wussten, dass sie seine Zukunft neu definieren und dazu beitragen würde, eine sich entwickelnde Branche neu zu definieren. Es hat sich natürlich enorm ausgezahlt, aber Huang sagte, dies sei erst der Anfang einer KI-gestützten nahen Zukunft – einer Zukunft, die hauptsächlich von Nvidia-Hardware angetrieben werde. War dieser erfolgreiche Schachzug Glück oder klug? Die Antwort scheint „Ja“ zu sein.

Er machte diese Bemerkungen und Überlegungen während einer Keynote bei SIGGRAPH in Los Angeles. Dieser Wendepunkt vor fünf Jahren, sagte Huang, sei die Entscheidung für die KI-gestützte Bildverarbeitung in Form von Raytracing und intelligentem Upscaling gewesen: RTX bzw. DLSS. (Zitate stammen aus meinen Notizen und sind möglicherweise nicht wörtlich; nach Überprüfung des Transkripts können einige geringfügige Korrekturen vorgenommen werden.)

„Wir haben erkannt, dass die Rasterung an ihre Grenzen stößt“, sagte er und bezog sich dabei auf die traditionelle, weit verbreitete Methode zum Rendern einer 3D-Szene. „2018 war ein ‚Bet the Company‘-Moment. Es erforderte, dass wir die Hardware, die Software und die Algorithmen neu erfinden. Und während wir CG mit KI neu erfanden, erfanden wir die GPU für KI neu.“

Während Raytracing und DLSS noch dabei sind, in der vielfältigen und komplexen Welt der Consumer-GPUs und Spiele eingeführt zu werden, erwies sich die Architektur, die sie dafür geschaffen hatten, als perfekter Partner für die wachsende Community der Machine-Learning-Entwickler.

Der enorme Rechenaufwand, der zum Trainieren immer größerer generativer Modelle erforderlich war, wurde am besten nicht von herkömmlichen Rechenzentren mit einer gewissen GPU-Fähigkeit bewältigt, sondern von Systemen wie dem H100, die von Anfang an darauf ausgelegt waren, die erforderlichen Vorgänge in großem Maßstab durchzuführen. Man kann mit Recht sagen, dass die KI-Entwicklung in gewisser Weise nur durch die Verfügbarkeit dieser Computerressourcen begrenzt war. Nvidia erlebte einen Boom im Beanie-Baby-Maßstab und hat etwa so viele Server und Workstations verkauft, wie es herstellen konnte.

Aber Huang behauptete, dass dies erst der Anfang sei. Die neuen Modelle müssen nicht nur trainiert, sondern auch regelmäßig in Echtzeit von Millionen, vielleicht sogar Milliarden Benutzern ausgeführt werden.

„Die Zukunft ist ein LLM, das bei fast allem im Vordergrund steht: „Mensch“ ist die neue Programmiersprache“, sagte er. Alles, von visuellen Effekten bis hin zu einem sich schnell digitalisierenden Fertigungsmarkt, Fabrikdesign und Schwerindustrie, werde bis zu einem gewissen Grad eine Schnittstelle in natürlicher Sprache übernehmen, riskierte Huang.

„Ganze Fabriken werden softwaregesteuert und robotergesteuert sein, und die Autos, die sie bauen werden, werden selbst robotergesteuert sein. Es handelt sich also um roboterhaft konstruierte Roboter, die Roboter bauen“, sagte er.

Einige teilen möglicherweise nicht seine Ansichten, die zwar plausibel, aber auch äußerst freundlich zu den Interessen von Nvidia sind.

Aber während die Grad Die Abhängigkeit von LLMs mag unbekannt sein, nur wenige würden sagen, dass sie überhaupt nicht übernommen werden, und selbst eine vorsichtige Schätzung darüber, wer sie nutzen wird und wofür, wird eine erhebliche Investition in neue Rechenressourcen erfordern.

Es ist töricht, Millionen von Dollar in Computerressourcen der neuesten Generation zu investieren, wie z. B. CPU-fokussierte Racks, wenn so etwas wie ein GH200, die neu vorgestellte und speziell für Rechenzentren konzipierte KI-Entwicklungshardware, die gleiche Aufgabe für weniger als ein Zehntel der Kosten erledigen kann Strombedarf.

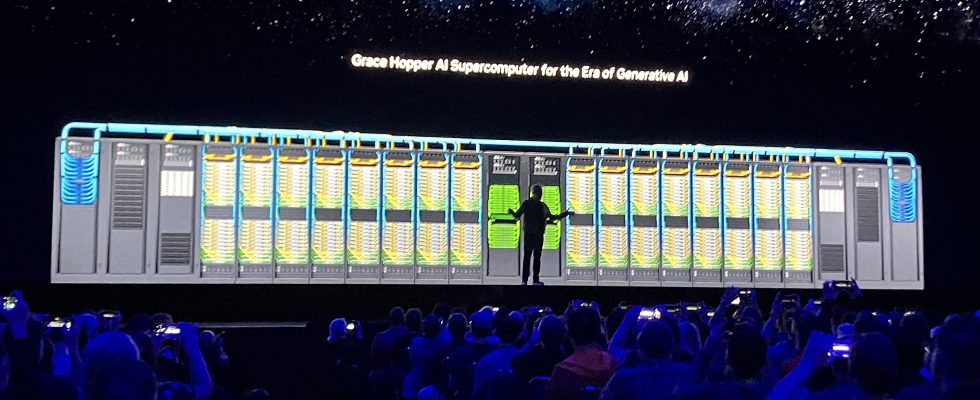

Er präsentierte fröhlich ein Video, das einen LEGO-ähnlichen Zusammenbau mehrerer Grace Hopper-Rechnereinheiten zu einem Blade, dann zu einem Rack und dann zu einer Reihe von GH200s zeigte, die alle mit so hohen Geschwindigkeiten verbunden waren, dass sie „der weltweit größten einzelnen GPU“ entsprachen, bestehend aus einer voller Exaflop an ML-Spezial-Rechenleistung.

Bildnachweis: Devin Coldewey

„Das ist übrigens echte Größe“, sagte er und stellte den dramatischen Effekt in den Mittelpunkt der Visualisierung. „Und es läuft wahrscheinlich sogar Crysis.“

Diese würden die Grundeinheit der digitalen, KI-dominierten Industrie der Zukunft sein, schlug er vor.

„Ich weiß nicht, wer das gesagt hat, aber… je mehr Sie kaufen, desto mehr sparen Sie. Wenn ich Sie bitten könnte, sich an eine Sache aus meinem heutigen Vortrag zu erinnern, dann wäre es das“, sagte er und erntete damit ein Lachen beim Spielpublikum hier bei SIGGRAPH.

Keine Erwähnung der vielen Herausforderungen der KI, der Regulierung oder des gesamten Konzepts der KI-Verschiebung – wie es im letzten Jahr bereits mehrfach der Fall war. Es ist zwar eine rosafarbene Sicht auf die Welt, aber wenn man während eines Goldrauschs Spitzhacken und Schaufeln verkauft, kann man es sich leisten, so zu denken.