Das UK Safety Institute, die kürzlich in Großbritannien gegründete KI-Sicherheitsbehörde, hat ein Toolset veröffentlicht, das darauf abzielt, „die KI-Sicherheit zu stärken“, indem es Industrie, Forschungsorganisationen und Hochschulen die Entwicklung von KI-Bewertungen erleichtert.

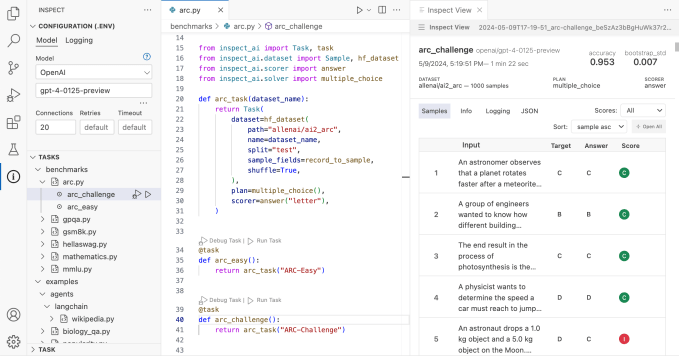

Das Toolset heißt Inspect und ist unter einer Open-Source-Lizenz verfügbar, insbesondere einer MIT-Lizenz – zielt darauf ab, bestimmte Fähigkeiten von KI-Modellen zu bewerten, einschließlich des Kernwissens und der Denkfähigkeit der Modelle, und auf der Grundlage der Ergebnisse eine Bewertung zu erstellen.

In einer Pressemitteilung ankündigen In den Nachrichten vom Freitag behauptete das Safety Institute, dass Inspect „das erste Mal ist, dass eine KI-Sicherheitstestplattform, die von einer staatlich unterstützten Stelle geleitet wurde, für eine breitere Nutzung freigegeben wurde“.

„Eine erfolgreiche Zusammenarbeit bei KI-Sicherheitstests erfordert einen gemeinsamen, zugänglichen Ansatz für Bewertungen, und wir hoffen, dass Inspect ein Baustein sein kann“, sagte Ian Hogarth, Vorsitzender des Safety Institute, in einer Erklärung. „Wir hoffen, dass die globale KI-Community Inspect nicht nur dazu nutzt, ihre eigenen Modellsicherheitstests durchzuführen, sondern auch, um bei der Anpassung und Weiterentwicklung der Open-Source-Plattform zu helfen, damit wir auf breiter Front qualitativ hochwertige Auswertungen erstellen können.“

Wie wir bereits geschrieben haben, sind KI-Benchmarks schwierig – nicht zuletzt, weil die ausgefeiltesten KI-Modelle heute Black Boxes sind, deren Infrastruktur, Trainingsdaten und andere wichtige Details von den Unternehmen, die sie erstellen, unter Verschluss gehalten werden. Wie geht Inspect mit der Herausforderung um? Vor allem durch Erweiterbarkeit und Erweiterbarkeit auf neue Testtechniken.

Inspect besteht aus drei Grundkomponenten: Datensätzen, Solvern und Scorern. Datensätze liefern Beispiele für Evaluierungstests. Solver übernehmen die Aufgabe, die Tests durchzuführen. Und die Bewerter bewerten die Arbeit der Löser und aggregieren die Ergebnisse der Tests zu Metriken.

Die integrierten Komponenten von Inspect können durch in Python geschriebene Pakete von Drittanbietern erweitert werden.

Deborah Raj, wissenschaftliche Mitarbeiterin bei Mozilla und bekannte KI-Ethikerin, bezeichnete Inspect in einem Beitrag auf

Clément Delangue, CEO des KI-Startups Hugging Face, brachte die Idee vor, Inspect in die Modellbibliothek von Hugging Face zu integrieren oder eine öffentliche Bestenliste mit den Ergebnissen der Evaluierungen des Toolsets zu erstellen.

Die Veröffentlichung von Inspect erfolgt, nachdem eine staatliche Regierungsbehörde – das National Institute of Standards and Technology (NIST) – NIST GenAI gestartet hat, ein Programm zur Bewertung verschiedener generativer KI-Technologien, einschließlich text- und bildgenerierender KI. NIST GenAI plant die Veröffentlichung von Benchmarks, die Entwicklung von Systemen zur Erkennung der Authentizität von Inhalten und die Förderung der Entwicklung von Software zur Erkennung gefälschter oder irreführender KI-generierter Informationen.

Im April kündigten die USA und Großbritannien eine Partnerschaft zur gemeinsamen Entwicklung fortschrittlicher KI-Modelltests an, nachdem sie im November letzten Jahres auf dem britischen AI Safety Summit in Bletchley Park Zusagen gemacht hatten. Im Rahmen der Zusammenarbeit beabsichtigen die USA, ein eigenes KI-Sicherheitsinstitut zu gründen, das sich im Großen und Ganzen mit der Bewertung der Risiken von KI und generativer KI befassen wird.