Roboter, die sich auf KI verlassen, um eine neue Aufgabe zu lernen, erfordern im Allgemeinen einen mühsamen und sich wiederholenden Trainingsprozess. Berkeley-Forscher versuchen, dies mit einer innovativen Lerntechnik zu vereinfachen und zu verkürzen, bei der der Roboter die Lücken füllt, anstatt bei Null zu beginnen.

Das Team hat mehrere Arbeitslinien mit Tech geteilt, um sie heute bei TC Sessions: Robotics zu zeigen, und im Video unten können Sie davon hören – zuerst von dem Berkeley-Forscher Stephen James.

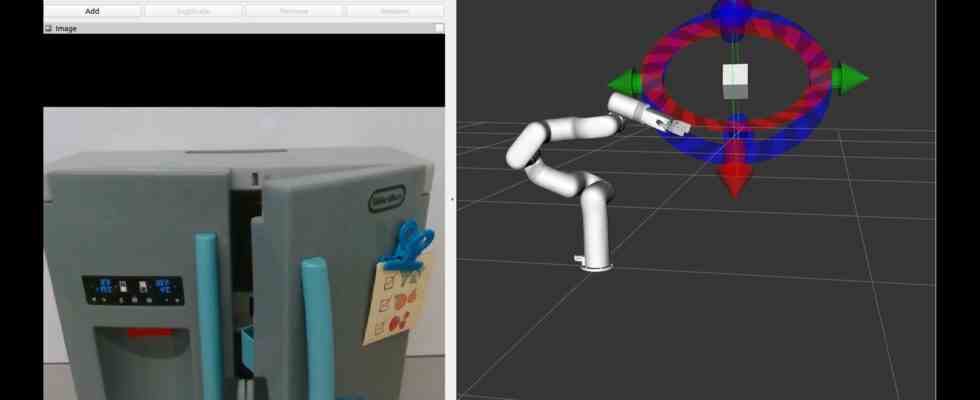

„Die Technik, die wir verwenden, ist eine Art kontrastives Lernsystem, bei dem das YouTube-Video aufgenommen und eine Reihe von Bereichen ausgebessert wird, und die Idee dahinter ist, dass der Roboter dann versucht, dieses Bild zu rekonstruieren“, sagt James erklärt. „Es muss verstehen, was in diesen Patches sein könnte, um dann eine Vorstellung davon zu entwickeln, was dahinter sein könnte, es muss ein wirklich gutes Verständnis dafür bekommen, was in der Welt vor sich geht.“

Natürlich lernt es nicht nur durch das Anschauen von YouTube, so üblich das in der Menschenwelt ist. Die Bediener müssen den Roboter selbst bewegen, entweder physisch oder über einen VR-Controller, um ihm eine allgemeine Vorstellung davon zu geben, was er zu tun versucht. Es kombiniert diese Informationen mit seinem breiteren Verständnis der Welt, das durch das Ausfüllen der Videobilder gewonnen wird, und kann schließlich auch viele andere Quellen integrieren.

Der Ansatz zeigt bereits Ergebnisse, sagte James: „Normalerweise kann es manchmal Hunderte von Demos erfordern, um eine neue Aufgabe auszuführen, während wir jetzt eine Handvoll Demos geben können, vielleicht zehn, und es kann die Aufgabe ausführen.“

Alejandro Escontrela ist spezialisiert auf die Entwicklung von Modellen, die relevante Daten aus YouTube-Videos extrahieren, etwa Bewegungen von Tieren, Menschen oder anderen Robotern. Der Roboter verwendet diese Modelle, um sein eigenes Verhalten zu informieren und zu beurteilen, ob eine bestimmte Bewegung wie etwas erscheint, das er ausprobieren sollte oder nicht.

Letztendlich versucht es, Bewegungen aus den Videos so nachzubilden, dass ein anderes Modell, das sie beobachtet, nicht erkennen kann, ob es sich um einen Roboter oder einen echten deutschen Schäferhund handelt, der diesem Ball nachjagt.

Interessanterweise lernen viele solcher Roboter zuerst in einer Simulationsumgebung und testen Bewegungen im Wesentlichen in VR. Aber wie Danijar Hafner erklärt, sind die Prozesse so effizient geworden, dass sie diesen Test überspringen können, den Roboter in der realen Welt toben lassen und live aus Interaktionen wie Gehen, Stolpern und natürlich Schubsen lernen. Der Vorteil dabei ist, dass es während der Arbeit lernen kann, anstatt zum Simulator zurückkehren zu müssen, um neue Informationen zu integrieren, was die Aufgabe weiter vereinfacht.

Ich denke, der heilige Gral des Roboterlernens besteht darin, so viel wie möglich in der realen Welt und so schnell wie möglich zu lernen“, sagte Hafner. Sie scheinen sich auf dieses Ziel zuzubewegen. Sehen Sie sich hier das vollständige Video der Arbeit des Teams an.