Während Unternehmen von der Erprobung generativer KI in begrenzten Prototypen zur Serienreife übergehen, werden sie immer preisbewusster. Die Verwendung großer Sprachmodelle ist schließlich nicht billig. Eine Möglichkeit, die Kosten zu senken, besteht darin, zu einem alten Konzept zurückzukehren: dem Caching. Eine andere Möglichkeit besteht darin, einfachere Abfragen an kleinere, kosteneffizientere Modelle weiterzuleiten. Auf seiner re:invent-Konferenz in Las Vegas kündigte AWS heute beide Funktionen für seinen Bedrock LLM-Hosting-Service an.

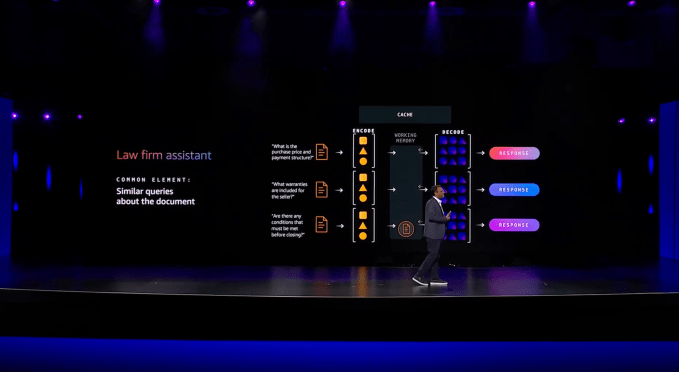

Lassen Sie uns zunächst über den Caching-Dienst sprechen. „Angenommen, es gibt ein Dokument und mehrere Personen stellen Fragen zu demselben Dokument. Jedes Mal, wenn Sie bezahlen“, sagte mir Atul Deo, der Produktdirektor von Bedrock. „Und diese Kontextfenster werden immer länger. Bei Nova zum Beispiel werden wir 300.000 haben [tokens of] Kontext und 2 Millionen [tokens of] Kontext. Ich denke, bis zum nächsten Jahr könnte es sogar noch viel höher gehen.“

Caching stellt im Wesentlichen sicher, dass Sie nicht dafür bezahlen müssen, dass das Modell sich wiederholende Arbeiten ausführt und dieselben (oder im Wesentlichen ähnlichen) Abfragen immer wieder erneut verarbeitet. Laut AWS können dadurch die Kosten um bis zu 90 % gesenkt werden, aber ein weiterer Nebeneffekt davon ist auch, dass die Latenz für die Antwort vom Modell deutlich geringer ist (laut AWS um bis zu 85 %). Adobe, das Prompt Caching für einige seiner generativen KI-Anwendungen auf Bedrock testete, konnte eine Reduzierung der Reaktionszeit um 72 % feststellen.

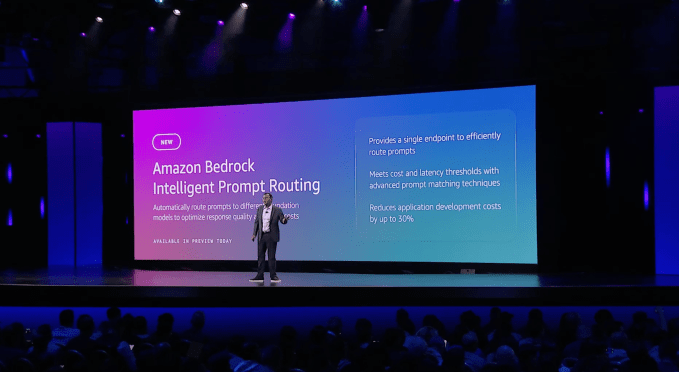

Die andere wichtige neue Funktion ist das intelligente Prompt-Routing für Bedrock. Damit kann Bedrock Eingabeaufforderungen automatisch an verschiedene Modelle derselben Modellfamilie weiterleiten, um Unternehmen dabei zu helfen, das richtige Gleichgewicht zwischen Leistung und Kosten zu finden. Das System sagt automatisch voraus (unter Verwendung eines kleinen Sprachmodells), wie jedes Modell bei einer bestimmten Abfrage funktionieren wird, und leitet die Anfrage dann entsprechend weiter.

„Manchmal kann meine Anfrage sehr einfach sein. Muss ich diese Anfrage wirklich an das leistungsfähigste Modell senden, was extrem teuer und langsam ist? Wahrscheinlich nicht. Im Grunde möchten Sie also die Vorstellung entwickeln: „Senden Sie zur Laufzeit, basierend auf der eingehenden Eingabeaufforderung, die richtige Abfrage an das richtige Modell“, erklärte Deo.

LLM-Routing ist natürlich kein neues Konzept. Startups mögen Marsianer und eine Reihe von Open-Source-Projekten befassen sich ebenfalls mit diesem Problem, aber AWS würde wahrscheinlich argumentieren, dass das Besondere an seinem Angebot darin besteht, dass der Router Abfragen ohne große menschliche Eingaben intelligent leiten kann. Es gibt jedoch auch Einschränkungen, da Abfragen nur an Modelle derselben Modellfamilie weitergeleitet werden können. Langfristig plant das Team jedoch, dieses System zu erweitern und den Benutzern mehr Anpassbarkeit zu bieten, sagte mir Deo.

Schließlich startet AWS auch einen neuen Marktplatz für Bedrock. Die Idee dahinter, sagte Deo, ist, dass Amazon zwar mit vielen der größeren Modellanbieter zusammenarbeitet, es aber inzwischen Hunderte von spezialisierten Modellen gibt, die möglicherweise nur wenige dedizierte Benutzer haben. Da diese Kunden das Unternehmen um Unterstützung bitten, startet AWS einen Marktplatz für diese Modelle, bei dem der einzige große Unterschied darin besteht, dass Benutzer die Kapazität ihrer Infrastruktur selbst bereitstellen und verwalten müssen – etwas, das Bedrock normalerweise automatisch erledigt. Insgesamt wird AWS etwa 100 dieser aufstrebenden und spezialisierten Modelle anbieten, weitere werden folgen.