Am Montag stellte Apple auf der WWDC 2024 Apple Intelligence vor, seinen lang erwarteten, ökosystemweiten Vorstoß in die generative KI. Wie frühere Gerüchte vermuten ließen, heißt die neue Funktion Apple Intelligence (KI, verstehen Sie?). Das Unternehmen versprach, dass die Funktion mit dem Schwerpunkt auf Sicherheit sowie hochgradig personalisierten Erfahrungen entwickelt wird.

„Am wichtigsten ist, dass es Sie versteht und in Ihrem persönlichen Kontext verankert ist, wie Ihrem Tagesablauf, Ihren Beziehungen, Ihrer Kommunikation und mehr“, bemerkte CEO Tim Cook. „Und natürlich muss es von Grund auf mit Privatsphäre ausgestattet sein. All das geht über künstliche Intelligenz hinaus. Es ist persönliche Intelligenz und der nächste große Schritt für Apple.“

Das Unternehmen hat die Funktion als integralen Bestandteil aller seiner verschiedenen Betriebssystemangebote vorangetrieben, darunter iOS, macOS und das neueste, visionOS.

„Es muss leistungsstark genug sein, um Ihnen bei den Dingen zu helfen, die Ihnen am wichtigsten sind“, sagte Cook. „Es muss intuitiv und einfach zu bedienen sein. Es muss tief in Ihre Produkterfahrungen integriert sein. Am wichtigsten ist, dass es Sie versteht und in Ihrem persönlichen Kontext verankert ist, wie Ihrer Routine, Ihren Beziehungen, Ihrer Kommunikation und mehr, und natürlich muss es von Grund auf mit Privatsphäre ausgestattet sein. Gemeinsam. All dies geht über künstliche Intelligenz hinaus. Es ist persönliche Intelligenz und der nächste große Schritt für Apple.“

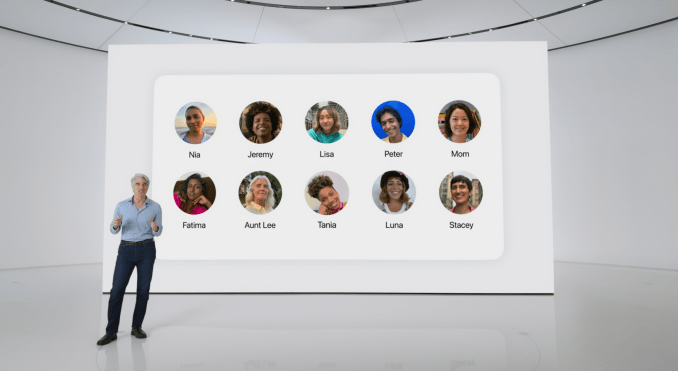

SVP Craig Federighi fügte hinzu: „Apple Intelligence basiert auf Ihren persönlichen Daten und Ihrem Kontext.“ Die Funktion wird effektiv auf allen persönlichen Daten aufbauen, die Benutzer in Anwendungen wie Kalender und Karten eingeben.

Das System basiert auf großen Sprach- und Intelligenzmodellen. Ein Großteil dieser Verarbeitung erfolgt laut dem Unternehmen lokal und nutzt die neueste Version von Apple Silicon. „Viele dieser Modelle laufen vollständig auf dem Gerät“, behauptete Federighi während der Veranstaltung.

Allerdings haben diese Verbrauchersysteme immer noch Einschränkungen. Ein Teil der Schwerstarbeit muss daher außerhalb des Geräts in der Cloud erledigt werden. Apple erweitert das Angebot um Private Cloud Compute. Das Backend verwendet Dienste, auf denen Apple-Chips laufen, um den Datenschutz für diese höchst persönlichen Daten zu erhöhen.

Apple Intelligence enthält außerdem das wahrscheinlich größte Update für Siri seit seiner Ankündigung vor über einem Jahrzehnt. Das Unternehmen sagt, die Funktion sei „tiefer in seine Betriebssysteme integriert“. Im Fall von iOS bedeutet das, dass das bekannte Siri-Symbol durch einen blau leuchtenden Rahmen ersetzt wird, der den Desktop während der Nutzung umgibt.

Siri ist nicht mehr nur eine Sprachschnittstelle. Apple fügt außerdem die Möglichkeit hinzu, Abfragen direkt in das System einzugeben, um auf seine generative KI-basierte Intelligenz zuzugreifen. Dies ist ein Eingeständnis, dass die Sprache oft nicht die beste Schnittstelle für diese Systeme ist.

App Intents bietet unterdessen die Möglichkeit, den Assistenten direkter in verschiedene Apps zu integrieren. Dies beginnt mit Erstanbieteranwendungen, aber das Unternehmen wird auch den Zugriff für Drittanbieter ermöglichen. Diese Ergänzung wird die Möglichkeiten, die Siri direkt nutzen kann, dramatisch verbessern.

Das Angebot wird auch Multitasking in großem Umfang ermöglichen und eine Art anwendungsübergreifende Kompatibilität ermöglichen. Das bedeutet zum Beispiel, dass Benutzer nicht ständig zwischen Kalender, Mail und Maps wechseln müssen, um beispielsweise Besprechungen zu planen.

Apple Intelligence wird in die meisten Apps des Unternehmens integriert. Dazu gehört beispielsweise die Möglichkeit, beim Verfassen von Nachrichten in Mail (zusammen mit Apps von Drittanbietern) zu helfen oder einfach Smart Replies zum Antworten zu verwenden. Dies ist insbesondere eine Funktion, die Google seit einiger Zeit in Gmail anbietet und mithilfe seines eigenen generativen KI-Modells Gemini weiter ausgebaut hat.

Das Unternehmen bringt die Funktion sogar mit Genmoji (ja, so heißt es) in Emojis. Die Funktion verwendet ein Textfeld, um benutzerdefinierte Emojis zu erstellen. Image Playground ist ein geräteinterner Bildgenerator, der in Apps wie Messages, Keynote, Pages und Freeform integriert ist. Apple bringt außerdem eine eigenständige Image Playground-App für iOS heraus und ermöglicht den Zugriff auf das Angebot über eine API.

Image Wand ist ein neues Tool für den Apple Pencil, mit dem Benutzer Text einkreisen können, um ein Bild zu erstellen. Im Grunde ist es Apples Version von Googles Circle to Search, nur eben mit Fokus auf Bildern.

Es wurde auch eine Suchfunktion für Inhalte wie Fotos und Videos entwickelt. Das Unternehmen verspricht mehr Suchfunktionen in natürlicher Sprache innerhalb dieser Anwendungen. Die GenAI-Modelle erleichtern auch das Erstellen von Diashows in Fotos, wobei wiederum natürliche Spracheingaben verwendet werden. Apple Intelligence wird für die neuesten Versionen seiner Betriebssysteme eingeführt, darunter iOS und iPadOS 18, macOS Sequoia und visionOS 2. Es ist mit diesen Updates kostenlos verfügbar.

Die Funktion wird auf iPhone 15 Pro- und M1-Mac- und iPad-Geräten verfügbar sein. Das Standard-iPhone 15 wird diese Funktion wahrscheinlich aufgrund von Chipeinschränkungen nicht erhalten.

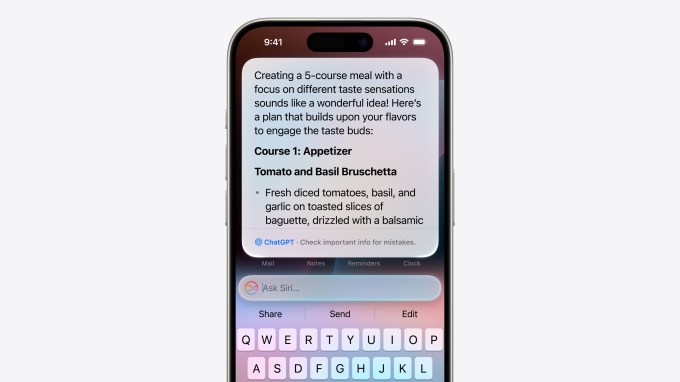

Wie erwartet hat Apple auch eine Partnerschaft mit OpenAI angekündigt, die ChatGPT in Angebote wie Siri einbindet. Die auf GPT 4.0 basierende Funktion nutzt die Bild- und Textgenerierung des Unternehmens. Das Angebot bietet Benutzern Zugriff, ohne dass sie sich für ein Konto anmelden oder eine Gebühr zahlen müssen (sie können jedoch immer noch auf Premium upgraden).

Das kommt später in diesem Jahr für iOS, iPadOS und macOS. Das Unternehmen sagt, dass es auch die Integration in andere LLMs von Drittanbietern einführen wird, gab jedoch nicht viele Details bekannt. Es scheint wahrscheinlich, dass Googles Gemini ganz oben auf dieser Liste steht.