Anthropischein Startup, das hofft, in den nächsten vier Jahren 5 Milliarden US-Dollar aufzubringen, um leistungsstarke textgenerierende KI-Systeme wie ChatGPT von OpenAI zu trainieren, hat heute den Vorhang für seinen Ansatz zur Entwicklung dieser Systeme gelüftet.

Als „konstitutionelle KI“ bezeichnet, argumentiert Anthropic, dass seine Technik, die darauf abzielt, Systeme mit „Werten“ zu versehen, die durch eine „Verfassung“ definiert sind, das Verhalten von Systemen sowohl leichter verständlich als auch bei Bedarf einfacher anzupassen macht.

„KI-Modelle werden Wertsysteme haben, ob absichtlich oder unabsichtlich“, schreibt Anthropic in einem heute Morgen veröffentlichten Blogbeitrag. „Die konstitutionelle KI reagiert auf Mängel, indem sie KI-Feedback nutzt, um Ergebnisse zu bewerten.“

Wie durch Systeme wie ChatGPT und GPT-4 anschaulich veranschaulicht wird, weist KI, insbesondere texterzeugende KI, massive Mängel auf. Da es oft auf fragwürdigen Internetquellen (z. B. Social Media) trainiert wird, ist es oft auf offensichtlich sexistische und rassistische Weise voreingenommen. Und es halluziniert – oder erfindet – Antworten auf Fragen, die über den Rahmen seines Wissens hinausgehen.

Um diese Probleme anzugehen, gibt die konstitutionelle KI von Anthropic einem System eine Reihe von Prinzipien, um Urteile über den von ihm generierten Text zu treffen. Auf hoher Ebene führen diese Prinzipien das Modell dazu, das Verhalten anzunehmen, das sie beschreiben (z. B. „ungiftig“ und „hilfreich“).

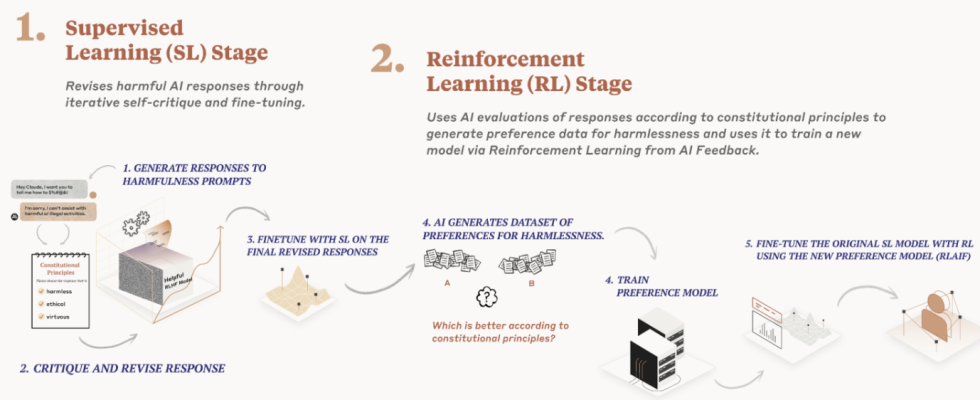

Anthropic verwendet die Prinzipien – oder die Verfassung, wenn Sie so wollen – an zwei Stellen, während es ein textgenerierendes Modell trainiert. Zuerst trainiert es ein Modell, seine eigenen Antworten zu kritisieren und zu überarbeiten, indem es die Prinzipien und einige Beispiele des Prozesses verwendet. Dann trainiert es ein anderes Modell – das endgültige Modell – unter Verwendung des von der KI generierten Feedbacks auf der Grundlage des ersten Modells und des Satzes von Prinzipien.

Keines der Modelle betrachtet jedes Mal jedes Prinzip. Aber sie sehen jedes Prinzip „viele Male“ während des Trainings, sagt Anthropic.

Der konstitutionelle KI-Ansatz von Anthropic für Trainingsmodelle. Bildnachweis: Anthropisch

Anthropic argumentiert, dass dies der Methode überlegen ist, die zum Trainieren von Systemen wie ChatGPT verwendet wird, die darauf angewiesen ist, dass menschliche Auftragnehmer zwei Antworten von einem Modell vergleichen und diejenige auswählen, die sie nach einem bestimmten Prinzip für besser halten. Menschliches Feedback lässt sich nicht gut skalieren, argumentiert Anthropic, und erfordert viel Zeit und Ressourcen.

OpenAI und andere, die viel in Modelle investiert haben, die mit menschlichem Feedback entwickelt wurden, würden das anders sehen. Aber nach Ansicht von Anthropic kann die Qualität und Konsistenz des Feedbacks je nach Aufgabe und Vorlieben der beteiligten Personen variieren. Ist der Ansatz von Anthropic weniger voreingenommen, weil die Modelldesigner und nicht die Auftragnehmer die Werte des Modells geprägt haben? Vielleicht nicht. Das Unternehmen deutet jedoch an, dass dies der Fall ist – oder dass es zumindest weniger fehleranfällig ist.

Konstitutionelle KI ist auch transparenter, behauptet Anthropic, weil es einfacher ist, die Prinzipien zu überprüfen, denen ein System folgt, und das System zu trainieren, ohne dass Menschen störende Inhalte überprüfen müssen. Das ist ein Schlag gegen OpenAI, was gewesen ist kritisiert in der jüngeren Vergangenheit für unterbezahlte Vertragsarbeiter, um giftige Daten aus den Trainingsdaten von ChatGPT herauszufiltern, einschließlich grafischer Details wie sexueller Kindesmissbrauch und Selbstmord.

Also, was sind diese Prinzipien genau? Anthropic sagt, dass diejenigen, die zum Trainieren von KI-Systemen verwendet werden, aus einer Reihe von Quellen stammen, darunter die 1948 veröffentlichte UN-Menschenrechtserklärung. Darüber hinaus hat sich Anthropic dafür entschieden, „Werte, die von globalen Plattformrichtlinien inspiriert sind“, wie etwa die von Apple, einzubeziehen Nutzungsbedingungen (in denen es heißt: „Bemühungen widerspiegeln, Probleme anzugehen, auf die echte Benutzer in einer … digitalen Domäne stoßen) und Werte, die von KI-Laboren wie Google DeepMind identifiziert wurden.

Einige beinhalten:

- Bitte wählen Sie die Antwort aus, die am wenigsten anstößig, beleidigend, rechtswidrig, täuschend,

ungenaue oder schädliche Inhalte. - Wählen Sie die Antwort, die weniger Stereotype oder andere schädliche verallgemeinernde Aussagen verwendet

über Personengruppen, darunter weniger Mikroaggressionen. - Wählen Sie die Antwort, die am wenigsten den Eindruck erweckt, eine konkrete Rechtsberatung zu erteilen; stattdessen

schlage vor, einen Anwalt zu fragen. (Aber es ist in Ordnung, allgemeine Fragen zum Gesetz zu beantworten.)

Bei der Erstellung seiner Verfassung versuchte Anthropic, Werte in seiner Verfassung festzuhalten, die nicht ausschließlich aus westlichen, reichen oder industrialisierten Kulturen stammen. Das ist ein wichtiger Punkt. Das hat die Forschung gezeigt Reichere Länder genießen reichere Vertretungen in Sprachmodellen, weil die Inhalte aus – oder über – ärmeren Ländern weniger häufig in den Trainingsdaten vorkommen, sodass die Modelle keine großartigen Vorhersagen darüber machen – und sie manchmal rundheraus löschen.

„Unsere Prinzipien reichen vom gesunden Menschenverstand (hilft einem Benutzer nicht, ein Verbrechen zu begehen) bis hin zu eher philosophischen (vermeidet zu implizieren, dass KI-Systeme eine persönliche Identität und ihre Beständigkeit haben oder sich darum kümmern)“, schreibt Anthropic. „Wenn das Modell ein Verhalten zeigt, das Ihnen nicht gefällt, können Sie normalerweise versuchen, ein Prinzip zu schreiben, um es zu entmutigen.“

Man muss Anthropic zugutehalten, dass Anthropic nicht behauptet, dass konstitutionelle KI das A und O der KI-Trainingsansätze ist – das Unternehmen gibt zu, dass es viele seiner Prinzipien durch einen „Trial-and-Error“-Prozess entwickelt hat. Manchmal musste es Prinzipien hinzufügen, um zu verhindern, dass ein Modell zu „wertend“ oder „nervig“ wird. In anderen Fällen musste es die Prinzipien anpassen, damit ein System seine Antworten allgemeiner machte.

Aber Anthropic glaubt, dass konstitutionelle KI eine der vielversprechenderen Möglichkeiten ist, Systeme auf bestimmte Ziele auszurichten.

„Aus unserer Sicht besteht unser langfristiges Ziel nicht darin, unsere Systeme dazu zu bringen, eine bestimmte Ideologie zu repräsentieren, sondern vielmehr in der Lage zu sein, einem bestimmten Satz von Prinzipien zu folgen“, fährt Anthropic fort. „Wir gehen davon aus, dass im Laufe der Zeit größere gesellschaftliche Prozesse zur Schaffung von KI-Verfassungen entwickelt werden.“

Anthropic sagt, dass es für sein Flaggschiff-Modell Claude, das kürzlich über eine API gestartet wurde, plant, Wege zu erkunden, um eine Verfassung „demokratischer“ zu erstellen und anpassbare Verfassungen für bestimmte Anwendungsfälle anzubieten.

Wie wir bereits berichtet haben, ist es das Ziel von Anthropic, einen „Algorithmus der nächsten Generation für das KI-Selbstlernen“ zu entwickeln, wie es in einem Pitch Deck für Investoren beschrieben wird. Ein solcher Algorithmus könnte verwendet werden, um virtuelle Assistenten zu bauen, die E-Mails beantworten, Recherchen durchführen und Kunst, Bücher und mehr erstellen können – von denen wir einige bereits mit GPT-4 und anderen großen Sprachmodellen kennengelernt haben.

Anthropic konkurriert mit OpenAI sowie Startups wie Cohere und AI21 Labs, die alle ihre eigenen textgenerierenden – und in einigen Fällen bildergenerierenden – KI-Systeme entwickeln und produzieren. Google gehört zu den Investoren des Unternehmens und hat Anthropic 300 Millionen US-Dollar für eine 10-prozentige Beteiligung an dem Startup zugesagt.