Auf der MAX, seiner jährlichen Konferenz für Kreative, gab Adobe heute bekannt, dass es die leistungsstarken Modelle aktualisiert hat Glühwürmchen, sein generativer KI-Bilderstellungsdienst. Laut Adobe wird das Firefly Image 2-Modell, wie es offiziell heißt, beispielsweise Menschen besser darstellen können, einschließlich Gesichtszügen, Haut, Körper und Händen (die ähnliche Modelle lange Zeit verärgert haben).

Adobe gab heute außerdem bekannt, dass die Benutzer von Firefly seit dem Start des Dienstes vor etwa einem halben Jahr mittlerweile drei Milliarden Bilder generiert haben, davon allein eine Milliarde im letzten Monat. Die überwiegende Mehrheit der Firefly-Benutzer (90 %) ist auch neu bei Adobe-Produkten. Die Mehrheit dieser Benutzer nutzt sicherlich die Firefly-Web-App, was erklärt, warum das Unternehmen vor einigen Wochen beschlossen hat, die eigentliche Demo-Site für Firefly in einen vollwertigen Creative Cloud-Dienst umzuwandeln.

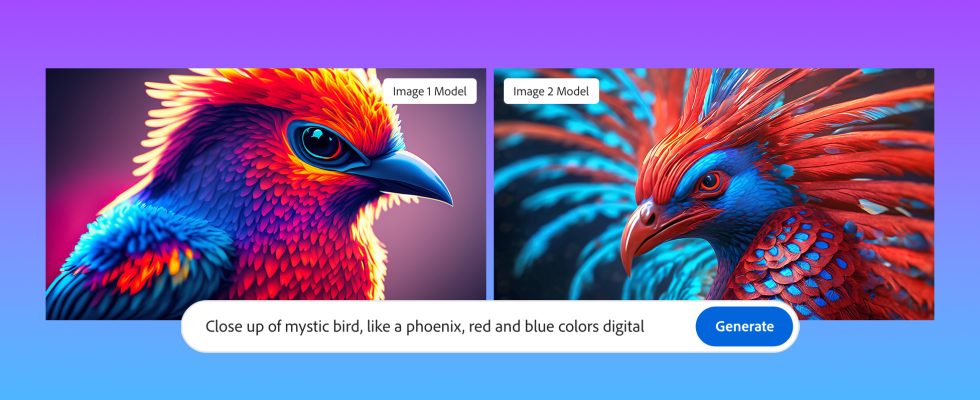

Bildnachweis: Adobe

Alexandru Costin, Adobes Vizepräsident für generative KI und Sensei, sagte mir, dass das neue Modell nicht nur auf neueren Bildern von Adobe Stock und anderen kommerziell sicheren Quellen trainiert wurde, sondern auch deutlich größer ist. „Firefly ist ein Ensemble aus mehreren Modellen und ich glaube, wir haben ihre Größe um den Faktor drei vergrößert“, sagte er mir. „Es ist also wie ein Gehirn, das dreimal größer ist und weiß, wie man diese Verbindungen herstellt und schönere Pixel und schönere Details für den Benutzer wiedergibt.“ Außerdem vergrößerte das Unternehmen den Datensatz um fast den Faktor zwei, was wiederum dem Modell ein besseres Verständnis dafür geben sollte, was die Nutzer verlangen.

Dieses größere Modell ist offensichtlich ressourcenintensiver, aber Costin wies darauf hin, dass es mit der gleichen Geschwindigkeit wie das erste Modell laufen sollte. „Wir setzen unsere Erkundungen und Investitionen in die Destillation, Bereinigung, Optimierung und Quantisierung fort. Es wird viel Arbeit investiert, um sicherzustellen, dass Kunden ein ähnliches Erlebnis haben, aber wir wollen die Cloud-Kosten nicht zu sehr in die Höhe treiben.“ Im Moment liegt der Fokus von Adobe jedoch auf Qualität statt auf Optimierung.

Das neue Modell wird vorerst über die Firefly-Web-App verfügbar sein, wird aber in naher Zukunft auch für Creative Cloud-Apps wie Photoshop verfügbar sein, wo es beliebte Funktionen wie generative Füllung unterstützt. Das hat auch Costin betont. Die Art und Weise, wie Adobe über generative KI denkt, betreffe nicht so sehr die Erstellung von Inhalten, sondern die generative Bearbeitung, sagte er.

„Was wir bei unseren Kunden gesehen haben, und das ist der Grund, warum die generative Füllung in Photoshop so erfolgreich ist, besteht darin, nicht nur neue Assets zu generieren, sondern bestehende Assets – ein Fotoshooting, ein Produktshooting – zu übernehmen und dann generative Funktionen zu nutzen, um bestehende im Grunde zu verbessern Arbeitsabläufe. Deshalb nennen wir unseren Oberbegriff für die Definition von generativ mehr als generative Bearbeitung als nur Text-zu-Bild, weil wir glauben, dass dies für unsere Kunden wichtiger ist.“

Mit diesem neuen Modell führt Adobe auch einige neue Steuerelemente in der Firefly-Web-App ein, mit denen Benutzer nun die Schärfentiefe für ihre Bilder sowie Bewegungsunschärfe- und Sichtfeldeinstellungen festlegen können. Neu ist auch die Möglichkeit, ein vorhandenes Bild hochzuladen und Firefly dann den Stil dieses Bilds anpassen zu lassen, sowie eine neue Funktion zur automatischen Vervollständigung beim Schreiben Ihrer Eingabeaufforderungen (die laut Adobe optimiert ist, um Ihnen dabei zu helfen, ein besseres Bild zu erhalten). ).