Firefly, Adobes Familie generativer KI-Modelle, genießt unter Kreativen nicht den besten Ruf.

Insbesondere das Firefly-Bilderzeugungsmodell wurde verspottet enttäuschend Und fehlerhaft im Vergleich zu Midjourney, DALL-E 3 von OpenAI und anderen Konkurrenten, mit der Tendenz, Gliedmaßen und Landschaften zu verzerren und die Nuancen in Eingabeaufforderungen zu verpassen. Aber Adobe versucht, mit seinem Modell der dritten Generation, Firefly Image 3, Abhilfe zu schaffen, das diese Woche während der Max-London-Konferenz des Unternehmens veröffentlicht wird.

Das Modell, das jetzt in Photoshop (Beta) und der Web-App Firefly von Adobe verfügbar ist, erzeugt dank der Fähigkeit, längere, komplexere Eingabeaufforderungen und Szenen zu verstehen, „realistischere“ Bilder als sein Vorgänger (Bild 2) und dessen Vorgänger (Bild 1). sowie verbesserte Beleuchtungs- und Textgenerierungsfunktionen. Es sollte Dinge wie Typografie, Ikonografie, Rasterbilder und Strichzeichnungen genauer wiedergeben, sagt Adobe, und sei „deutlich“ besser in der Lage, dichte Menschenmengen und Menschen mit „detaillierten Merkmalen“ und „einer Vielzahl von Stimmungen und Ausdrücken“ darzustellen.

Was es wert ist, in meinem kurzen unwissenschaftlichen Test, Bild 3 tut scheint ein Fortschritt gegenüber Bild 2 zu sein.

Ich konnte Bild 3 nicht selbst ausprobieren. Aber Adobe PR hat ein paar Ausgaben und Eingabeaufforderungen vom Modell gesendet, und es ist mir gelungen, dieselben Eingabeaufforderungen über Bild 2 im Internet auszuführen, um Beispiele zu erhalten, mit denen ich die Ausgaben von Bild 3 vergleichen kann. (Denken Sie daran, dass die Ausgaben von Bild 3 ausgewählt worden sein könnten.)

Beachten Sie die Beleuchtung in diesem Porträtfoto aus Bild 3 im Vergleich zu dem Bild darunter aus Bild 2:

Aus Bild 3. Eingabeaufforderung: „Studioporträt einer jungen Frau.“

Dieselbe Eingabeaufforderung wie oben aus Bild 2.

Die Ausgabe von Bild 3 sieht für meine Augen detaillierter und lebensechter aus, mit Schatten und Kontrasten, die im Beispiel von Bild 2 weitgehend fehlen.

Hier ist eine Reihe von Bildern, die das Szenenverständnis von Bild 3 zeigen:

Aus Bild 3. Eingabeaufforderung: „Eine Künstlerin sitzt in ihrem Atelier am Schreibtisch und sieht nachdenklich und ätherisch aus, umgeben von unzähligen Gemälden.“

Gleiche Eingabeaufforderung wie oben. Aus Bild 2.

Beachten Sie, dass das Beispiel von Bild 2 im Vergleich zur Ausgabe von Bild 3 hinsichtlich des Detaillierungsgrades und der allgemeinen Ausdruckskraft recht einfach ist. Das Motiv im Hemd des Beispiels von Bild 3 (im Taillenbereich) ist etwas seltsam, aber die Pose ist komplexer als die des Motivs von Bild 2. (Und die Kleidung von Bild 2 sieht auch etwas anders aus.)

Einige der Verbesserungen von Image 3 lassen sich zweifellos auf einen größeren und vielfältigeren Trainingsdatensatz zurückführen.

Wie Bild 2 und Bild 1 ist Bild 3 auf Uploads zu trainiert Adobe Stock, die lizenzfreie Medienbibliothek von Adobe, zusammen mit lizenzierten und gemeinfreien Inhalten, deren Urheberrecht abgelaufen ist. Adobe Stock wächst ständig und damit auch der verfügbare Trainingsdatensatz.

Um Klagen abzuwehren und sich als „ethischere“ Alternative zu Anbietern generativer KI zu positionieren, die wahllos auf Bildern trainieren (z. B. OpenAI, Midjourney), hat Adobe ein Programm zur Bezahlung von Adobe Stock-Mitwirkenden am Trainingsdatensatz eingeführt. (Wir weisen jedoch darauf hin, dass die Bedingungen des Programms eher undurchsichtig sind.) Umstritten ist, dass Adobe Firefly-Modelle auch auf KI-generierten Bildern trainiert, was manche als eine Form der Datenwäsche betrachten.

Aktuelle Bloomberg Berichterstattung enthüllte, dass KI-generierte Bilder in Adobe Stock nicht von den Trainingsdaten der bildgenerierenden Firefly-Modelle ausgeschlossen sind, eine besorgniserregende Aussicht, wenn man bedenkt, dass diese Bilder möglicherweise Folgendes enthalten wiedergewonnenes urheberrechtlich geschütztes Material. Adobe hat die Praxis verteidigt und behauptet, dass KI-generierte Bilder nur einen kleinen Teil seiner Trainingsdaten ausmachen und einen Moderationsprozess durchlaufen, um sicherzustellen, dass sie keine Marken oder erkennbaren Zeichen darstellen oder auf Künstlernamen verweisen.

Natürlich garantieren weder vielfältige, eher „ethisch“ gewonnene Trainingsdaten noch Inhaltsfilter und andere Sicherheitsvorkehrungen ein vollkommen fehlerfreies Erlebnis – siehe Benutzergenerierung Leute, die den Vogel umdrehen mit Bild 2. Der eigentliche Test von Bild 3 wird kommen, sobald die Community es in die Hände bekommt.

Neue KI-gestützte Funktionen

Image 3 ermöglicht mehrere neue Funktionen in Photoshop, die über die verbesserte Text-zu-Bild-Funktion hinausgehen.

Eine neue „Stil-Engine“ in Bild 3 sowie ein neuer automatischer Stilisierungsschalter ermöglichen es dem Modell, eine größere Auswahl an Farben, Hintergründen und Motivposen zu generieren. Sie werden in das Referenzbild eingespeist, eine Option, mit der Benutzer das Modell anhand eines Bildes konditionieren können, an dessen Farben oder Ton sie ihre künftig generierten Inhalte anpassen möchten.

Drei neue generative Tools – Hintergrund generieren, Ähnliches generieren und Details verbessern – nutzen Image 3, um präzise Bearbeitungen an Bildern vorzunehmen. Die (selbstbeschreibende) Funktion „Hintergrund generieren“ ersetzt einen Hintergrund durch einen generierten Hintergrund, der sich in das vorhandene Bild einfügt, während „Ähnliches generieren“ Variationen eines ausgewählten Teils eines Fotos (z. B. einer Person oder eines Objekts) bietet. Bei Enhance Detail werden Bilder „verfeinert“, um die Schärfe und Klarheit zu verbessern.

Wenn Ihnen diese Funktionen bekannt vorkommen, liegt das daran, dass sie sich seit mindestens einem Monat in der Betaversion der Firefly-Web-App befinden (und Midjourney schon viel länger). Dies ist ihr Photoshop-Debüt – in der Beta-Phase.

Apropos Web-App: Adobe vernachlässigt diesen alternativen Weg zu seinen KI-Tools nicht.

Zeitgleich mit der Veröffentlichung von Image 3 erhält die Firefly-Webanwendung Strukturreferenz und Stilreferenz, die Adobe als neue Möglichkeiten zur „Erweiterung der kreativen Kontrolle“ anpreist. (Beide wurden im März angekündigt, sind aber jetzt allgemein verfügbar.) Mit Structure Reference können Benutzer neue Bilder erstellen, die der „Struktur“ eines Referenzbilds entsprechen – beispielsweise einer Frontalansicht eines Rennwagens. Stilreferenz ist im Wesentlichen eine Stilübertragung unter einem anderen Namen, bei der der Inhalt eines Bildes (z. B. Elefanten in der afrikanischen Safari) erhalten bleibt und gleichzeitig der Stil (z. B. Bleistiftskizze) eines Zielbilds nachgeahmt wird.

Hier ist die Strukturreferenz in Aktion:

Original Bild.

Mit Strukturreferenz transformiert.

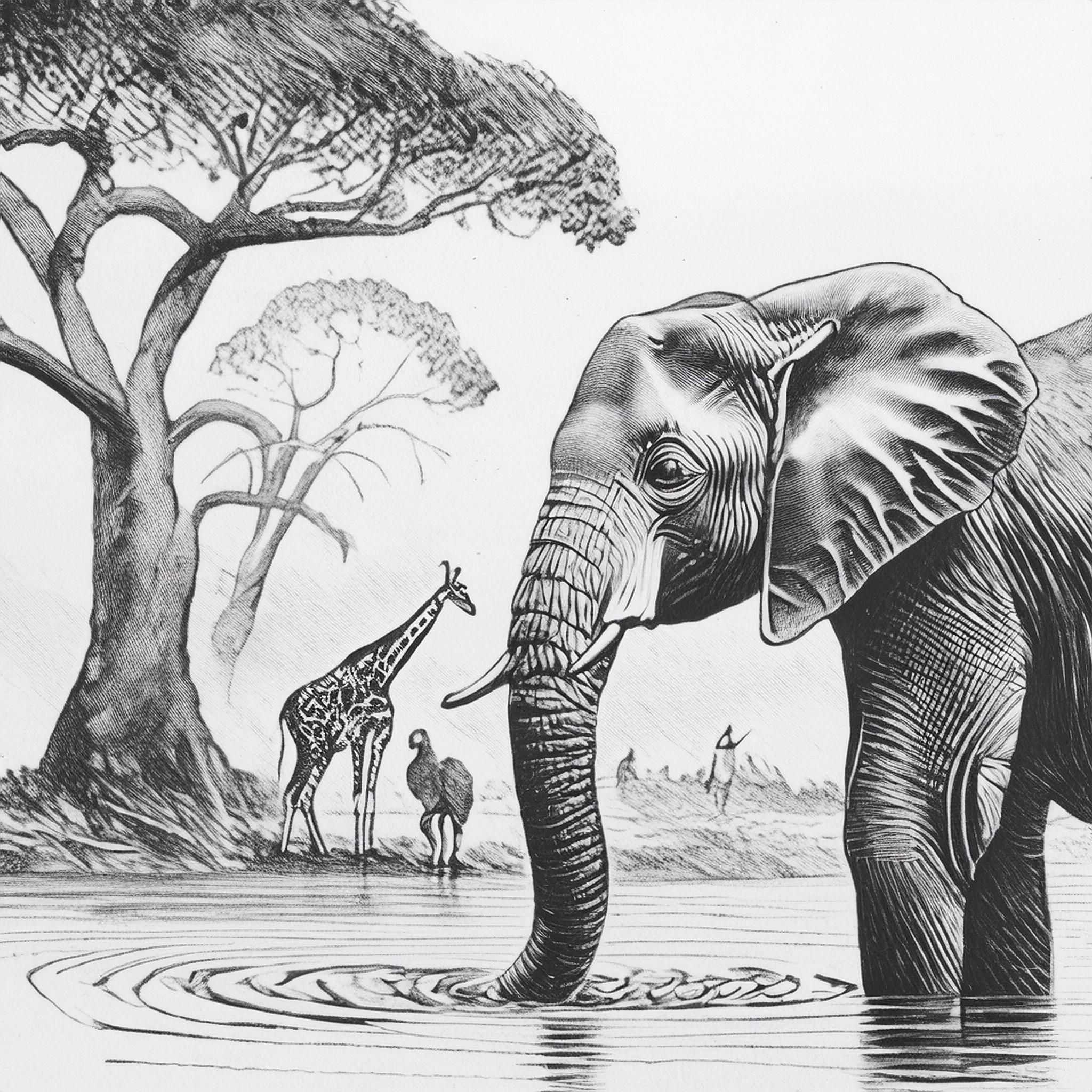

Und Stilreferenz:

Original Bild.

Mit Stilreferenz transformiert.

Ich habe Adobe gefragt, ob sich mit all den Upgrades die Preise für die Firefly-Bildgenerierung ändern würden. Derzeit kostet der günstigste Firefly-Premiumplan 4,99 US-Dollar pro Monat und liegt damit unter der Konkurrenz wie Midjourney (10 US-Dollar pro Monat) und OpenAI (wodurch DALL-E 3 hinter einem ChatGPT Plus-Abonnement für 20 US-Dollar pro Monat zurückbleibt).

Adobe sagte, dass seine aktuellen Stufen zusammen mit seinen vorerst bestehen bleiben Generatives Kreditsystem. Das Unternehmen sagte außerdem, dass sich seine Entschädigungsrichtlinie, die besagt, dass Adobe Urheberrechtsansprüche im Zusammenhang mit in Firefly generierten Werken begleichen wird, ebenfalls nicht ändern wird, ebenso wenig wie sein Ansatz zur Wasserzeichenmarkierung von KI-generierten Inhalten. Inhaltsnachweise – Metadaten zur Identifizierung KI-generierter Medien – werden weiterhin automatisch an alle Firefly-Bildgenerationen im Web und in Photoshop angehängt, unabhängig davon, ob sie von Grund auf neu erstellt oder teilweise mithilfe generativer Funktionen bearbeitet wurden.