Wir haben seit einiger Zeit eine aktive Geräuschunterdrückung in drahtlosen Ohrhörern, aber das kommt hauptsächlich der Person zugute, die die Kopfhörer trägt, um die Außenwelt zu übertönen. Wenn Sie am anderen Ende eines Telefonats mit jemandem telefoniert haben, der sie trägt, werden Sie feststellen, dass die Mikrofone noch viel mehr aufnehmen als die Stimme, auf die Sie achten möchten. Das ist, was das Open-Source-ClearBuds-Projekt versucht zu lösen, indem er der Mischung eine Schicht aus Deep-Learning und Audioverarbeitung hinzufügt.

Ich kann hier für ein paar tausend Worte schweifen (und ich könnte es immer noch), aber wenn ein Bild 1.000 Worte sagt, dann sagt ein 23-Sekunden-Video mit 30 FPS fast 700.000 Worte, und damit kann ich einfach nicht mithalten. Hör zu:

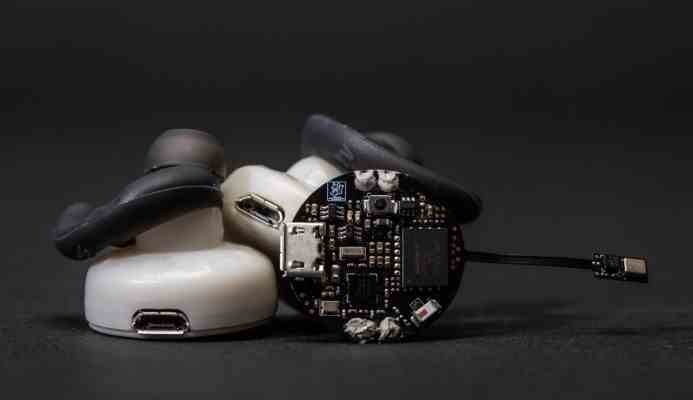

Das ClearBuds-Projekt ist das Ergebnis einer Forschungsinitiative von drei Forschern der University of Washington, die während der Pandemie Mitbewohner waren. Das System umfasst ein Mikrofonsystem und Systeme für maschinelles Lernen in Echtzeit, die auf einem Smartphone ausgeführt werden können.

Die meisten Ohrhörer verwenden nur das Audio von einem der Knospen, um Audio an das Telefon zu senden. Das ClearBuds-System sendet zwei Streams, die dann schnell genug analysiert und verarbeitet werden können, um für Live-Audio wie Video oder Telefonanrufe verwendet zu werden. Der Algorithmus des Teams unterdrückt alle Nicht-Sprachgeräusche und verstärkt dann die Stimme des Sprechers.

„ClearBuds unterscheiden sich von anderen drahtlosen Ohrhörern in zweierlei Hinsicht“, sagte Co-Hauptautorin Maruchi Kim, eine Doktorandin in der Paul G. Allen School of Computer Science & Engineering. „Erstens verwenden ClearBuds ein Dual-Mikrofon-Array. Mikrofone in jedem Ohrhörer erzeugen zwei synchronisierte Audioströme, die Informationen liefern und es uns ermöglichen, Geräusche aus verschiedenen Richtungen mit höherer Auflösung räumlich zu trennen. Zweitens verbessert das leichtgewichtige neuronale Netzwerk die Stimme des Sprechers weiter.“

„Da die Stimme des Sprechers in der Nähe und ungefähr gleich weit von den beiden Ohrhörern entfernt ist, kann das neuronale Netzwerk darauf trainiert werden, sich nur auf seine Sprache zu konzentrieren und Hintergrundgeräusche, einschließlich anderer Stimmen, zu eliminieren“, sagte Co-Hauptautor Ishan Chatterjee. „Diese Methode ist der Funktionsweise Ihrer eigenen Ohren sehr ähnlich. Sie verwenden den Zeitunterschied zwischen Geräuschen, die zu Ihrem linken und rechten Ohr kommen, um festzustellen, aus welcher Richtung ein Geräusch kam.“

Sehen Sie sich die vollständige Projektseite anund drücken Sie die Daumen, dass diese Technologie bald ihren Weg in einige Kopfhörer findet, denn ehrlich gesagt kann ich es kaum erwarten, keine Hunde bellen, Autos sausen und meine Nichte singen zu hören wir reden nicht über Bruno-nein-nein im Hintergrund. Okay, seien wir ehrlich, ich werde den Gesang vermissen. Alles andere kann aber gehen.