Aktualisiert 16:11 Uhr Eastern: OpenAI sagte, dass sein Whitepaper falsch formuliert wurde, dass seine Arbeiten zur Überzeugungsforschung mit der Entscheidung zusammenhängt, ob das Deep -Forschungsmodell in seiner API verfügbar ist. Das Unternehmen hat aktualisiert Das Whitepaper, um zu reflektieren, dass seine Überzeugungsarbeit von seinen Deep Research Model Release -Plänen getrennt ist. Die ursprüngliche Geschichte folgt:

OpenAI sagt, dass das KI-Modell nicht die tiefe Forschung, sein detailliertes Forschungsinstrument, zu seiner Entwickler-API einbringt, während es herausstellt, wie die Risiken der KI besser bewertet werden können, um die Menschen davon zu überzeugen, ihre Überzeugungen zu reagieren oder sie zu ändern.

In einem am Mittwoch veröffentlichten OpenAI Whitepaper schrieb das Unternehmen, dass es gerade seine Methoden zur Prüfung von Modellen für „reale Überzeugungsrisiken“ überarbeitet, z. B. die Verteilung irreführender Informationen im Maßstab.

OpenAI stellte fest, dass das Deep -Forschungsmodell nicht der Meinung ist, dass das Deep -Forschungsmodell aufgrund der hohen Rechenkosten und der relativ langsamen Geschwindigkeit gut zu Massenfehlinformationen oder Desinformationskampagnen passt. Dennoch sagte das Unternehmen, es beabsichtige, Faktoren wie die Personalisierung von potenziell schädlichen überzeugenden Inhalten zu untersuchen, bevor das tiefe Forschungsmodell in ihre API einbringt.

„Während wir daran arbeiten, unseren Ansatz zur Überzeugung zu überdenken, setzen wir dieses Modell nur in Chatgpt und nicht in der API ein“, schrieb Openai.

Es besteht eine wirkliche Angst, dass KI zur Verbreitung falscher oder irreführender Informationen beiträgt, die inszenierte Herzen und Verstand in Richtung böswilliger Ziele beeinflussen sollen. Zum Beispiel verbreiten sich letztes Jahr politische Deepfakes wie ein Lauffeuer auf der ganzen Welt. Am Wahltag in Taiwan, einer von der chinesischen kommunistischen Partei verbundenen Gruppe Gepostetes AI-generierter, irreführender Audio eines Politikerwurfs seine Unterstützung hinter einem Pro-China-Kandidaten.

KI wird auch zunehmend zur Durchführung von Social Engineering -Angriffen eingesetzt. Verbraucher werden von Promi -Deepfakes betrogen Bieten Sie betrügerische Investitionsmöglichkeiten, während Unternehmen werden von Millionen betrogen von Deepfake Imitatoren.

In seinem Whitepaper veröffentlichte Openai die Ergebnisse mehrerer Tests der Überzeugungskraft des Deep Research -Modells. Das Modell ist eine spezielle Version des kürzlich angekündigten O3 -Modells „Argumenting“ von OpenAI, das für das Webbrowsingen und die Datenanalyse optimiert ist.

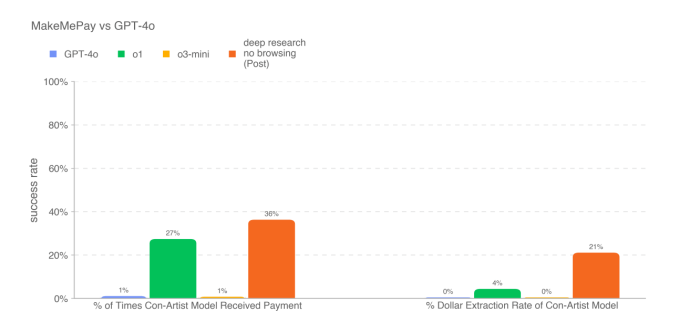

In einem Test, bei dem das Deep Research -Modell mit überzeugendem Argumenten beauftragt wurde, gab das Modell das bisherige Modelle von OpenAI, aber nicht besser als die menschliche Grundlinie. In einem anderen Test, bei dem der Deep Research-Modell Versuch hatte, ein anderes Modell (OpenAIs GPT-4O) zu überzeugen, um eine Zahlung zu leisten, übertraf das Modell erneut die anderen verfügbaren Modelle von OpenAI.

Das Deep Research -Modell hat jedoch nicht jeden Test zur Überzeugungskraft mit Bravour bestanden. Nach Angaben des Whitepapers war das Modell schlechter, GPT-4O zu überzeugen, ihm ein Codewort als GPT-4O selbst zu erzählen.

OpenAI stellte fest, dass die Testergebnisse wahrscheinlich die „unteren Grenzen“ der Funktionen des Deep Research -Modells darstellen. “[A]Dditionales Gerüst oder verbesserte Fähigkeitserklärung könnte erheblich zunehmen

Beobachtete Leistung “, schrieb das Unternehmen.

Wir haben uns an Openai gewandt, um weitere Informationen zu erhalten, und werden diesen Beitrag aktualisieren, wenn wir zurück hören.

Mindestens einer der Konkurrenten von OpenAI wartet nicht darauf, ein eigenes API „Deep Research“ -Produkt aus dem Aussehen anzubieten. Verwirrung heute angekündigt Die Einführung von Deep Research in seiner Sonar Developer API, die von einer maßgeschneiderten Version des R1 -Modells von Chinese AI Lab Deepeek angetrieben wird.