Anthropic veröffentlicht ein neues Frontier -KI -Modell namens Claude 3.7 Sonnet, das das Unternehmen so lange über Fragen „nachdenken“, so lange wie Benutzer dies wünschen.

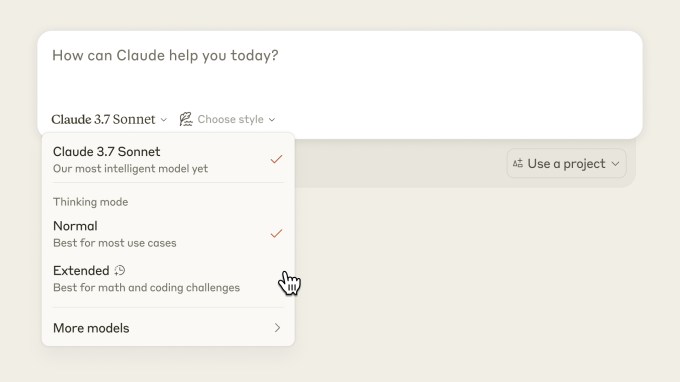

Anthropic nennt Claude 3.7 Sonnet das erste „Hybrid-KI-Argumentationsmodell“ der Branche, da es sich um ein einzelnes Modell handelt, das sowohl Echtzeitantworten als auch überlegte, dass sie überlegt werden können, Antworten auf Fragen. Benutzer können auswählen, ob die Fähigkeiten des KI -Modells aktiviert werden sollen, die Claude 3.7 -Sonett für einen kurzen oder langen Zeitraum „denken“.

Das Modell repräsentiert die breitere Anstrengung von Anthropic, um die Benutzererfahrung rund um seine KI -Produkte zu vereinfachen. Die meisten KI -Chatbots haben heute einen entmutigenden Modellpicker, der Benutzer dazu zwingt, aus verschiedenen Optionen zu wählen, die sich in Bezug auf Kosten und Fähigkeiten unterscheiden. Labors wie anthropisch würden Sie lieber nicht darüber nachdenken – idealerweise erledigt ein Modell die ganze Arbeit.

Claude 3.7 Sonett wird am Montag an alle Benutzer und Entwickler eingereicht, sagte Anthropic, aber nur Personen, die für die Premium -Claude -Chatbot -Pläne von Anthropic bezahlen, erhalten Zugriff auf die Argumentationsfunktionen des Modells. Free Claude-Benutzer erhalten die Standardversion von Claude 3.7 Sonnet, die die anthropischen Behauptungen sein früheres Frontier-KI-Modell Claude 3.5 Sonnet übertrifft. (Ja, das Unternehmen hat eine Nummer übersprungen.)

Claude 3.7 Sonett kostet 3 US -Dollar pro Million Eingangs -Token (dh Sie könnten ungefähr 750.000 Wörter, mehr Wörter als die gesamte „Lord of the Rings“ -Serie eingeben, in Claude für 3 US -Dollar) und 15 US -Dollar pro Million Output -Token. Das macht es teurer als Openai’s O3-Mini (1,10 USD pro 1 Million Input-Token/4,40 US O3-Mini und R1 sind streng argumentierende Modelle-keine Hybriden wie Claude 3.7 Sonett.

Claude 3.7 Sonett ist das erste KI -Modell von Anthropic, das „Vernunft“ kann. Eine Technik, die viele AI -Labors als traditionelle Methoden zur Verbesserung der KI -Leistung verjüngen haben.

Argumentation Modelle wie O3-Mini, R1, Google Gemini 2.0 Flash Thinking und Xais GROK 3 (denken) verwenden mehr Zeit und Rechenleistung, bevor Fragen beantwortet werden. Die Modelle unterteilen Probleme in kleinere Schritte, was die Genauigkeit der endgültigen Antwort tendenziell verbessern. Argumentationsmodelle denken oder argumentieren nicht wie ein Mensch, aber ihr Prozess wird nach dem Abzug modelliert.

Letztendlich möchte Anthropic Claude herausfinden, wie lange es über Fragen selbst nachdenken sollte, ohne dass Benutzer im Voraus Kontrollpersonen auswählen müssen, sagte Dianne Penn in einem Interview gegenüber Tech.

„Ähnlich wie Menschen haben keine zwei getrennten Gehirne für Fragen, die sofort beantwortet werden können, im Vergleich zu denen, die Gedanken erfordern“, schrieb Anthropic in a Blog -Beitrag Mit Tech geteilt: „Wir betrachten die Argumentation als einfach eine der Funktionen, die ein Grenzmodell musste, um reibungslos in andere Funktionen integriert zu sein, anstatt etwas, das in einem separaten Modell bereitgestellt werden muss.“

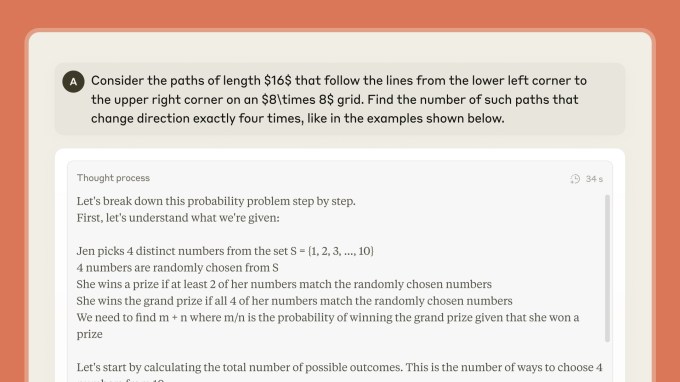

Anthropic sagt, dass es Claude 3.7 Sonett seine interne Planungsphase durch ein „sichtbares Kratzpad“ zeigt. Penn sagte gegenüber Tech, dass Benutzer den vollständigen Denkprozess von Claude für die meisten Aufforderungen sehen werden, aber einige Teile können aus Vertrauens- und Sicherheitszwecken reduziert werden.

Anthropic sagt, dass es die Denkmodi von Claude für reale Aufgaben wie schwierige Codierungsprobleme oder agierische Aufgaben optimiert habe. Entwickler, die die API von Anthropic tippen, können das „Budget“ für das Denken, die Handelsgeschwindigkeit und die Kosten für die Antwortqualität kontrollieren.

Bei einem Test zur Messung der realen Codierungsaufgaben war SWE-Bench Claude 3.7 Sonett 62,3% genau, verglichen mit OpenAs O3-Mini-Modell, das 49,3% erzielte. Bei einem anderen Test, um die Fähigkeit eines KI-Modells zu messen, mit simulierten Benutzern und externen APIs in einem Einzelhandelsumfeld zu interagieren, erzielte Tau-Bench, Claude 3.7 Sonnet 81,2%, verglichen mit dem O1-Modell von OpenAI, das 73,5%erzielte.

Anthropic sagt auch, dass Claude 3.7 Sonett die Beantwortung von Fragen seltener als seine früheren Modelle beantworten wird, und behauptet, das Modell sei in der Lage, differenziertere Unterscheidungen zwischen schädlichen und gutartigen Aufforderungen zu treffen. Anthropic sagt, dass es unnötige Ablehnungen im Vergleich zu Claude 3.5 Sonett um 45% reduziert hat. Dies kommt zu einer Zeit, in der einige andere KI -Labors ihren Ansatz überdenken, um die Antworten ihres KI -Chatbots einzuschränken.

Zusätzlich zu Claude 3.7 Sonnet veröffentlicht Anthropic auch ein agentisches Codierungs -Tool namens Claude Code. Mit dem Tool, der als Forschungsvorschau gestartet wird, ermöglicht es Entwicklern, spezifische Aufgaben über Claude direkt von ihrem Terminal auszuführen.

In einer Demo zeigten anthropische Mitarbeiter, wie Claude Code ein Codierungsprojekt mit einem einfachen Befehl wie, analysieren kann, analysieren kann. “Erklären Sie diese Projektstruktur. “ Mit einfachem Englisch in der Befehlszeile kann ein Entwickler eine Codebasis ändern. Claude Code beschreibt seine Änderungen, die Änderungen vornehmen, und testen sogar ein Projekt auf Fehler oder schieben es in ein Github -Repository.

Claude Code steht zunächst einer begrenzten Anzahl von Benutzern auf der Basis „First Come, First Serve“ zur Verfügung, sagte ein anthropischer Sprecher gegenüber Tech.

Anthropic veröffentlicht Claude 3.7 Sonett zu einer Zeit, in der KI -Labors neue KI -Modelle in einem spannenden Tempo versenden. Anthropic hat in der Vergangenheit einen methodischen, sicherheitsgereicherten Ansatz verfolgt. Aber diesmal versucht das Unternehmen, das Rudel zu führen.

Wie lange ist die Frage jedoch. Openai kann kurz vor der Veröffentlichung eines eigenen hybriden KI -Modells stehen; Sam Altman, CEO des Unternehmens, hat gesagt, dass es in „Monaten“ eintreffen wird.