Hiya, Leute, willkommen in TechCrunchs regulärem KI -Newsletter. Wenn Sie dies jeden Mittwoch in Ihrem Posteingang wollen, melden Sie sich hier an.

Die Milliardäre kämpfen wieder.

Am Montag bot Elon Musk, der reichste Mann der Welt, an, die gemeinnützige Organisation zu kaufen, die Openai effektiv für 97,4 Milliarden US -Dollar regiert. Als Reaktion auf das Angebot von Musk hat der OpenAI -CEO Sam Altman früher am Montag verfasst ein frecher Beitrag auf xSchreiben: „Nein, danke, aber wir werden Twitter für 9,74 Milliarden US -Dollar kaufen, wenn Sie wollen.“ (Musk und Investoren haben Twitter im Jahr 2022 für 44 Milliarden US -Dollar gekauft.)

Das Angebot von Musk, ernst oder nicht, kann OpenAIs Bemühungen, innerhalb von zwei Jahren zu einer gemeinnützigen öffentlichen Leistungsgesellschaft umzuwandeln, erschweren. Jetzt muss OpenAIS Vorstand nachweisen, dass es nicht unterverkauft wird, dass OpenAIs gemeinnützige Organisation die Vermögenswerte des gemeinnützigen Organisation, einschließlich IP von Openai’s Research, an einen Insider (z. B. Altman) für einen Rabatt überreicht.

Openai könnte dazu führen, dass Musks Angebot ein feindlicher Übernahmeversuch ist, da Musk und Altman sind nicht die besten Freunde. Es könnte auch argumentieren, dass Musks Angebot nicht glaubwürdig ist, da Openai bereits inmitten eines Umstrukturierungsprozesses liegt. Oder Openai könnte Fordern Sie Moschus heraus, ob er die Mittel hat.

In a Erklärung DienstagAndy Nussbaum, externer Anwalt, der Openai’s Board vertritt, sagte, dass Musks Angebot „keinen Wert für einen Wert für [OpenAI’s] gemeinnützig “und dass die gemeinnützige Organisation„ nicht zum Verkauf “ist. Nussbaum fügte hinzu: „Respektvoll ist es nicht an einem Konkurrenten, zu entscheiden, was im besten Interesse von OpenAIs Mission ist.“

Mein Kollege Maxwell Zeff und ich haben ein detaillierteres Stück darüber geschrieben, was in den kommenden Wochen zu erwarten ist. Aber garantiert, dass Musks Angebot – ganz zu schweigen von seiner laufenden Klage gegen Openai, was er behauptet, ein betrügerisches Verhalten ist – verspricht, für heftige Gerichtssaalschlägereien zu führen.

Nachricht

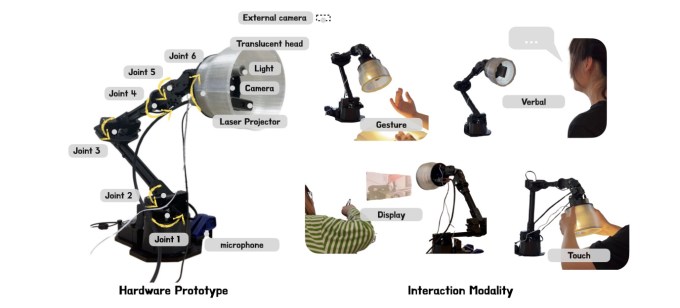

Apples neuer Roboter: Apple hat einen Forschungsroboter erstellt, der eine Seite aus Pixars Playbook nimmt. Die Roboterlampe des Unternehmens wird als kinetischere Version eines HomePod oder eines anderen intelligenten Lautsprechers fungiert. Die Person, die der Lampe gegenübersteht, fragt nach einer Frage, und der Roboter antwortet mit Siris Stimme.

Macht KI uns dumm ?: Forscher haben kürzlich eine Studie veröffentlicht, in der untersucht wurde, wie sich die Verwendung generativer KI bei der Arbeit auf kritische Denkfähigkeiten auswirkt. Es stellte fest, dass wir uns, wenn wir uns zu sehr auf KI verlassen, für uns nachzudenken, uns selbst verschlechtern, wenn wir Probleme selbst lösen, wenn KI versagt.

KI für alle vielleicht: In einem neuen Aufsatz in seinem persönlichen Blog gab Altman zu, dass die Vorteile von AI möglicherweise nicht weit verbreitet sind-und sagte, dass OpenAI offen für „seltsam klingende“ Ideen wie ein „Berechnenbudget“ ist, um „allen auf der Erde zu ermöglichen, viel zu verwenden, um viel zu verwenden, um viel zu verwenden, um viel zu verwenden Ai. “

Christies Kontroverse: Fine Art Auction House Christie’s hat zuvor mit Ai-generierte Kunst verkauft. Aber bald plant es, seine erste Show ausschließlich den mit AI erstellten Werken zu veranstalten, eine Ankündigung, die mit gemischten Bewertungen gestoßen wurde – und eine Petition, in der die Absage der Auktion gefordert wird.

Besser als Gold: Ein von Google Deepmind, dem führendes KI -Forschungslabor von Google, entwickeltes KI -System scheint den durchschnittlichen Goldmedaillengewinner bei der Lösung von Geometrieproblemen in einem internationalen Mathematikwettbewerb übertroffen zu haben.

Forschungspapier der Woche

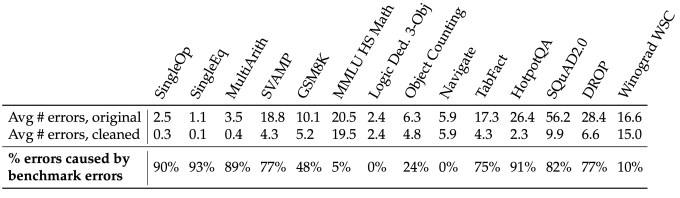

Wir wissen, dass die meisten KI-Modelle keine grundlegenden Aufgaben zuverlässig ausführen können, z. Was wir nicht immer wissen, ist der Grund hinter ihren Misserfolgen. Laut einem Team von Forschern am MIT CSAIL können fehlerhafte Benchmarks teilweise schuld sein.

In einer neuen Studie stellten die MIT-CSAIL-Forscher fest, dass die heutigen Top-Performance-Modelle zwar immer noch echte Fehler bei beliebten KI-Benchmarks machen, über 50% der „Modellfehler“ tatsächlich durch fehlgeleitete und mehrdeutige Fragen in diesen Benchmarks verursacht werden.

„Wenn wir die Modellzuverlässigkeit ordnungsgemäß quantifizieren möchten, müssen wir darüber nachdenken, wie wir Benchmarks konstruieren, um Etikettenfehler zu minimieren“ Einer der Forscher, MIT -Fakultätsmitglied und OpenAI -Mitarbeiter Aleksander Madry, in einem Beitrag auf x. „Dies ist nur ein erster Schritt.“

Modell der Woche

Sie haben schon einmal von Deepfakes gehört. Aber was ist mit Deepfakes von langweiligen alltäglichen Szenen? Das ist die Idee dahinter Langweilige Realität Hunyuan Lora (Boreal-HL)ein fein abgestimmter KI-Videogenerator, der sich beim Erstellen von Videos von… naja banal erstellt.

Boreal-HL kann Clips von Touristen erzeugen, die Eis essen, Menschen mit Fleisch, Menschen in Mittagessen, Führungskräfte, die Reden auf Konferenzen, Paare bei Hochzeiten und andere weltliche Lebensschnitte halten. Dieser Reporter findet die Absurdität der Sache lustig – besonders wenn man bedenkt, wie unpraktisch es ist, zu laufen. Es dauert mindestens fünf Minuten, um einen einzelnen Clip zu erzeugen.

Tasche greifen

Dank der jüngsten Durchbrüche in der KI -Effizienz wird es billiger – und leichter -, hoch entwickelte Modelle zu trainieren.

In einem neuen PapierForscher der Shanghai Jiao Tong University und ein KI -Unternehmen namens SII zeigen, dass ein Modell, das auf nur 817 „kuratierten Trainingsproben“ trainiert wurde, Modelle übertreffen kann, die auf 100x weiteren Daten ausgebildet sind. Das Team behauptet, dass sein Modell sogar in der Lage war, bestimmte Fragen zu beantworten, die es während des Trainings nicht gesehen habe, und zeigte, was sie als „Out -Domain“ -Funktionen bezeichnen.

Die Studie folgt nach einem von Stanford geführten Projekt, bei dem festgestellt wurde, dass es möglich ist, ein „Open“ -Modell zu erstellen, das das O1-Modell „Argumenting“ von Openai für weniger als 50 US-Dollar mit sich bringt.