Hallo Leute, willkommen zum regelmäßigen KI-Newsletter von Tech. Wenn Sie dies jeden Mittwoch in Ihrem Posteingang haben möchten, klicken Sie auf den Link und melden Sie sich hier an.

Letzte Woche hat OpenAI den Advanced Voice Mode with Vision eingeführt, der Echtzeitvideos an ChatGPT weiterleitet und es dem Chatbot ermöglicht, über die Grenzen seiner App-Ebene hinaus zu „sehen“. Die Prämisse ist, dass der Bot durch eine größere Kontextwahrnehmung von ChatGPT natürlicher und intuitiver reagieren kann.

Aber als ich es das erste Mal versuchte, wurde ich angelogen.

„Das Sofa sieht bequem aus!“ Sagte ChatGPT, als ich mein Telefon hochhielt und den Bot bat, unser Wohnzimmer zu beschreiben. Es hatte die Ottomane mit einer Couch verwechselt.

„Mein Fehler!“ ChatGPT sagte, als ich es korrigierte. „Nun, es sieht immer noch nach einem gemütlichen Raum aus.“

Es ist fast ein Jahr her, seit OpenAI den Advanced Voice Mode mit Vision, den das Unternehmen entwickelt hat, erstmals vorführte aufgeschlagen als Schritt in Richtung KI, wie im Spike Jonze-Film „Her“ dargestellt. So wie OpenAI es verkaufte, würde der Advanced Voice Mode with Vision ChatGPT Superkräfte verleihen – es dem Bot ermöglichen, skizzierte mathematische Probleme zu lösen, Emotionen zu lesen und darauf zu reagieren liebevolle Briefe.

Hat es das alles erreicht? Mehr oder weniger. Aber der erweiterte Sprachmodus mit Vision hat das größte Problem von ChatGPT nicht gelöst: die Zuverlässigkeit. Wenn überhaupt, macht diese Funktion die Halluzinationen des Bots deutlicher.

Irgendwann war ich neugierig, ob der erweiterte Sprachmodus mit Vision ChatGPT dabei helfen könnte, Modetipps anzubieten. Ich aktivierte ihn und bat ChatGPT, ein Outfit von mir zu bewerten. Dies geschah glücklicherweise. Aber während der Bot eine Meinung zu meiner Kombination aus Jeans und olivfarbenem Hemd abgab, übersah er ständig die braune Jacke, die ich trug.

Ich bin nicht der Einzige, der Ausrutscher erlebt hat.

Als OpenAI-Präsident Greg Brockman Anfang des Monats in „60 Minutes“ den Advanced Voice Mode with Vision vorführte, machte ChatGPT einen Fehler bei einem Geometrieproblem. Bei der Berechnung der Fläche eines Dreiecks gilt: falsch identifiziert die Höhe des Dreiecks.

Meine Frage ist also: Was nützt eine „ihr“-ähnliche KI, wenn man ihr nicht vertrauen kann?

Mit jeder Fehlfunktion von ChatGPT fühlte ich mich immer weniger geneigt, in die Tasche zu greifen, mein Telefon zu entsperren, ChatGPT zu starten, den erweiterten Sprachmodus zu öffnen und Vision zu aktivieren – eine umständliche Reihe von Schritten unter den besten Umständen. Mit seinem hellen und fröhlichen Auftreten ist der Advanced Voice Mode eindeutig darauf ausgelegt, Vertrauen zu schaffen. Wenn dieses implizite Versprechen nicht eingehalten wird, ist das ärgerlich – und enttäuschend.

Vielleicht kann OpenAI eines Tages das Halluzinationsproblem ein für alle Mal lösen. Bis dahin sitzen wir mit einem Bot fest, der die Welt durch kreuz und quer verlaufende Verkabelungen betrachtet. Und ehrlich gesagt bin ich mir nicht sicher, wer das wollen könnte.

Nachricht

Die 12 Tage „shipmas“ von OpenAI gehen weiter: OpenAI veröffentlicht bis zum 20. Dezember täglich neue Produkte. Hier finden Sie eine Zusammenfassung aller Ankündigungen, die wir regelmäßig aktualisieren.

YouTube bietet YouTubern die Möglichkeit, sich abzumelden: YouTube gibt YouTubern mehr Wahlmöglichkeiten darüber, wie Dritte ihre Inhalte zum Trainieren ihrer KI-Modelle verwenden können. Ersteller und Rechteinhaber können sich für YouTube melden, wenn sie bestimmten Unternehmen gestatten, Models für ihre Clips zu schulen.

Die Datenbrillen von Meta erhalten Upgrades: Die Ray-Ban Meta-Datenbrille von Meta ist angekommen mehrere neue KI-gestützte Updateseinschließlich der Möglichkeit, ein fortlaufendes Gespräch mit der KI von Meta zu führen und zwischen Sprachen zu übersetzen.

DeepMinds Antwort an Sora: Google DeepMind, Googles Flaggschiff-KI-Forschungslabor, will OpenAI im Videogenerierungsspiel schlagen. Am Montag kündigte DeepMind Veo 2 an, eine videogenerierende KI der nächsten Generation, die mehr als zweiminütige Clips in Auflösungen von bis zu 4K (4.096 x 2.160 Pixel) erstellen kann.

OpenAI-Whistleblower tot aufgefunden: Nach Angaben des San Francisco Office of the Chief Medical Examiner wurde ein ehemaliger OpenAI-Mitarbeiter, Suchir Balaji, kürzlich tot in seiner Wohnung in San Francisco aufgefunden. Im Oktober äußerte der 26-jährige KI-Forscher in einem Interview mit der New York Times Bedenken, dass OpenAI gegen das Urheberrecht verstößt.

Grammarly erwirbt Coda: Grammarly, vor allem für seine Tools zur Stil- und Rechtschreibprüfung bekannt, hat das Produktivitäts-Startup Coda für einen nicht genannten Betrag übernommen. Im Rahmen der Vereinbarung wird Shishir Mehrotra, CEO und Mitbegründer von Coda, neuer CEO von Grammarly.

Cohere arbeitet mit Palantir zusammen: Tech berichtete exklusiv, dass Cohere, das auf Unternehmen ausgerichtete KI-Startup mit einem Wert von 5,5 Milliarden US-Dollar, eine Partnerschaft mit dem Datenanalyseunternehmen Palantir hat. Palantir äußert sich lautstark zu seinem Ende – und zwar manchmal umstritten – mit US-Verteidigungs- und Geheimdiensten zusammenarbeiten.

Forschungspapier der Woche

Anthropic hat den Vorhang für Clio zurückgezogen („Claude ichSehenswürdigkeiten und OBservations“), ein System, mit dem das Unternehmen versteht, wie Kunden seine verschiedenen KI-Modelle einsetzen. Clio, das Anthropic mit Analysetools wie Google Trends vergleicht, liefert „wertvolle Erkenntnisse“ zur Verbesserung der Sicherheit der KI von Anthropic, behauptet das Unternehmen.

Anthropic beauftragte Clio mit der Zusammenstellung anonymisierter Nutzungsdaten, von denen das Unternehmen letzte Woche einige veröffentlichte. Wofür nutzen Kunden also die KI von Anthropic? Eine Reihe von Aufgaben – aber die Entwicklung von Web- und mobilen Apps, die Erstellung von Inhalten und die akademische Forschung stehen ganz oben auf der Liste. Vorhersehbar variieren die Anwendungsfälle je nach Sprache. Japanischsprachige Personen bitten beispielsweise eher die KI von Anthropic, Animes zu analysieren, als spanischsprachige Personen.

Modell der Woche

Das KI-Startup Pika hat sein Videogenerationsmodell der nächsten Generation veröffentlicht. Pika 2mit dem ein Clip aus einer vom Benutzer angegebenen Figur, einem Objekt und einem Ort erstellt werden kann. Über die Plattform von Pika können Benutzer mehrere Referenzen hochladen (z. B. Bilder eines Sitzungssaals und von Büroangestellten), und Pika 2 „ahnt“ die Rolle jeder Referenz, bevor es sie zu einer einzigen Szene kombiniert.

Natürlich ist kein Modell perfekt. Sehen Sie sich unten den von Pika 2 erstellten „Anime“ an, der eine beeindruckende Konsistenz aufweist, aber unter der ästhetischen Verrücktheit leidet, die in allen generativen KI-Aufnahmen vorhanden ist.

pic.twitter.com/3jWCy4659o Wie ich bereits sagte, werden Animes das erste Genre sein, das zu 100 % KI-generiert ist. Es ist erstaunlich zu sehen, was mit Pika 2.0 bereits möglich ist

— Chubby♨️ (@kimmonismus) 16. Dezember 2024

Dennoch verbessern sich die Tools im Videobereich sehr schnell – und wecken gleichermaßen das Interesse und den Zorn der Kreativen.

Wundertüte

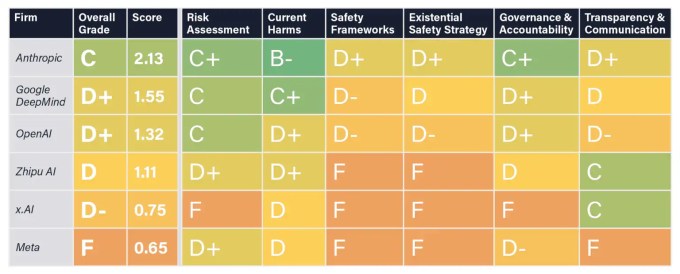

Das Future of Life Institute (FLI), die vom MIT-Kosmologen Max Tegmark mitbegründete gemeinnützige Organisation, hat einen „AI Safety Index“ veröffentlicht, der die Sicherheitspraktiken führender KI-Unternehmen in fünf Schlüsselbereichen bewerten soll: aktuelle Schäden, Sicherheitsrahmen, existenzielle Sicherheitsstrategie, Governance und Rechenschaftspflicht sowie Transparenz und Kommunikation.

Meta war mit der Gesamtnote F die schlechteste der im Index bewerteten Gruppe. (Der Index verwendet ein numerisches und GPA-basiertes Bewertungssystem.) Anthropic war der Beste, schaffte es aber nicht, besser als eine C zu kommen – was darauf hindeutet, dass es Raum für Verbesserungen gibt.