Am Donnerstag veröffentlichte OpenAI einen Chatbot, der praktisch 200 US-Dollar pro Monat kostet – und die KI-Community wusste nicht so recht, was sie davon halten sollte.

Der neue ChatGPT Pro-Plan des Unternehmens gewährt Zugriff auf den „o1 Pro-Modus“, der laut OpenAI „mehr Rechenleistung für die besten Antworten auf die schwierigsten Fragen verbraucht“. Der o1 Pro-Modus ist eine aufgemotzte Version des o1-Argumentationsmodells von OpenAI und soll Fragen zu Naturwissenschaften, Mathematik und Codierung „zuverlässiger“ und „umfassender“ beantworten, sagt OpenAI.

Fast sofort begannen die Leute, Einhörner zu zeichnen:

Ich habe ChatGPT o1 Pro Mode gebeten, eine SVG-Datei eines Einhorns zu erstellen.

(Dies ist das Modell, auf das Sie für 200 $ monatlich Zugriff erhalten) pic.twitter.com/h9HwY3aYwU

– Rammy (@rammydev) 5. Dezember 2024

Und entwerfen Sie einen „Krabben-basierten“ Computer:

Endlich wird o1-pro für seinen ultimativen Anwendungsfall eingesetzt. pic.twitter.com/nX4JAjx71m

– Ethan Mollick (@emollick) 6. Dezember 2024

Und poetisch über den Sinn des Lebens:

Ich habe gerade das 200-Dollar-Monat-Abonnement von OpenAI abonniert.

Antworten Sie mit Fragen, die Sie stellen möchten, und ich werde sie in diesem Thread erneut veröffentlichen. pic.twitter.com/oTQxbPxnoP— Garrett Scott 🕳 (@thegarrettscott) 5. Dezember 2024

Aber viele Leute auf

„Hat OpenAI konkrete Beispiele für Eingabeaufforderungen geteilt, die in regulärem o1 fehlschlagen, in o1-pro jedoch erfolgreich sind?“ fragte Der britische Informatiker Simon Willison. „Ich möchte ein einziges konkretes Beispiel sehen, das seinen Vorteil zeigt.“

Das ist eine berechtigte Frage; Immerhin ist dies das teuerste Chatbot-Abonnement der Welt. Der Dienst bietet weitere Vorteile, wie die Aufhebung von Ratenbeschränkungen und unbegrenzten Zugriff auf die anderen Modelle von OpenAI. Aber 2.400 US-Dollar pro Jahr sind kein Kleingeld, und insbesondere das Wertversprechen des o1-Pro-Modus bleibt unklar.

Es dauerte nicht lange, Fehlerfälle zu finden. Der O1-Pro-Modus hat Probleme mit Sudoku und wird durch einen optischen Täuschungswitz gestört, der für jeden Menschen offensichtlich ist.

o1 und o1-pro sind hier beide gescheitert, wahrscheinlich immer noch wegen der Seheinschränkungen (das Gleiche gilt für Sudoku-Rätsel).https://t.co/mAVK7WxBrq pic.twitter.com/O9boSv7ZGt

— Tibor Blaho (@btibor91) 5. Dezember 2024

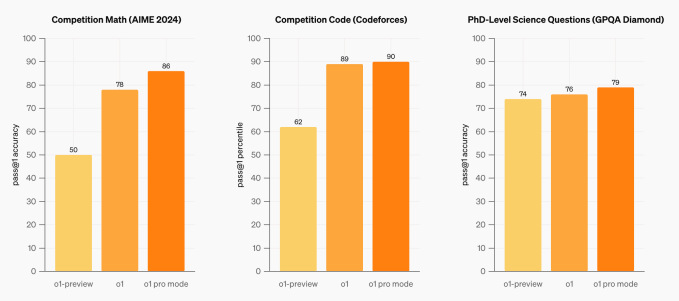

Die internen Benchmarks von OpenAI zeigen, dass der o1-Pro-Modus bei Codierungs- und Mathematikproblemen nur geringfügig besser abschneidet als der Standard-o1:

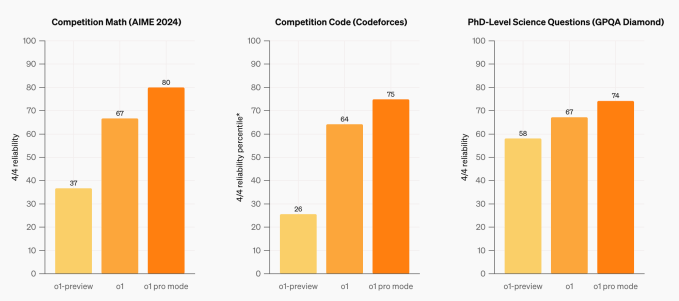

OpenAI führte eine „strengere“ Bewertung derselben Benchmarks durch, um die Konsistenz des o1-Pro-Modus zu demonstrieren: Es wurde nur dann davon ausgegangen, dass das Modell eine Frage gelöst hatte, wenn es in vier von vier Fällen die richtige Antwort gab. Aber selbst in diesen Tests waren die Verbesserungen nicht dramatisch:

OpenAI-CEO Sam Altman, der einmal schrieb, dass OpenAI auf einem sei Weg „In Richtung Intelligenz, die zu billig ist, um sie zu messen“, wurde dazu gezwungen klären mehrere mal am Donnerstag, dass ChatGPT Pro nicht für die meisten Menschen geeignet ist.

„Die meisten Benutzer werden mit dem o1 sehr zufrieden sein [ChatGPT] Plus-Stufe!“ sagte er zu X. „Fast jeder wird mit unserem kostenlosen Kontingent oder dem Plus-Kontingent am besten bedient sein.“

Für wen ist es also? Gibt es da draußen wirklich Leute, die bereit sind, 200 Dollar im Monat zu zahlen, um Spielzeugfragen zu stellen wie „Schreiben Sie einen Aufsatz mit drei Absätzen über Erdbeeren, ohne den Buchstaben „e“ zu verwenden.“ oder „Lösen Sie dieses Mathe-Olympiade-Problem„? Werden sie sich glücklich von ihrem hart verdienten Geld trennen, ohne die große Garantie zu haben, dass das Standard-O1 nicht dieselben Fragen zufriedenstellend beantworten kann?

Ich habe Ameet Talwalkar gefragt, einen außerordentlichen Professor für maschinelles Lernen an der Carnegie Mellon und ein Venture-Partner bei Amplify Partners, seiner Meinung nach. „Es scheint mir ein großes Risiko zu sein, den Preis um das Zehnfache zu erhöhen“, sagte er per E-Mail zu Tech. „Ich denke, wir werden in nur wenigen Wochen ein viel besseres Gefühl dafür haben, wie groß der Bedarf an dieser Funktionalität ist.“

Der UCLA-Informatiker Guy Van den Broeck war in seiner Einschätzung offener. „Ich weiß nicht, ob der Preis sinnvoll ist“, sagte er gegenüber Tech, „und ob teure Argumentationsmodelle die Norm sein werden.“

o1 ist „bei den meisten Aufgaben besser als die meisten Menschen“, denn ja, Menschen existieren ausschließlich in amnesischen, körperlosen Multi-Turn-Chat-Schnittstellen https://t.co/zbLY2BG5pQ

— Aidan McLau (@aidan_mclau) 6. Dezember 2024

Eine großzügige Annahme ist, dass es sich um einen Marketingfehler handelt. Die Beschreibung des o1-Pro-Modus als am besten geeignet, „die schwierigsten Probleme“ zu lösen, sagt potenziellen Kunden nicht viel. Auch nicht vage Aussagen darüber, wie das Modell „länger denken“ und „Intelligenz“ demonstrieren kann. Wie Willison betont, ist es ohne konkrete Beispiele dieser angeblich verbesserten Leistungsfähigkeit kaum zu rechtfertigen, überhaupt mehr zu zahlen, geschweige denn den zehnfachen Preis.

Soweit ich das beurteilen kann, sind Experten in Spezialgebieten die Zielgruppe. OpenAI plant, einer Handvoll medizinischer Forscher an „führenden Institutionen“ kostenlosen Zugang zu ChatGPT Pro zu gewähren, das den o1 Pro-Modus umfassen wird. Fehler spielen im Gesundheitswesen eine große Rolle, und wie Bob McGrew, ehemaliger Forschungsleiter von OpenAI, sagte: notiert Auf X ist die bessere Zuverlässigkeit möglicherweise die Hauptvorteile des o1 Pro-Modus.

Ich spiele eine Weile mit o1 und o1-pro.

Sie sind sehr gut und ein wenig seltsam. Sie sind auch die meiste Zeit nicht für die meisten Menschen geeignet. Sie müssen wirklich besonders schwierige Probleme lösen, um einen Nutzen daraus zu ziehen. Aber wenn Sie diese Probleme haben, ist das eine sehr große Sache.

– Ethan Mollick (@emollick) 5. Dezember 2024

McGrew auch überlegte Der o1 Pro-Modus ist ein Beispiel für das, was er als „Intelligenzüberhang“ bezeichnet: Benutzer (und möglicherweise die Ersteller des Modells) wissen aufgrund grundlegender Einschränkungen einer einfachen, textbasierten Benutzeroberfläche nicht, wie sie aus „zusätzlicher Intelligenz“ einen Nutzen ziehen können. Wie bei den anderen Modellen von OpenAI besteht die einzige Möglichkeit, mit dem o1-Pro-Modus zu interagieren, über ChatGPT, und – um es McGrew auf den Punkt zu bringen – ChatGPT ist nicht perfekt.

Es stimmt jedoch auch, dass 200 US-Dollar hohe Erwartungen wecken. Und der frühen Resonanz in den sozialen Medien nach zu urteilen, ist ChatGPT Pro kein Volltreffer.