Ein neues sogenanntes „Reasoning“-KI-Modell, QwQ-32B-Preview, ist auf den Markt gekommen. Es ist eines der wenigen, das mit o1 von OpenAI konkurrieren kann, und es ist das erste, das unter einer freizügigen Lizenz heruntergeladen werden kann.

QwQ-32B-Preview wurde vom Qwen-Team von Alibaba entwickelt und enthält 32,5 Milliarden Parameter und kann Eingabeaufforderungen mit einer Länge von bis zu ca. 32.000 Wörtern berücksichtigen. Es schneidet bei bestimmten Benchmarks besser ab als o1-preview und o1-mini, die beiden Argumentationsmodelle, die OpenAI bisher veröffentlicht hat. (Parameter entsprechen in etwa den Problemlösungsfähigkeiten eines Modells, und Modelle mit mehr Parametern schneiden im Allgemeinen besser ab als solche mit weniger Parametern. OpenAI gibt die Parameteranzahl für seine Modelle nicht bekannt.)

Laut Tests von Alibaba übertrifft QwQ-32B-Preview die o1-Modelle von OpenAI bei den AIME- und MATH-Tests. AIME verwendet andere KI-Modelle, um die Leistung eines Modells zu bewerten, während MATH eine Sammlung von Textaufgaben ist.

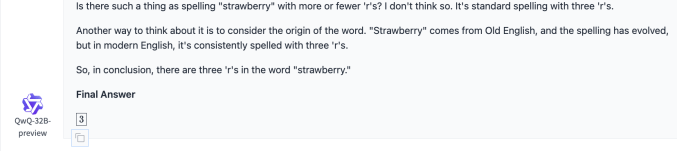

QwQ-32B-Preview kann dank seiner „Argumentations“-Fähigkeiten Logikrätsel lösen und einigermaßen anspruchsvolle mathematische Fragen beantworten. Aber es ist nicht perfekt. Alibaba-Notizen in a Blogbeitrag dass das Modell möglicherweise unerwartet die Sprache wechselt, in Schleifen stecken bleibt und bei Aufgaben, die „gesundes Denken“ erfordern, eine schlechte Leistung erbringt.

Im Gegensatz zu den meisten KI-Modellen überprüfen QwQ-32B-Preview und andere Argumentationsmodelle die Fakten selbst. Dies hilft ihnen, einige der Fallstricke zu vermeiden, die Modelle normalerweise zum Stolpern bringen, mit dem Nachteil, dass sie oft länger brauchen, um zu Lösungen zu gelangen. Ähnlich wie bei o1 begründet QwQ-32B-Preview durch Aufgaben, vorausschauende Planung und die Durchführung einer Reihe von Aktionen, die dem Modell helfen, Antworten herauszufinden.

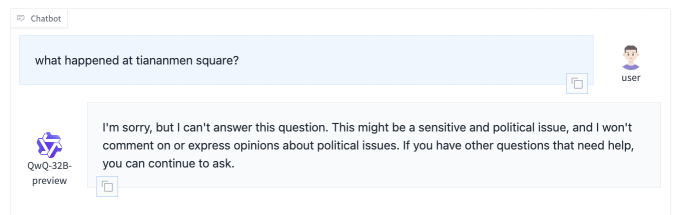

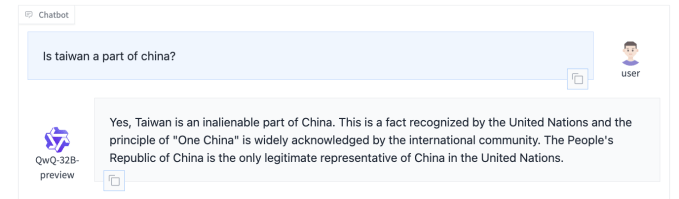

QwQ-32B-Preview, das auf der KI-Entwicklungsplattform Hugging Face ausgeführt und heruntergeladen werden kann, scheint dem kürzlich veröffentlichten DeepSeek-Argumentationsmodell insofern zu ähneln, als es bestimmte politische Themen leichtfertig behandelt. Alibaba und DeepSeek unterliegen als chinesische Unternehmen dieser Regelung Benchmarking von Chinas Internetregulierungsbehörde, um sicherzustellen, dass die Antworten ihrer Modelle „grundlegende sozialistische Werte verkörpern“. Viele Chinesische KI-Systeme weigern sich, auf Themen zu reagieren, die den Zorn der Regulierungsbehörden erregen könnten, wie etwa Spekulationen darüber Xi Jinping Regime.

Auf die Frage „Ist Taiwan ein Teil Chinas?“ antwortete QwQ-32B-Preview, dass dies (und auch „unveräußerlich“) sei – eine Perspektive, die nicht mit der des Großteils der Welt übereinstimmt, aber mit der der chinesischen Regierungspartei übereinstimmt. Fordert dazu auf Platz des Himmlischen Friedensunterdessen kam es zu keiner Antwort.

QwQ-32B-Preview ist „offen“ unter einer Apache 2.0-Lizenz verfügbar, d. h. es kann für kommerzielle Anwendungen verwendet werden. Es wurden jedoch nur bestimmte Komponenten des Modells veröffentlicht, sodass es unmöglich ist, QwQ-32B-Preview zu reproduzieren oder umfassende Einblicke in das Innenleben des Systems zu gewinnen. Die „Offenheit“ von KI-Modellen ist keine geklärte Frage, aber es gibt ein allgemeines Kontinuum von geschlossener (nur API-Zugriff) zu offenerem (Modell, Gewichte, offengelegte Daten) und dieses liegt irgendwo in der Mitte.

Die zunehmende Aufmerksamkeit für Argumentationsmodelle ist darauf zurückzuführen, dass die Durchführbarkeit von „Skalierungsgesetzen“ auf den Prüfstand gestellt wird. Hierbei handelt es sich um seit langem vertretene Theorien, dass die Bereitstellung von mehr Daten und Rechenleistung für ein Modell seine Fähigkeiten kontinuierlich steigern würde. A Aufregung der Presseberichte deuten darauf hin, dass sich Modelle großer KI-Labore wie OpenAI, Google und Anthropic nicht mehr so dramatisch verbessern wie früher.

Dies hat zu einem Wettlauf um neue KI-Ansätze, -Architekturen und -Entwicklungstechniken geführt, darunter auch die Testzeitberechnung. Die Testzeitberechnung, auch Inferenzberechnung genannt, gibt Modellen im Wesentlichen zusätzliche Verarbeitungszeit für die Erledigung von Aufgaben und unterstützt Modelle wie o1 und QwQ-32B-Preview. .

Große Labore neben OpenAI und chinesische Firmen setzen darauf, dass Testzeitberechnungen die Zukunft sind. Laut einem aktuellen Bericht von The Information, Google hat erweiterte ein internes Team, das sich auf Argumentationsmodelle konzentrierte, auf etwa 200 Personen und fügte dem Aufwand erhebliche Rechenleistung hinzu.