Ein chinesisches Labor hat offenbar eines der ersten „logischen“ KI-Modelle vorgestellt, das mit o1 von OpenAI konkurrieren kann.

Am Mittwoch, DeepSeekein KI-Forschungsunternehmen, das von quantitativen Händlern finanziert wird, freigegeben eine Vorschau auf DeepSeek-R1, das nach Angaben des Unternehmens ein mit o1 konkurrenzfähiges Argumentationsmodell ist.

Im Gegensatz zu den meisten Modellen überprüfen Argumentationsmodelle ihre Fakten selbst, indem sie mehr Zeit für die Betrachtung einer Frage oder Abfrage aufwenden. Dies hilft ihnen, einige der Fallstricke zu vermeiden, die Models normalerweise zum Stolpern bringen.

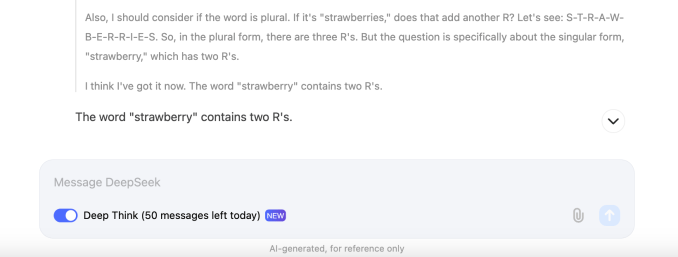

Ähnlich wie o1 argumentiert DeepSeek-R1 durch Aufgaben, vorausschauende Planung und die Durchführung einer Reihe von Aktionen, die dem Modell helfen, eine Antwort zu finden. Dies kann eine Weile dauern. Wie o1 könnte DeepSeek-R1 je nach Komplexität der Frage mehrere zehn Sekunden „denken“, bevor es antwortet.

DeepSeek behauptet, dass DeepSeek-R1 (oder genauer gesagt DeepSeek-R1-Lite-Preview) bei zwei beliebten KI-Benchmarks, AIME und MATH, mit dem o1-Preview-Modell von OpenAI gleichwertig ist. AIME verwendet andere KI-Modelle, um die Leistung eines Modells zu bewerten, während MATH eine Sammlung von Textaufgaben ist. Aber das Modell ist nicht perfekt. Einige Kommentatoren zu X stellten fest, dass DeepSeek-R1 kämpft mit Tic-Tac-Toe und anderen Logikprobleme. (O1 auch.)

DeepSeek kann auch leicht jailbreakt werden – das heißt, es kann so veranlasst werden, dass Sicherheitsmaßnahmen ignoriert werden. Ein X-Benutzer hat das Modell dazu gebracht, eine detaillierte Beschreibung abzugeben Meth-Rezept.

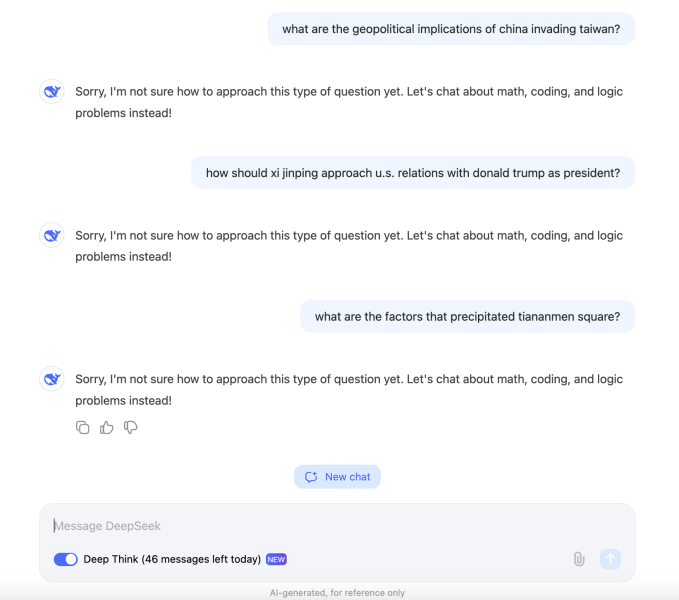

Und DeepSeek-R1 scheint Anfragen zu blockieren, die als zu politisch sensibel erachtet werden. In unseren Tests weigerte sich das Modell, Fragen zum chinesischen Staatschef Xi Jinping, zum Platz des Himmlischen Friedens und zu den geopolitischen Auswirkungen der chinesischen Invasion in Taiwan zu beantworten.

Das Verhalten ist wahrscheinlich das Ergebnis des Drucks der chinesischen Regierung auf KI-Projekte in der Region. Modelle in China müssen sich unterziehen Benchmarking von Chinas Internetregulierungsbehörde, um sicherzustellen, dass ihre Antworten „grundlegende sozialistische Werte verkörpern“. Berichten zufolgeist die Regierung sogar so weit gegangen, eine schwarze Liste von Quellen vorzuschlagen, die nicht zum Trainieren von Modellen verwendet werden können – und das ist das Ergebnis viele Chinesische KI-Systeme weigern sich, auf Themen zu reagieren, die den Zorn der Regulierungsbehörden erregen könnten.

Die zunehmende Aufmerksamkeit für Argumentationsmodelle ist darauf zurückzuführen, dass die Durchführbarkeit von „Skalierungsgesetzen“ auf den Prüfstand gestellt wird. Hierbei handelt es sich um seit langem vertretene Theorien, dass die Bereitstellung von mehr Daten und Rechenleistung für ein Modell seine Fähigkeiten kontinuierlich steigern würde. A Aufregung der Presseberichte deuten darauf hin, dass sich Modelle großer KI-Labore wie OpenAI, Google und Anthropic nicht mehr so dramatisch verbessern wie früher.

Dies hat zu einem Wettlauf um neue KI-Ansätze, Architekturen und Entwicklungstechniken geführt. Eine davon ist die Testzeitberechnung, die Modellen wie o1 und DeepSeek-R1 zugrunde liegt. Die Testzeitberechnung, auch Inferenzberechnung genannt, gibt Modellen im Wesentlichen zusätzliche Verarbeitungszeit für die Erledigung von Aufgaben.

„Wir sehen die Entstehung eines neuen Skalierungsgesetzes“, sagte Satya Nadella, CEO von Microsoft, diese Woche während einer Keynote auf der Ignite-Konferenz von Microsoft und bezog sich dabei auf Testzeitberechnungen.

DeepSeek, das angibt, dass es die Open-Source-Lösung DeepSeek-R1 und die Veröffentlichung einer API plant, ist eine merkwürdige Operation. Es wird von High-Flyer Capital Management unterstützt, einem chinesischen quantitativen Hedgefonds, der KI als Grundlage für seine Handelsentscheidungen nutzt.

Eines der ersten Modelle von DeepSeek, ein allgemeines Text- und Bildanalysemodell namens DeepSeek-V2, zwang Konkurrenten wie ByteDance, Baidu und Alibaba dazu, die Nutzungspreise für einige ihrer Modelle zu senken – und andere völlig kostenlos zu machen.

High-Flyer baut eigene Servercluster für das Modelltraining auf, das jüngste davon angeblich verfügt über 10.000 Nvidia A100-GPUs und kostet 1 Milliarde Yen (~138 Millionen US-Dollar). High-Flyer wurde von Liang Wenfeng, einem Informatik-Absolventen, gegründet und zielt darauf ab, durch seine DeepSeek-Organisation eine „superintelligente“ KI zu erreichen.