In einem Pitch vor Investoren im vergangenen Frühjahr sagte Anthropic, dass man beabsichtige, KI zu entwickeln, um virtuelle Assistenten anzutreiben, die selbstständig Recherchen durchführen, E-Mails beantworten und andere Back-Office-Aufgaben erledigen könnten. Das Unternehmen bezeichnete dies als „Algorithmus der nächsten Generation für KI-Selbstlernen“ – einen Algorithmus, von dem es glaubte, dass er, wenn alles nach Plan verläuft, eines Tages große Teile der Wirtschaft automatisieren könnte.

Es hat eine Weile gedauert, aber die KI fängt an, Einzug zu halten.

Anthropisch am Dienstag freigegeben eine aktualisierte Version seines Claude 3.5 Sonnet-Modells, die jede Desktop-App verstehen und mit ihr interagieren kann. Über eine neue „Computer Use“-API, die sich jetzt in der offenen Betaphase befindet, kann das Modell Tastenanschläge, Tastenklicks und Mausgesten imitieren und so im Wesentlichen eine Person nachahmen, die an einem PC sitzt.

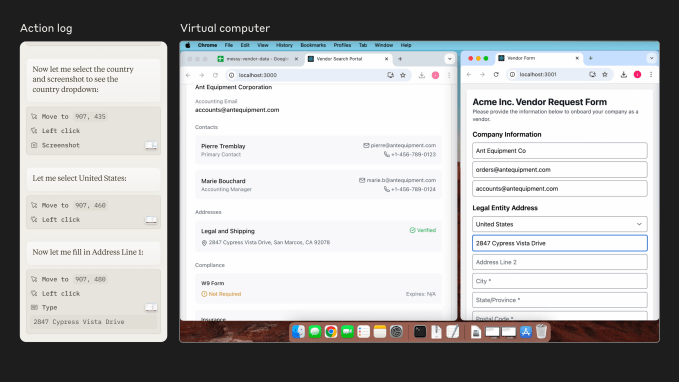

„Wir haben Claude darin geschult, zu sehen, was auf einem Bildschirm passiert, und dann die verfügbaren Softwaretools zu verwenden, um Aufgaben auszuführen“, schrieb Anthropic in einem Blogbeitrag, der mit Tech geteilt wurde. „Wenn ein Entwickler Claude mit der Verwendung einer Computersoftware beauftragt und ihr den erforderlichen Zugriff gewährt, schaut sich Claude Screenshots dessen an, was für den Benutzer sichtbar ist, und zählt dann, wie viele Pixel vertikal oder horizontal erforderlich sind, um einen Cursor zu bewegen, um hineinzuklicken der richtige Ort.“

Entwickler können die Computernutzung über die API von Anthropic, Amazon Bedrock und die Vertex AI-Plattform von Google Cloud ausprobieren. Das neue 3.5 Sonnet ohne Computer Use wird für Claude-Apps eingeführt und bringt verschiedene Leistungsverbesserungen gegenüber dem Vorgängermodell 3.5 Sonnet mit sich.

Apps automatisieren

Ein Tool, das Aufgaben auf einem PC automatisieren kann, ist keine neue Idee. Unzählige Unternehmen bieten solche Tools an, von jahrzehntealten RPA-Anbietern bis hin zu neueren Neulingen wie Relay, Induced AI und Automat.

Im Wettlauf um die Entwicklung sogenannter „KI-Agenten“ ist das Feld nur noch überfüllter geworden. KI-Agenten sind nach wie vor ein unklar definierter Begriff, beziehen sich jedoch im Allgemeinen auf KI, die Software automatisieren kann.

Manche Analysten sagen, KI-Agenten könnten Unternehmen einen einfacheren Weg bieten, die Milliarden von Dollar, die sie in KI stecken, zu monetarisieren. Die Unternehmen scheinen sich einig zu sein: Laut einer aktuellen Studie von Capgemini Umfrage10 % der Unternehmen nutzen bereits KI-Agenten und 82 % werden sie innerhalb der nächsten drei Jahre integrieren.

Salesforce machte diesen Sommer aufsehenerregende Ankündigungen zu seiner KI-Agententechnologie, während Microsoft angepriesen neue Tools zum Erstellen von KI-Agenten gestern. OpenAI, das ist plant eine eigene Marke von KI-Agentensieht die Technologie als einen Schritt in Richtung superintelligenter KI.

Anthropic nennt seine Interpretation des KI-Agenten-Konzepts eine „Action-Execution-Schicht“, die es dem neuen 3.5 Sonnet ermöglicht, Befehle auf Desktop-Ebene auszuführen. Dank seiner Fähigkeit, im Internet zu surfen (keine Premiere für KI-Modelle, aber eine Premiere für Anthropic), kann 3.5 Sonnet jede Website und jede Anwendung nutzen.

„Menschen behalten die Kontrolle, indem sie spezifische Aufforderungen geben, die Claudes Aktionen steuern, wie zum Beispiel ‚Verwenden Sie Daten von meinem Computer und online, um dieses Formular auszufüllen‘“, sagte ein Anthropic-Sprecher gegenüber Tech. „Menschen ermöglichen den Zugriff und beschränken den Zugriff nach Bedarf. Claude zerlegt die Eingabeaufforderungen des Benutzers in Computerbefehle (z. B. Bewegen des Cursors, Klicken, Tippen), um diese spezifische Aufgabe auszuführen.“

Die Softwareentwicklungsplattform Replit hat eine frühe Version des neuen 3.5 Sonnet-Modells verwendet, um einen „autonomen Verifizierer“ zu erstellen, der Apps bewerten kann, während sie erstellt werden. Canva sagt unterdessen, dass es Möglichkeiten untersucht, wie das neue Modell den Entwurfs- und Bearbeitungsprozess unterstützen könnte.

Aber wie unterscheidet sich das von den anderen KI-Agenten da draußen? Das ist eine berechtigte Frage. Das Consumer-Gadget-Startup Rabbit baut einen Web-Agenten auf, der Dinge wie den Online-Kauf von Kinokarten erledigen kann; Adept, das kürzlich von Amazon übernommen wurde, schult Modelle darin, Websites zu durchsuchen und in Software zu navigieren. und Twin Labs verwendet Standardmodelle, darunter GPT-4o von OpenAI, um Desktop-Prozesse zu automatisieren.

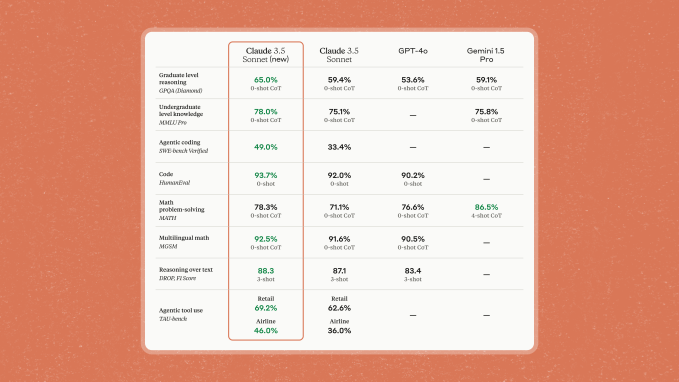

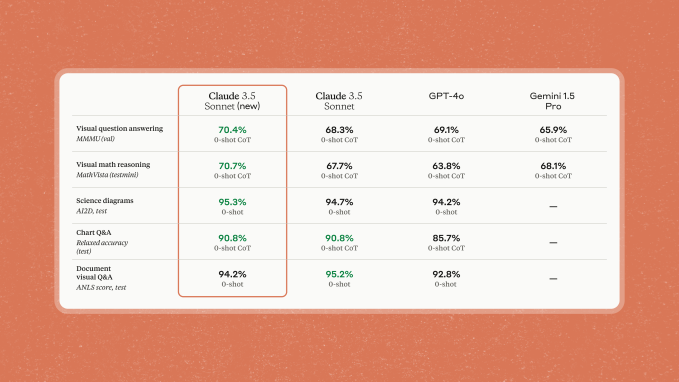

Anthropic behauptet, das neue 3.5 Sonnet sei einfach ein stärkeres, robusteres Modell, das bei Codierungsaufgaben sogar besser abschneiden könne als OpenAIs Flaggschiff o1, laut SWE-Bench-Verified-Benchmark. Auch wenn das aktualisierte 3.5 Sonnet nicht explizit dafür geschult wurde, korrigiert es sich selbst und wiederholt Aufgaben, wenn es auf Hindernisse stößt, und kann auf Ziele hinarbeiten, die Dutzende oder Hunderte von Schritten erfordern.

Aber entlassen Sie Ihre Sekretärin noch nicht.

In einer Evaluierung, die die Fähigkeit eines KI-Agenten testen sollte, bei Flugbuchungsaufgaben, wie etwa der Änderung einer Flugreservierung, zu helfen, gelang es dem neuen 3.5 Sonnet, weniger als die Hälfte der Aufgaben erfolgreich abzuschließen. In einem separaten Test, der Aufgaben wie das Einleiten einer Rückkehr beinhaltete, scheiterte 3.5 Sonnet in etwa einem Drittel der Fälle.

Anthropic gibt zu, dass das aktualisierte Sonnet 3.5 Probleme mit grundlegenden Aktionen wie Scrollen und Zoomen hat und dass es aufgrund der Art und Weise, wie Screenshots erstellt und zusammengesetzt werden, „kurzlebige“ Aktionen und Benachrichtigungen verpassen kann.

„Claudes Computernutzung bleibt langsam und oft fehleranfällig“, schreibt Anthropic in seinem Beitrag. „Wir ermutigen Entwickler, die Erkundung mit risikoarmen Aufgaben zu beginnen.“

Riskantes Geschäft

Aber ist das neue 3.5 Sonnet leistungsfähig genug, um gefährlich zu sein? Möglicherweise.

Ein aktueller Studie fand, dass Modelle ohne B. die Möglichkeit, Desktop-Apps wie GPT-4o von OpenAI zu verwenden, waren bereit, sich auf schädliches „mehrstufiges Agentenverhalten“ einzulassen, beispielsweise die Bestellung eines gefälschten Reisepasses von jemandem im Dark Web, wenn sie mit Jailbreaking-Techniken „angegriffen“ wurden. Den Forschern zufolge führten Jailbreaks zu hohen Erfolgsraten bei der Ausführung schädlicher Aufgaben, selbst bei Modellen, die durch Filter und Schutzmaßnahmen geschützt waren.

Man kann sich vorstellen, wie ein Model mit Der Desktop-Zugriff könnte kaputt gehen mehr Chaos – sagen wir, durch ausbeuten App-Schwachstellen zur Gefährdung persönlicher Daten (bzw Speichern von Chats im Klartext). Abgesehen von den ihm zur Verfügung stehenden Softwarehebeln könnten die Online- und App-Verbindungen des Modells Möglichkeiten eröffnen böswillige Jailbreaker.

Anthropic bestreitet nicht, dass die Veröffentlichung des neuen 3.5 Sonnet mit Risiken verbunden ist. Das Unternehmen argumentiert jedoch, dass die Vorteile der Beobachtung, wie das Modell in freier Wildbahn eingesetzt wird, letztendlich dieses Risiko überwiegen.

„Wir glauben, dass es weitaus besser ist, den Zugang zu Computern den heute eingeschränkteren, relativ sichereren Modellen zu ermöglichen“, schrieb das Unternehmen. „Das bedeutet, dass wir beginnen können, potenzielle Probleme, die auf dieser unteren Ebene auftreten, zu beobachten und daraus zu lernen und schrittweise und gleichzeitig Abhilfemaßnahmen für die Computernutzung und die Sicherheit aufzubauen.“

Anthropic gibt außerdem an, Maßnahmen zur Verhinderung von Missbrauch ergriffen zu haben, indem das neue 3.5 Sonnet beispielsweise nicht anhand der Screenshots und Eingabeaufforderungen der Benutzer trainiert wurde und verhindert wurde, dass das Modell während des Trainings auf das Internet zugreift. Das Unternehmen gibt an, Klassifikatoren entwickelt zu haben, um 3.5 Sonnet von als risikoreich empfundenen Aktionen wie dem Posten in sozialen Medien, dem Erstellen von Konten und der Interaktion mit Regierungswebsites „abzulenken“.

Während die US-Parlamentswahlen näher rückten, konzentriere sich Anthropic nach eigenen Angaben darauf, den wahlbedingten Missbrauch seiner Modelle einzudämmen. Das US AI Safety Institute und das UK Safety Institute, zwei separate, aber verbundene Regierungsbehörden, die sich der Bewertung des Risikos von KI-Modellen widmen, haben das neue 3.5 Sonnet vor seiner Einführung getestet.

Anthropic teilte Tech mit, dass es die Möglichkeit habe, den Zugriff auf zusätzliche Websites und Funktionen „falls erforderlich“ einzuschränken, um beispielsweise vor Spam, Betrug und Fehlinformationen zu schützen. Aus Sicherheitsgründen bewahrt das Unternehmen alle von Computer Use aufgenommenen Screenshots mindestens 30 Tage lang auf – ein Aufbewahrungszeitraum, der einige Entwickler beunruhigen könnte.

Wir haben Anthropic gefragt, unter welchen Umständen, wenn überhaupt, Screenshots auf Anfrage an Dritte (z. B. Strafverfolgungsbehörden) weitergeben würden. Ein Sprecher sagte, dass das Unternehmen „Datenanfragen als Reaktion auf ein gültiges rechtliches Verfahren nachkommen“ werde.

„Es gibt keine narrensicheren Methoden und wir werden unsere Sicherheitsmaßnahmen kontinuierlich evaluieren und anpassen, um Claudes Fähigkeiten mit einer verantwortungsvollen Nutzung in Einklang zu bringen“, sagte Anthropic. „Wer die Computerversion von Claude nutzt, sollte die entsprechenden Vorsichtsmaßnahmen treffen, um diese Art von Risiken zu minimieren, einschließlich der Isolierung von Claude von besonders sensiblen Daten auf seinem Computer.“

Hoffentlich reicht das aus, um das Schlimmste zu verhindern.

Ein günstigeres Modell

Der heutige Headliner war vielleicht das verbesserte 3.5 Sonnet-Modell, aber Anthropic sagte auch, dass eine aktualisierte Version von Haiku, dem billigsten und effizientesten Modell seiner Claude-Serie, auf dem Weg sei.

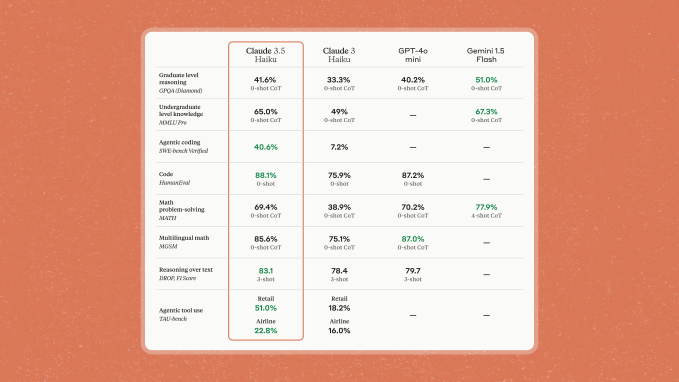

Claude 3.5 Haiku, das in den kommenden Wochen erscheinen soll, wird bei bestimmten Benchmarks mit der Leistung von Claude 3 Opus, dem einst hochmodernen Modell von Anthropic, mit den gleichen Kosten und „ungefährer Geschwindigkeit“ wie Claude 3 Haiku mithalten können.

„Mit geringer Latenz, verbesserter Befehlsfolge und genauerer Tool-Nutzung eignet sich Claude 3.5 Haiku gut für benutzerorientierte Produkte, spezielle Subagentenaufgaben und die Generierung personalisierter Erlebnisse aus riesigen Datenmengen – wie Kaufhistorie, Preisgestaltung usw Bestandsdaten“, schrieb Anthropic in einem Blogbeitrag.

3.5 Haiku wird zunächst als Nur-Text-Modell und später als Teil eines multimodalen Pakets verfügbar sein, das sowohl Text als auch Bilder analysieren kann.

Wird es also, sobald 3.5 Haiku verfügbar ist, einen guten Grund geben, 3 Opus zu verwenden? Was ist mit 3.5 Opus, dem Nachfolger von 3 Opus, den Anthropic bereits im Juni angekündigt hat?

„Alle Modelle der Claude 3-Modellfamilie haben ihre individuellen Einsatzmöglichkeiten für Kunden“, sagte der Anthropic-Sprecher. „Claude 3.5 Opus steht auf unserer Roadmap und wir werden so schnell wie möglich mehr veröffentlichen.“

Tech hat einen KI-fokussierten Newsletter! Melden Sie sich hier an um es jeden Mittwoch in Ihrem Posteingang zu erhalten.