Wie machen Modelle des maschinellen Lernens ihre Aufgabe? Und „denken“ oder „argumentieren“ sie wirklich so, wie wir diese Dinge verstehen? Dies ist sowohl eine philosophische als auch eine praktische Frage, aber ein neues Papier, das am Freitag die Runde machte, legt nahe, dass die Antwort, zumindest vorerst, ein ziemlich klares „Nein“ ist.

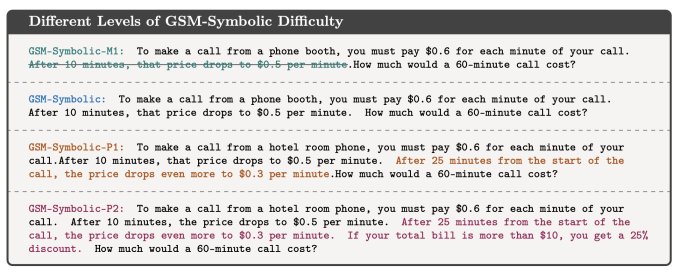

Eine Gruppe von KI-Forschern bei Apple veröffentlicht ihre Arbeit „Die Grenzen des mathematischen Denkens in großen Sprachmodellen verstehen“ zum allgemeinen Kommentar am Donnerstag. Während die tieferen Konzepte des symbolischen Lernens und der Musterreproduktion noch etwas in den Kinderschuhen stecken, ist das Grundkonzept ihrer Forschung sehr leicht zu verstehen.

Nehmen wir an, ich hätte Sie gebeten, ein einfaches mathematisches Problem wie dieses zu lösen:

Oliver pflückt am Freitag 44 Kiwis. Dann pflückt er am Samstag 58 Kiwis. Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag. Wie viele Kiwis hat Oliver?

Offensichtlich lautet die Antwort 44 + 58 + (44 * 2) = 190. Obwohl große Sprachmodelle in der Arithmetik tatsächlich mangelhaft sind, können sie so etwas ziemlich zuverlässig lösen. Aber was wäre, wenn ich ein paar zufällige Zusatzinformationen hinzufügen würde, etwa diese:

Oliver pflückt am Freitag 44 Kiwis. Dann pflückt er am Samstag 58 Kiwis. Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag. aber fünf davon waren etwas kleiner als der Durchschnitt. Wie viele Kiwis hat Oliver?

Es ist das gleiche mathematische Problem, oder? Und natürlich würde sogar ein Grundschüler wissen, dass auch eine kleine Kiwi noch eine Kiwi ist. Aber wie sich herausstellt, verwirrt dieser zusätzliche Datenpunkt selbst hochmoderne LLMs. Hier ist die Meinung von GPT-o1-mini:

… am Sonntag waren 5 dieser Kiwis kleiner als der Durchschnitt. Wir müssen sie von der Sonntagssumme abziehen: 88 (Sonntagskiwis) – 5 (kleinere Kiwis) = 83 Kiwis

Dies ist nur ein einfaches Beispiel von Hunderten von Fragen, die die Forscher leicht modifiziert haben, die aber fast alle zu einem enormen Rückgang der Erfolgsquoten der Modelle führten, die sie stellten.

Warum sollte das nun so sein? Warum sollte ein Modell, das das Problem versteht, so leicht durch ein zufälliges, irrelevantes Detail aus der Fassung gebracht werden? Die Forscher vermuten, dass dieser zuverlässige Fehlermodus dazu führt, dass die Modelle das Problem überhaupt nicht wirklich verstehen. Ihre Trainingsdaten ermöglichen es ihnen zwar, in manchen Situationen mit der richtigen Antwort zu antworten, aber sobald die geringste tatsächliche „Begründung“ erforderlich ist, etwa ob kleine Kiwis gezählt werden sollen, beginnen sie, seltsame, nicht intuitive Ergebnisse zu liefern.

Wie die Forscher es in ihrer Arbeit ausdrücken:

[W]Wir untersuchen die Fragilität des mathematischen Denkens in diesen Modellen und zeigen, dass sich ihre Leistung erheblich verschlechtert, wenn die Anzahl der Klauseln in einer Frage zunimmt. Wir vermuten, dass dieser Rückgang auf die Tatsache zurückzuführen ist, dass aktuelle LLMs nicht in der Lage sind, echte logische Überlegungen anzustellen; Stattdessen versuchen sie, die in ihren Trainingsdaten beobachteten Argumentationsschritte zu reproduzieren.

Diese Beobachtung steht im Einklang mit den anderen Qualitäten, die LLMs aufgrund ihrer Sprachkenntnisse häufig zugeschrieben werden. Wenn statistisch gesehen auf den Satz „Ich liebe dich“ ein „Ich liebe dich auch“ folgt, kann der LLM das leicht wiederholen – aber das bedeutet nicht, dass er dich liebt. Und obwohl es komplexen Denkketten folgen kann, denen es zuvor ausgesetzt war, deutet die Tatsache, dass diese Kette selbst durch oberflächliche Abweichungen unterbrochen werden kann, darauf hin, dass es nicht so sehr schlussfolgert, sondern vielmehr Muster repliziert, die es in seinen Trainingsdaten beobachtet hat.

Mehrdad Farajtabar, einer der Co-Autoren, gliedert den Artikel in diesem Thread zu X sehr gut auf.

Ein OpenAI-Forscher lobte zwar die Arbeit von Mirzadeh et al. widersprachen ihren SchlussfolgerungenEr sagte, dass in all diesen Fehlerfällen mit ein wenig zeitnaher Technik wahrscheinlich korrekte Ergebnisse erzielt werden könnten. Farajtabar (der mit der typischen, aber bewundernswerten Freundlichkeit reagierte, die Forscher normalerweise an den Tag legen) stellte fest, dass zwar eine bessere Aufforderung bei einfachen Abweichungen funktionieren kann, das Modell jedoch möglicherweise exponentiell mehr Kontextdaten erfordert, um komplexen Ablenkungen entgegenzuwirken – Ablenkungen, auf die ein Kind wiederum trivial hinweisen könnte aus.

Bedeutet das, dass LLMs nicht argumentieren? Vielleicht. Dass sie nicht argumentieren können? Niemand weiß es. Hierbei handelt es sich nicht um klar definierte Konzepte, und die Fragen tauchen meist am neuesten Stand der KI-Forschung auf, wo sich der Stand der Technik täglich ändert. Vielleicht „vernunft“ LLMs, aber in gewisser Weise erkennen wir es noch nicht oder wissen nicht, wie wir es kontrollieren können.

Es stellt eine faszinierende Grenze in der Forschung dar, ist aber auch eine warnende Geschichte, wenn es darum geht, wie KI verkauft wird. Kann es wirklich die Dinge tun, die es verspricht, und wenn ja, wie? Da KI zu einem alltäglichen Softwaretool wird, ist diese Art von Frage nicht mehr akademisch.