Hallo Leute, willkommen zum regelmäßigen KI-Newsletter von Tech. Wenn Sie dies jeden Mittwoch in Ihrem Posteingang haben möchten, melden Sie sich hier an.

Diese Woche erlangten synthetische Daten in der KI zunehmende Bedeutung.

OpenAI stellte letzten Donnerstag Canvas vor, eine neue Möglichkeit zur Interaktion mit ChatGPT, seiner KI-gestützten Chatbot-Plattform. Canvas öffnet ein Fenster mit einem Arbeitsbereich zum Schreiben und Codieren von Projekten. Benutzer können Text oder Code in Canvas generieren und dann bei Bedarf Abschnitte markieren, die mit ChatGPT bearbeitet werden sollen.

Aus Benutzersicht stellt Canvas eine große Verbesserung der Lebensqualität dar. Aber was ist am meisten Das Interessante an dieser Funktion ist für uns das fein abgestimmte Modell, das sie antreibt. OpenAI gibt an, sein GPT-4o-Modell mithilfe synthetischer Daten angepasst zu haben, um „neue Benutzerinteraktionen“ in Canvas zu ermöglichen.

„Wir haben neuartige Techniken zur Generierung synthetischer Daten verwendet, wie z. B. das Destillieren von Ausgaben aus der o1-Vorschau von OpenAI, um den GPT-4o so zu optimieren, dass er die Leinwand öffnet, gezielte Bearbeitungen vornimmt und hochwertige Kommentare inline hinterlässt“, sagt ChatGPT-Produktleiter Nick Turley schrieb in a Beitrag auf X. „Dieser Ansatz ermöglichte es uns, das Modell schnell zu verbessern und neue Benutzerinteraktionen zu ermöglichen, ohne auf von Menschen generierte Daten angewiesen zu sein.“

OpenAI ist nicht das einzige Big-Tech-Unternehmen, das beim Training seiner Modelle zunehmend auf synthetische Daten setzt.

Bei der Entwicklung von Movie Gen, einer Reihe KI-gestützter Tools zum Erstellen und Bearbeiten von Videoclips, verließ sich Meta teilweise auf synthetische Untertitel, die von einem Ableger seiner Llama-3-Modelle generiert wurden. Das Unternehmen rekrutierte ein Team menschlicher Annotatoren, um Fehler in diesen Bildunterschriften zu beheben und mehr Details hinzuzufügen, aber der Großteil der Vorarbeiten erfolgte weitgehend automatisiert.

Sam Altman, CEO von OpenAI, hat argumentiert, dass KI dies tun wird eines Tages synthetische Daten erzeugen, die gut genug sind, um sich selbst effektiv zu trainieren. Das wäre für Firmen wie OpenAI von Vorteil, die ein Vermögen für menschliche Annotatoren und Datenlizenzen ausgeben.

Meta hat die Llama 3-Modelle selbst mithilfe synthetischer Daten verfeinert. Und OpenAI soll für sein Modell der nächsten Generation mit dem Codenamen Orion synthetische Trainingsdaten von o1 beziehen.

Doch ein Ansatz, bei dem synthetische Daten an erster Stelle stehen, birgt Risiken. Ein Forscher hat mich kürzlich darauf hingewiesen, dass die Modelle, die zur Generierung synthetischer Daten verwendet werden, unvermeidlich halluzinieren (also Dinge erfinden) und Vorurteile und Einschränkungen enthalten. Diese Mängel manifestieren sich in den generierten Daten der Modelle.

Die sichere Verwendung synthetischer Daten erfordert daher eine gründliche Kuratierung und Filterung – wie es bei von Menschen generierten Daten üblich ist. Andernfalls könnte dies der Fall sein zum Zusammenbruch des Modells führenbei dem ein Modell in seinen Ausgaben weniger „kreativ“ – und voreingenommener – wird, was schließlich seine Funktionalität ernsthaft beeinträchtigt.

Dies ist im großen Maßstab keine leichte Aufgabe. Aber mit realen Trainingsdaten teurer (ganz zu schweigen von der Herausforderung, sie zu bekommen) sehen KI-Anbieter möglicherweise synthetische Daten als den einzigen gangbaren Weg nach vorn. Hoffen wir, dass sie bei der Übernahme Vorsicht walten lassen.

Nachricht

Anzeigen in KI-Übersichten: Google kündigt an, bald Anzeigen in KI-Übersichten zu schalten, den KI-generierten Zusammenfassungen, die es für bestimmte Google-Suchanfragen bereitstellt.

Google Lens, jetzt mit Video: Lens, die visuelle Such-App von Google, wurde um die Möglichkeit erweitert, Fragen zu Ihrer Umgebung nahezu in Echtzeit zu beantworten. Sie können ein Video über Lens aufnehmen und Fragen zu interessanten Objekten im Video stellen. (Wahrscheinlich wird es auch dafür Werbung geben.)

Von Sora bis DeepMind: Tim Brooks, einer der Leiter des OpenAI-Videogenerators Sora, ist zum Rivalen Google DeepMind gewechselt. Brooks kündigte in einem Beitrag auf X an, dass er an Technologien zur Videoerzeugung und „Weltsimulatoren“ arbeiten werde.

Es wird aufgefluxt: Black Forest Labs, das von Andreessen Horowitz unterstützte Startup hinter der Bildgenerierungskomponente des Grok-Assistenten von xAI, hat eine API in der Betaphase gestartet – und ein neues Modell veröffentlicht.

Nicht so transparent: Das kürzlich in Kalifornien verabschiedete AB-2013-Gesetz verpflichtet Unternehmen, die generative KI-Systeme entwickeln, eine allgemeine Zusammenfassung der Daten zu veröffentlichen, die sie zum Trainieren ihrer Systeme verwendet haben. Bisher sind nur wenige Unternehmen bereit zu sagen, ob sie den Anforderungen nachkommen werden. Das Gesetz gibt ihnen bis Januar 2026 Zeit.

Forschungspapier der Woche

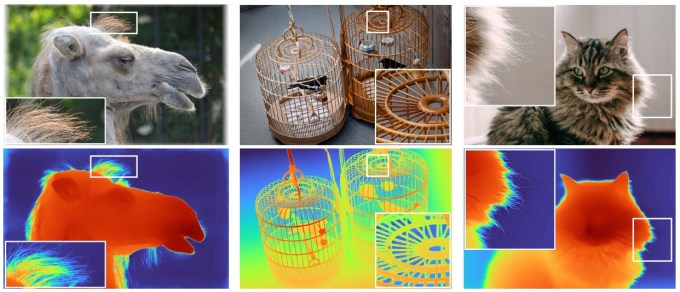

Apple-Forscher arbeiten seit Jahren intensiv an der Computerfotografie, und ein wichtiger Aspekt dieses Prozesses ist die Tiefenkartierung. Ursprünglich wurde dies mit Stereoskopie oder einem speziellen Tiefensensor wie einer Lidar-Einheit durchgeführt, aber diese sind in der Regel teuer und komplex und beanspruchen wertvollen internen Platz. Es ist in vielerlei Hinsicht vorzuziehen, dies ausschließlich in Software zu tun. Darum geht es in diesem Artikel, Depth Pro.

Aleksei Bochkovskii et al. Teilen Sie eine Methode für die monokulare Tiefenschätzung ohne Aufnahme und mit hoher Detailgenauigkeit, d. h. es verwendet eine einzige Kamera, muss nicht auf bestimmte Dinge trainiert werden (wie es auf einem Kamel funktioniert, obwohl man nie eines sieht) und fängt sogar schwierige Aspekte wie Haarbüschel ein . Es wird mit ziemlicher Sicherheit derzeit auf iPhones verwendet (obwohl es sich wahrscheinlich um eine verbesserte, speziell angefertigte Version handelt), aber Sie können es ausprobieren, wenn Sie mithilfe von selbst eine kleine Tiefenschätzung durchführen möchten den Code auf dieser GitHub-Seite.

Modell der Woche

Google hat ein neues Modell seiner Gemini-Familie herausgebracht, das Gemini 1.5 Flash-8B, das seiner Meinung nach zu den leistungsstärksten Modellen zählt.

Gemini 1.5 Flash-8B ist eine „destillierte“ Version von Gemini 1.5 Flash, die bereits auf Geschwindigkeit und Effizienz optimiert wurde. Sie kostet 50 % weniger in der Nutzung, hat eine geringere Latenz und verfügt über doppelt so hohe Ratenlimits in AI Studio, Googles KI-fokussiertem Programm Entwicklerumgebung.

„Flash-8B erreicht in vielen Benchmarks nahezu die Leistung des im Mai eingeführten 1,5-Flash-Modells“, schreibt Google in einem Blogbeitrag. „Unsere Modelle [continue] um uns durch das Feedback der Entwickler und unsere eigenen Tests darüber zu informieren, was möglich ist.“

Gemini 1.5 Flash-8B eignet sich gut für Chat, Transkription und Übersetzung, sagt Google, oder jede andere Aufgabe, die „einfach“ und „hochvolumig“ ist. Zusätzlich zu AI Studio ist das Modell auch kostenlos über die Gemini API von Google verfügbar, die Rate ist auf 4.000 Anfragen pro Minute begrenzt.

Wundertüte

Apropos billige KI: Anthropic hat eine neue Funktion veröffentlicht, die Message Batches API, mit der Entwickler große Mengen an KI-Modellabfragen für weniger Geld asynchron verarbeiten können.

Ähnlich wie bei den Batch-Anfragen von Google für die Gemini API können Entwickler, die die Message Batches API von Anthropic verwenden, Batches bis zu einer bestimmten Größe – 10.000 Abfragen – pro Batch senden. Jeder Stapel wird innerhalb von 24 Stunden verarbeitet und kostet 50 % weniger als Standard-API-Aufrufe.

Anthropic sagt, dass die Message Batches API ideal für „groß angelegte“ Aufgaben wie Datensatzanalyse, Klassifizierung großer Datensätze und Modellbewertungen ist. „Zum Beispiel“, schreibt das Unternehmen in einem Post„Die Analyse ganzer Unternehmensdokument-Repositories – die Millionen von Dateien umfassen können – wird durch die Nutzung wirtschaftlicher [this] Mengenrabatt.“

Die Message Batches API ist in der öffentlichen Betaversion verfügbar und unterstützt die Modelle Claude 3.5 Sonnet, Claude 3 Opus und Claude 3 Haiku von Anthropic.