Apple Intelligence, die neuen KI-Funktionen des iPhone-Herstellers, die in iOS 18 verfügbar sind, legt den Grundstein für eine neue Art der App-Nutzung.

Heute ist das veraltete App Store-Modell ständigem regulatorischen Angriff ausgesetzt. Inzwischen können Benutzer viele Aufgaben mit relativ einfachen Fragen an einen KI-Assistenten wie ChatGPT erledigen. Befürworter glauben, dass KI die bevorzugte Methode werden könnte, mit der wir nach Antworten suchen, bei der Arbeit produktiv sein und mit Kreativität experimentieren.

Wo bleibt die Welt der Apps und der wachsenden Dienstleistungen Einnahmen (mehr als 6 Milliarden Dollar im letzten Quartal) die sie für Apple generieren?

Die Antwort betrifft den Kern der KI-Strategie von Apple.

Apple-Intelligenz selbst bietet nur einen kleinen Satz sofort einsatzbereiter Funktionen, wie Schreibhilfen, Zusammenfassungstools, generative Kunst und andere grundlegende Angebote.

Doch Anfang dieses Jahres stellte Apple auf der Worldwide Developers Conference (WWDC) im Juni neue Funktionen vor, die es den Apps der Entwickler ermöglichen, sich enger mit Siri und Apple Intelligence zu verbinden.

Verbesserungen am intelligenten Assistenten ermöglichen es Siri, jedes Element aus dem Menü einer App aufzurufen, ohne dass ein Entwickler zusätzliche Arbeit leisten muss. Das bedeutet, dass Benutzer Siri beispielsweise bitten könnten, „mir meine Referentennotizen“ in einem Foliensatz zu zeigen, und Siri wüsste, was zu tun ist. Siri kann auch auf jeden auf der Seite angezeigten Text zugreifen, sodass Benutzer auf das, was auf ihrem Bildschirm angezeigt wird, verweisen und darauf reagieren können.

Wenn Sie also Ihre Erinnerung ansehen, um einem Familienmitglied „Alles Gute zum Geburtstag“ zu wünschen, könnten Sie etwas sagen wie „Machen Sie mit ihm per FaceTime weiter“ und Siri wüsste, was zu tun ist.

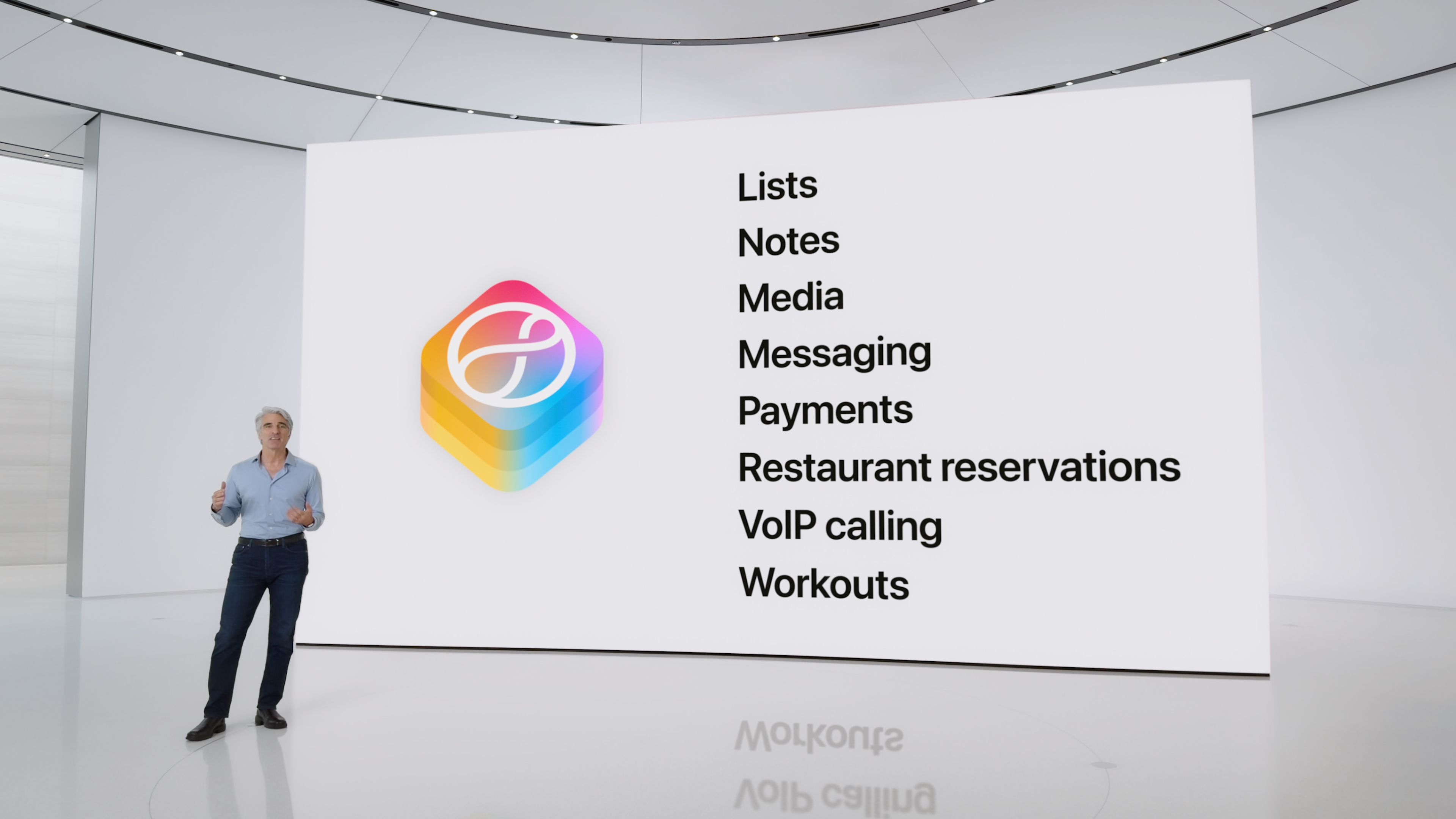

Das ist schon ein Upgrade der Grundfunktionen, die Siri heute bietet, aber das ist noch nicht alles. Apple stellt Entwicklern auch Tools zur Verfügung, mit denen sie Apple Intelligence in ihren eigenen Apps verwenden können. Auf der WWDC gab das Unternehmen an, dass Apple Intelligence zunächst für bestimmte App-Kategorien verfügbar gemacht werden soll, darunter Bücher, Browser, Kameras, Dokumentenleser, Dateiverwaltung, Journale, E-Mail, Fotos, Präsentationen, Tabellenkalkulationen, Whiteboards und Textverarbeitungsprogramme. Mit der Zeit wird Apple diese Funktionen wahrscheinlich allen Entwicklern im gesamten App Store zugänglich machen.

Die KI-Funktionalität wird auf dem App Intents-Framework aufgebaut, das mit neuen Intents für Entwickler erweitert wird. Das letztendliche Ziel besteht darin, Benutzern die Interaktion mit Siri nicht nur zum Öffnen ihrer Apps zu ermöglichen, sondern auch von ihnen aus.

Das bedeutet, dass ein Benutzer nicht in den Menüs einer App herumstöbern muss, um die Funktion zu finden, die er zum Ausführen einer Aufgabe benötigt. Er könnte einfach Siri fragen.

Benutzer können diese Anfragen auch in einer natürlichen Gesprächssituation stellen und auf Dinge verweisen, die sich auf ihren persönlichen Kontext beziehen.

So könnten Sie beispielsweise eine Fotobearbeitungs-App wie Darkroom bitten, „ein filmisches Geschenk auf das Foto anzuwenden, das ich gestern von Ian gemacht habe.“ Die heutige Version von Siri würde sich gegen derartige Anfragen sträuben, aber die KI-gestützte Siri wüsste stattdessen, dass sie die Filter-Anwendungsabsicht der App nutzen muss und auch, auf welches Foto Sie diese anwenden möchten.

Laut Apple kann Siri auch dann Maßnahmen ergreifen, wenn Sie sich verhaspelt haben oder in Ihren Anweisungen auf einen früheren Teil des Gesprächs verwiesen haben.

Sie können auch anwendungsübergreifende Aktionen ausführen. Nachdem Sie beispielsweise Ihr Foto bearbeitet haben, können Sie Siri bitten, es in eine andere App wie „Notizen“ zu verschieben, ohne dass Sie irgendwo tippen müssen.

Darüber hinaus kann die Suchfunktion des iPhones, Spotlight, Daten aus Apps durchsuchen, indem sie App-Entitäten in ihren Index einbezieht. Dies bezieht sich auf das Verständnis von Apple Intelligence für Dinge wie Fotos, Nachrichten, Dateien, Kalenderereignisse und mehr.

Dieser subtilere Anwendungsfall für KI erfordert natürlich die Akzeptanz der Entwickler. Apple hat im Laufe der Jahre einige seiner größeren Entwickler und sogar einige seiner Indie-Entwickler mit seinen Umsatzbeteiligungsregeln vergrault, die es dem Unternehmen im Allgemeinen erlauben, 30 % der Einnahmen für Produkte und Dienstleistungen einzubehalten, die über eine App verkauft werden. Aber Entwickler könnten zurückgeholt werden, wenn Siri Apps, die zuvor in einer App-Bibliothek auf der Rückseite des Telefons versteckt waren, über Sprachbefehle leicht zugänglich macht.

Anstatt langweilige Onboarding-Bildschirme zu erstellen, die den Benutzern die Navigation und Verwendung ihrer App beibringen, könnten sich Entwickler darauf konzentrieren, sicherzustellen, dass Siri versteht, wie ihre App funktioniert und wie Benutzer nach den Dingen fragen, die sie darin tun möchten. Auf diese Weise könnten Benutzer über Siri mit der App interagieren, indem sie entweder sprechen oder Befehle eingeben, ähnlich wie sie heute mit einem KI-Chatbot wie ChatGPT interagieren.

Auch externe Entwickler profitieren von der neuen KI-Architektur von Apple.

Dank der Partnerschaft mit OpenAI kann Siri Anfragen an ChatGPT weiterleiten, wenn es keine Antwort hat. Mit der visuellen Suchfunktion der iPhone 16-Reihe ermöglicht Apple seinen Benutzern außerdem den Zugriff auf den Chatbot von OpenAI oder die Google-Suche, indem sie einfach auf die neue Kamerasteuerungstaste an der Seite tippen. So wird das, was sie durch den Sucher der Kamera sehen, in eine umsetzbare Abfrage umgewandelt.

Diese Entwicklungen werden sich nicht unmittelbar so revolutionär anfühlen wie die Einführung von etwas wie ChatGPT, da die Akzeptanzrate bei den Entwicklern wahrscheinlich unterschiedlich ausfallen wird.

Darüber hinaus scheinen diese Zukunftsversprechen noch in weiter Ferne zu liegen. In den neuesten Betaversionen von iOS 18 fühlt sich die Funktionalität unvollständig an. So oft ich überrascht war, was die neue Siri kann, so oft war ich verwirrt über die Dinge, die sie nicht kann. Das gilt auch für Apples eigene Apps. Sie können Siri beispielsweise in der Fotos-App bitten, ein Foto, das Sie gerade ansehen, an jemanden zu senden, aber Sie können sie nicht bitten, etwas Komplexeres zu tun, wie das Foto in einen Sticker zu verwandeln. Solange Siri nicht auf solche Hindernisse stößt, könnte die Nutzung der Funktionalität frustrierend sein.