KI-Modelle haben sich als sehr leistungsfähig erwiesen, doch welche Aufgaben sollen sie eigentlich übernehmen? Am liebsten Plackerei – und davon gibt es in Forschung und Lehre reichlich. Angewiesen hofft, sich auf die Art zeitaufwändiger Datenextraktionsarbeit spezialisieren zu können, die derzeit eine Spezialität müder Doktoranden und Praktikanten ist.

„Das Beste, was man mit KI erreichen kann, ist, das menschliche Erlebnis zu verbessern: die Zahl niederer Arbeiten zu reduzieren und die Menschen die Dinge tun zu lassen, die ihnen wichtig sind“, sagt CEO Karl Moritz. In der Welt der Forschung, in der er und die Mitbegründer Marc Bellemare und Richard Schlegel seit Jahren arbeiten, ist die Literaturrecherche eines der häufigsten Beispiele für diese „niedere Arbeit“.

In jedem Artikel werden frühere und verwandte Arbeiten zitiert, aber diese Quellen in der Flut der wissenschaftlichen Erkenntnisse zu finden, ist nicht einfach. Und manche, wie etwa systematische Übersichtsarbeiten, zitieren oder verwenden Daten von Tausenden von Quellen.

Für eine StudieMoritz erinnerte sich: „Die Autoren mussten sich 3.500 wissenschaftliche Veröffentlichungen ansehen, und viele davon erwiesen sich als nicht relevant. Es kostet eine Menge Zeit, eine winzige Menge nützlicher Informationen zu extrahieren – das schien etwas zu sein, das wirklich durch KI automatisiert werden sollte.“

Sie wussten, dass moderne Sprachmodelle das können: In einem Experiment wurde ChatGPT mit dieser Aufgabe betraut und es stellte sich heraus, dass es Daten mit einer Fehlerquote von 11 % extrahieren konnte. Wie viele Dinge, die LLMs können, ist das beeindruckend, aber bei Weitem nicht das, was die Leute wirklich brauchen.

„Das ist einfach nicht gut genug“, sagte Moritz. „Bei diesen Wissensaufgaben, so einfach sie auch sein mögen, ist es sehr wichtig, dass man keine Fehler macht.“

Das Kernprodukt von Reliant, Tabular, basiert teilweise auf einem LLM (LLaMa 3.1), ist aber durch andere proprietäre Techniken erweitert und damit wesentlich effektiver. Bei der oben genannten Extraktion aus mehreren tausend Studien sagten sie, dass es die gleiche Aufgabe ohne Fehler erledigte.

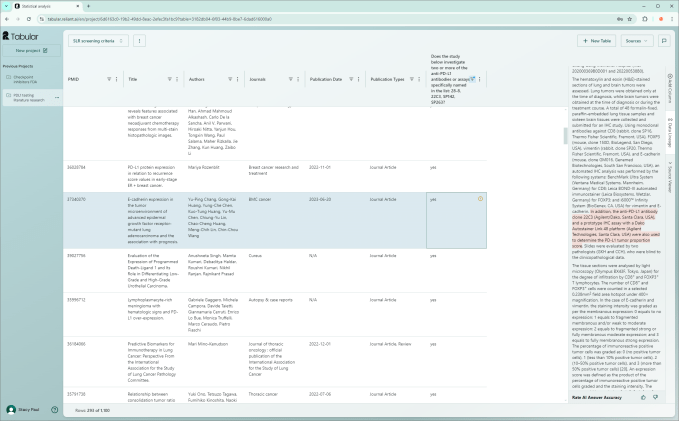

Das bedeutet: Sie laden tausend Dokumente hoch, sagen, Sie möchten diese, jene und andere Daten daraus, und Reliant durchforstet sie und findet diese Informationen – ob sie nun perfekt beschriftet und strukturiert sind oder (was viel wahrscheinlicher ist) nicht. Dann blendet es alle Daten und alle gewünschten Analysen in eine übersichtliche Benutzeroberfläche ein, sodass Sie sich in die einzelnen Fälle vertiefen können.

„Unsere Benutzer müssen mit allen Daten gleichzeitig arbeiten können, und wir entwickeln Funktionen, die es ihnen ermöglichen, die vorhandenen Daten zu bearbeiten oder von den Daten zur Literatur zu gelangen. Wir sehen unsere Rolle darin, den Benutzern dabei zu helfen, herauszufinden, worauf sie ihre Aufmerksamkeit richten sollen“, sagte Moritz.

Diese maßgeschneiderte und effektive Anwendung von KI – nicht so spektakulär wie ein digitaler Freund, aber mit ziemlicher Sicherheit viel praktikabler – könnte die Wissenschaft in einer Reihe hochtechnischer Bereiche voranbringen. Investoren haben dies erkannt und eine Seed-Runde von 11,3 Millionen US-Dollar finanziert. Tola Capital und Inovia Capital führten die Runde an, und Angel Mike Volpi beteiligte sich.

Wie jede Anwendung von KI ist auch Reliants Technologie sehr rechenintensiv. Deshalb hat das Unternehmen seine eigene Hardware gekauft, anstatt sie à la carte von einem der großen Anbieter zu mieten. Die Hardware selbst herzustellen, birgt sowohl Risiken als auch Chancen: Man muss dafür sorgen, dass sich diese teuren Maschinen amortisieren, aber man hat die Chance, den Problembereich mit dedizierter Rechenleistung zu knacken.

„Wir haben festgestellt, dass es sehr schwierig ist, eine gute Antwort zu geben, wenn man nur begrenzt Zeit dafür hat“, erklärt Moritz – zum Beispiel, wenn ein Wissenschaftler das System auffordert, eine neue Extraktions- oder Analyseaufgabe für hundert Papiere durchzuführen. Das kann schnell oder gut erledigt werden, aber nicht beides – es sei denn, sie sagen voraus, was die Benutzer könnte Fragen Sie und überlegen Sie sich die Antwort oder etwas Ähnliches im Voraus.

„Viele Leute haben die gleichen Fragen, also können wir die Antworten finden, bevor sie fragen, als Ausgangspunkt“, sagte Bellemare, der wissenschaftliche Leiter des Startups. „Wir können 100 Seiten Text in etwas anderes destillieren, das vielleicht nicht genau das ist, was Sie wollen, aber für uns einfacher zu verarbeiten ist.“

Denken Sie einmal so darüber nach: Wenn Sie die Bedeutung aus tausend Romanen extrahieren wollten, würden Sie warten, bis jemand nach den Namen der Charaktere fragt, um sie dann durchzugehen und herauszusuchen? Oder würden Sie diese Arbeit einfach im Voraus erledigen (zusammen mit Dingen wie Orten, Daten, Beziehungen usw.), weil Sie wissen, dass die Daten wahrscheinlich benötigt werden? Auf jeden Fall Letzteres – wenn Sie die nötige Rechenleistung hätten.

Diese Vorextraktion gibt den Modellen auch Zeit, die unvermeidlichen Mehrdeutigkeiten und Annahmen zu beseitigen, die in verschiedenen wissenschaftlichen Bereichen vorkommen. Wenn eine Metrik eine andere „angibt“, bedeutet dies in der Pharmazie möglicherweise nicht dasselbe wie in der Pathologie oder bei klinischen Studien. Darüber hinaus neigen Sprachmodelle dazu, unterschiedliche Ergebnisse zu liefern, je nachdem, wie ihnen bestimmte Fragen gestellt werden. Reliants Aufgabe bestand also darin, Mehrdeutigkeiten in Gewissheit zu verwandeln – „und das ist etwas, was Sie nur tun können, wenn Sie bereit sind, in eine bestimmte Wissenschaft oder einen bestimmten Bereich zu investieren“, bemerkte Moritz.

Als Unternehmen konzentriert sich Reliant zunächst darauf, sicherzustellen, dass sich die Technologie selbst trägt, bevor es ehrgeizigere Pläne wagt. „Um interessante Fortschritte zu machen, muss man eine große Vision haben, aber man muss auch mit etwas Konkretem beginnen“, sagte Moritz. „Aus der Sicht des Überlebens von Startups konzentrieren wir uns auf gewinnorientierte Unternehmen, weil sie uns Geld geben, um unsere GPUs zu bezahlen. Wir verkaufen das nicht mit Verlust an Kunden.“

Man könnte erwarten, dass das Unternehmen den Druck von Unternehmen wie OpenAI und Anthropic zu spüren bekommt, die Geld in die Übernahme strukturierterer Aufgaben wie Datenbankverwaltung und Codierung stecken, oder von Implementierungspartnern wie Cohere und Scale. Aber Bellemare war optimistisch: „Wir bauen dies auf einer Welle auf – jede Verbesserung unseres Technologie-Stacks ist großartig für uns. Das LLM ist eines von vielleicht acht großen Modellen für maschinelles Lernen darin – die anderen sind vollständig unser Eigentum und wurden von Grund auf auf der Grundlage unserer Daten entwickelt.“

Die Transformation der Biotech- und Forschungsbranche hin zu einer KI-gesteuerten Branche steht sicherlich erst am Anfang und wird in den kommenden Jahren wahrscheinlich eher Flickwerk sein. Aber Reliant scheint eine solide Ausgangsbasis gefunden zu haben.

„Wenn Sie die 95-Prozent-Lösung wollen und sich nur ab und zu bei einem Ihrer Kunden ausführlich entschuldigen, ist das großartig“, sagte Moritz. „Wir sind da, wo es wirklich auf Präzision und Rückruf ankommt und wo Fehler wirklich eine Rolle spielen. Und ehrlich gesagt, das reicht, den Rest überlassen wir gerne anderen.“