Es braucht nicht viel, um GenAI dazu zu bringen, Unwahrheiten und Unwahrheiten von sich zu geben.

Die vergangene Woche lieferte ein Beispiel: Die Chatbots von Microsoft und Google erklärten einen Super Bowl-Gewinner, bevor das Spiel überhaupt begann. Die wirklichen Probleme beginnen jedoch, wenn die Halluzinationen von GenAI schädlich werden – befürworten Folter, verstärkend ethnische und rassische Stereotypen und überzeugend schreiben über Verschwörungstheorien.

Immer mehr Anbieter, von etablierten Unternehmen wie Nvidia und Salesforce bis hin zu Start-ups wie CalypsoAI, bieten Produkte an, von denen sie behaupten, dass sie unerwünschte, toxische Inhalte von GenAI eindämmen können. Aber es sind Black Boxes; Ohne jedes einzelne Produkt zu testen, ist es unmöglich zu wissen, wie diese Produkte zur Halluzinationsbekämpfung im Vergleich abschneiden – und ob sie tatsächlich ihren Ansprüchen genügen.

Shreya Rajpal sah darin ein großes Problem – und gründete ein Unternehmen, Leitplanken KIum zu versuchen, es zu lösen.

„Die meisten Unternehmen … kämpfen mit den gleichen Problemen bei der verantwortungsvollen Bereitstellung von KI-Anwendungen und kämpfen darum, herauszufinden, was die beste und effizienteste Lösung ist“, sagte Rajpal gegenüber Tech in einem E-Mail-Interview. „Oft erfinden sie das Rad neu, wenn es um die Bewältigung der für sie wichtigen Risiken geht.“

Laut Rajpal deuten Umfragen darauf hin, dass Komplexität – und damit auch das Risiko – ein großes Hindernis für Unternehmen darstellt, die GenAI nutzen.

Ein kürzlich Umfrage von der Intel-Tochter Cnvrg.io stellte fest, dass etwa ein Viertel der Unternehmen, die GenAI-Apps implementieren, Bedenken hinsichtlich Compliance und Datenschutz, Zuverlässigkeit, hoher Implementierungskosten und mangelnder technischer Fähigkeiten teilten. In einem separaten Umfrage Von Riskonnect, einem Anbieter von Risikomanagement-Software, gaben mehr als die Hälfte der Führungskräfte an, sie seien besorgt darüber, dass Mitarbeiter Entscheidungen auf der Grundlage ungenauer Informationen von GenAI-Tools treffen könnten.

Rajpal, der zuvor beim selbstfahrenden Startup Drive.ai arbeitete und nach der Übernahme von Drive.ai durch Apple in Apples Spezialprojektgruppe arbeitete, war Mitbegründer von Guardrails mit Diego Oppenheimer, Safeer Mohiuddin und Zayd Simjee. Oppenheimer leitete zuvor Algorithmia, eine Betriebsplattform für maschinelles Lernen, während Mohiuddin und Simjee leitende Positionen im Bereich Technik und Technik bei AWS innehatten.

In mancher Hinsicht unterscheidet sich das Angebot von Guardrails nicht allzu sehr von dem, was bereits auf dem Markt ist. Die Plattform des Startups fungiert als Hülle für GenAI-Modelle, insbesondere Open-Source- und proprietäre (z. B. OpenAIs GPT-4) textgenerierende Modelle, um diese Modelle scheinbar vertrauenswürdiger, zuverlässiger und sicherer zu machen.

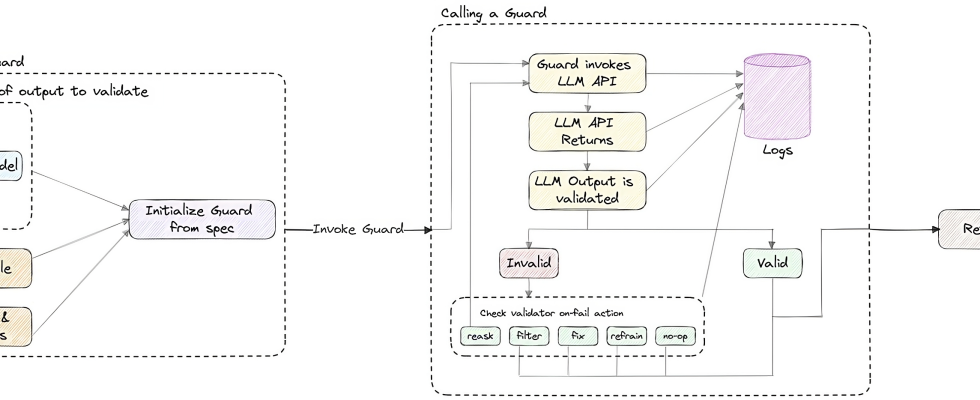

Bildnachweis: Leitplanken KI

Was Guardrails jedoch unterscheidet, ist sein Open-Source-Geschäftsmodell – die Codebasis der Plattform ist auf GitHub verfügbar und kostenlos nutzbar – und sein Crowdsourcing-Ansatz.

Über einen Marktplatz namens Guardrails Hub können Entwickler mit Guardrails modulare Komponenten namens „Validatoren“ einreichen, die GenAI-Modelle auf bestimmte Verhaltens-, Compliance- und Leistungsmetriken prüfen. Validatoren können von anderen Entwicklern und Guardrails-Kunden bereitgestellt, umfunktioniert und wiederverwendet werden und dienen als Bausteine für benutzerdefinierte GenAI-Modellmoderationslösungen.

„Unser Ziel ist es, mit dem Hub ein offenes Forum zu schaffen, um Wissen auszutauschen und den effektivsten Weg zu finden [further] KI-Einführung – aber auch, um eine Reihe wiederverwendbarer Leitplanken zu schaffen, die jedes Unternehmen übernehmen kann“, sagte Rajpal.

Die Validatoren im Guardrails Hub reichen von einfachen regelbasierten Prüfungen bis hin zu Algorithmen zur Erkennung und Behebung von Problemen in Modellen. Derzeit gibt es etwa 50 davon, von Detektoren für Halluzinationen und Richtlinienverstöße bis hin zu Filtern für proprietäre Informationen und unsicheren Code.

„Die meisten Unternehmen führen umfassende, einheitliche Prüfungen auf Schimpfwörter, personenbezogene Daten usw. durch“, sagte Rajpal. „Es gibt jedoch keine allgemeingültige Definition dessen, was eine akzeptable Nutzung für eine bestimmte Organisation und ein bestimmtes Team darstellt. Es gibt organisationsspezifische Risiken, die verfolgt werden müssen – beispielsweise sind die Kommunikationsrichtlinien verschiedener Organisationen unterschiedlich. Mit dem Hub ermöglichen wir es den Menschen, die von uns bereitgestellten Lösungen sofort zu nutzen oder sie zu nutzen, um eine starke Ausgangslösung zu erhalten, die sie weiter an ihre speziellen Bedürfnisse anpassen können.“

Eine Nabe für Modellgeländer ist eine faszinierende Idee. Aber der Skeptiker in mir fragt sich, ob Entwickler sich die Mühe machen werden, zu einer Plattform – und noch dazu einer noch jungen – beizutragen, ohne das Versprechen einer Entschädigung.

Rajpal ist der optimistischen Meinung, dass dies der Fall sein wird, und sei es aus keinem anderen Grund als der Anerkennung – und der selbstlosen Unterstützung der Branche beim Aufbau einer „sichereren“ GenAI.

„Der Hub ermöglicht es Entwicklern, die Arten von Risiken zu erkennen, denen andere Unternehmen ausgesetzt sind, und die Leitplanken zu sehen, die sie einrichten, um diese Risiken zu lösen und zu mindern“, fügte sie hinzu. „Die Validatoren sind eine Open-Source-Implementierung dieser Leitplanken, die Organisationen auf ihre Anwendungsfälle anwenden können.“

Guardrails AI, das noch keine Gebühren für Dienstleistungen oder Software erhebt, sammelte kürzlich 7,5 Millionen US-Dollar in einer von Zetta Venture Partners angeführten Seed-Runde unter Beteiligung von Factory, Pear VC, Bloomberg Beta, GitHub Fund und Partnern wie dem renommierten KI-Experten Ian Goodfellow. Rajpal sagt, dass der Erlös in die Erweiterung des sechsköpfigen Guardrails-Teams und weitere Open-Source-Projekte fließen wird.

„Wir sprechen mit so vielen Menschen – Unternehmen, kleinen Start-ups und einzelnen Entwicklern –, die aufgrund mangelnder Sicherheit und erforderlicher Risikominderung nicht in der Lage sind, GenAI-Anwendungen bereitzustellen“, fuhr sie fort. „Dies ist ein neuartiges Problem, das in diesem Ausmaß noch nicht existiert hat, da ChatGPT und Foundation-Modelle überall auf dem Vormarsch sind. Wir wollen diejenigen sein, die dieses Problem lösen.“