Google, das immer bestrebt ist, generative KI zu nutzen, führt eine neue Shopping-Funktion ein, die Kleidung einer Reihe echter Models zeigt.

Als Teil einer breiten Palette von Updates für Google Shopping, die in den kommenden Wochen eingeführt werden, nimmt Googles virtuelles Anprobetool für Bekleidung ein Bild von Kleidung auf und versucht vorherzusagen, wie sie fallen, falten, anliegen, sich dehnen und Falten und Schatten bilden würde an einer Reihe realer Modelle in verschiedenen Posen.

Die virtuelle Anprobe basiert auf einem neuen diffusionsbasierten Modell, das Google intern entwickelt hat. Diffusionsmodelle – zu denen die Text-zu-Kunst-Generatoren Stable Diffusion und DALL-E 2 gehören – lernen, Rauschen schrittweise von einem Ausgangsbild zu subtrahieren, das vollständig aus Rauschen besteht, und es so Schritt für Schritt näher an ein Ziel heranzuführen.

Google trainierte das Modell mit vielen Bildpaaren, die jeweils eine Person enthielten, die ein Kleidungsstück in zwei einzigartigen Posen trug – zum Beispiel ein Bild von jemandem, der ein Hemd trug, der seitwärts steht, und ein weiteres von ihnen, die nach vorne standen. Um das Modell robuster zu machen (d. h. visuelle Mängel wie Falten zu bekämpfen, die unförmig und unnatürlich wirken), wurde der Vorgang mit zufälligen Bildpaaren von Kleidungsstücken und Personen wiederholt.

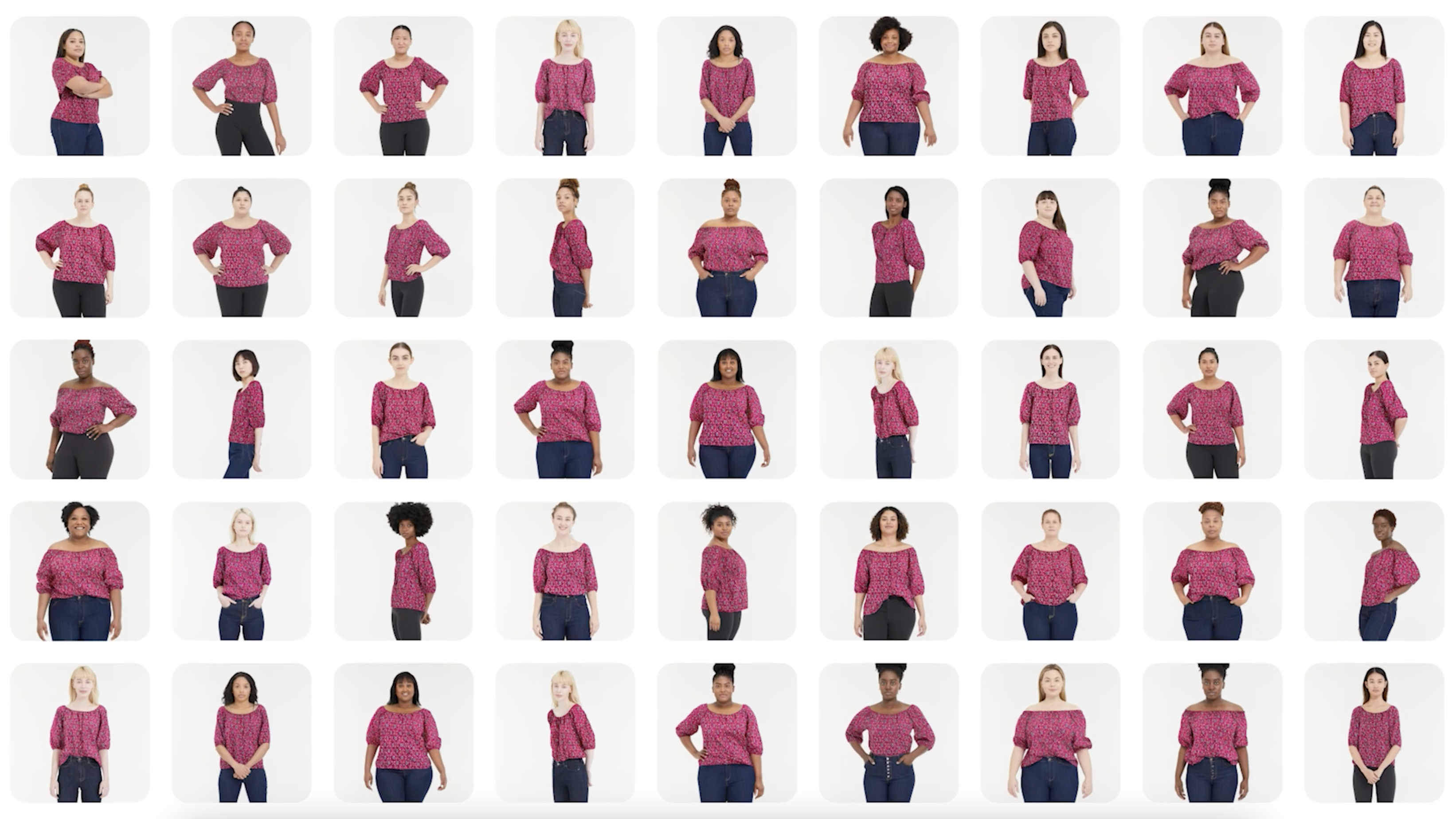

Googles neue KI-gestützte Anprobefunktion, die generative KI nutzt, um Kleidung an verschiedene Modelle anzupassen.

Ab heute können US-Käufer über Google Shopping Damenoberteile von Marken wie Anthropologie, Everlane, H&M und LOFT virtuell anprobieren. Halten Sie in der Google-Suche nach dem neuen „Try On“-Badge Ausschau. Herrenoberteile werden später im Jahr auf den Markt kommen.

„Wenn Sie Kleidung in einem Geschäft anprobieren, können Sie sofort erkennen, ob sie das Richtige für Sie ist“, schrieb Lilian Rincon, Senior Director of Consumer Shopping Product bei Google, in einem Blogbeitrag, der mit Tech geteilt wurde. Sie zitiert eine Umfrage, die zeigt, dass 42 % der Online-Käufer sich durch Bilder von Models nicht repräsentiert fühlen, während 59 % mit einem Artikel, den sie online gekauft haben, unzufrieden sind, weil er ihnen anders steht als erwartet.

„Sie sollten sich beim Online-Kauf von Kleidung genauso sicher fühlen“, fuhr Rincon fort.

Die virtuelle Anprobetechnologie ist nicht neu. Amazonas Und Adobe experimentieren seit einiger Zeit mit generativer Bekleidungsmodellierung, ebenso wie Walmart, das seit letztem Jahr eine Online-Funktion anbietet, bei der Kundenfotos zum Modellieren von Kleidung verwendet werden. Das KI-Startup AIMIRR geht noch einen Schritt weiter und nutzt Echtzeit-Rendering-Technologie für Kleidungsstücke, um Bilder von Kleidung über ein Live-Video einer Person zu legen.

Google selbst hat in der Vergangenheit in Zusammenarbeit mit L’Oréal, Estée Lauder, MAC Cosmetics, Black Opal und Charlotte Tilbury die virtuelle Anprobe-Technologie erprobt, um es Suchnutzern zu ermöglichen, Make-up-Farben bei einer Reihe von Modellen mit unterschiedlichen Hauttönen anzuprobieren.

Bildnachweis: Google

Da generative KI jedoch zunehmend in die Modebranche vordringt, stößt sie auf Widerstand von Models, die sagen, dass sie seit langem bestehende Ungleichheiten verschärft.

Models sind größtenteils schlecht bezahlte unabhängige Auftragnehmer. Am Haken für hohe Agenturprovisionen (~20 %) sowie Geschäftsausgaben wie Flugtickets, Gruppenunterkünfte und Werbematerialien, die erforderlich sind, um einen Job bei Kunden zu bekommen. Und da sie voreingenommene Einstellungspräferenzen widerspiegeln, sind sie ziemlich homogen. Laut einem UmfrageIm Jahr 2016 waren 78 % der Models in Modeanzeigen weiß.

Levi’s hat unter anderem KI-Technologie getestet, um maßgeschneiderte KI-generierte Modelle zu erstellen. Levi’s verteidigte die Technologie in Interviews und sagte, dass sie „die Vielfalt der Modelle erhöhen würde, die Käufer ihre Produkte tragen sehen können“. Das Unternehmen reagierte jedoch nicht auf die Nachfrage der Kritiker Warum die Marke nicht mehr Modelle mit den von ihr angestrebten vielfältigen Eigenschaften rekrutiert hat.

In dem Blogbeitrag betonte Rincon, dass Google sich dafür entschieden habe, echte Modelle zu verwenden – und ein vielfältiges Sortiment, das die Größen XXS bis 4XL umfasst und unterschiedliche Ethnien, Hauttöne, Körperformen und Haartypen repräsentiert. Aber sie ging nicht auf die Frage ein, ob die neue Anprobe-Funktion dazu führen könnte, dass die Fotoshooting-Möglichkeiten für Models später sinken.

Um das generative KI-Modell hinter seiner neuen Anprobefunktion zu trainieren, hat Google einen Datensatz aus Modellen und Kleidungsstücken zusammengestellt.

Zeitgleich mit der Einführung der virtuellen Anprobe führt Google Filteroptionen für die Suche nach Kleidung ein, die auf KI und visuellen Matching-Algorithmen basieren. Die Filter sind in den Produktlisten bei Shopping verfügbar und ermöglichen es Nutzern, ihre Suche anhand von Eingaben wie Farbe, Stil und Muster auf Filialen einzugrenzen.

„Mitarbeiter können dabei in einem Geschäft helfen, indem sie basierend auf dem, was Sie bereits anprobiert haben, andere Optionen vorschlagen und finden“, sagte Rincon. „Jetzt können Sie sich beim Online-Kauf von Kleidung eine zusätzliche Hand sichern.“