Es wird oft gesagt, dass Large Language Models (LLMs) nach dem Vorbild von OpenAIs ChatGPT eine Black Box sind, und sicherlich ist daran etwas Wahres. Selbst für Datenwissenschaftler ist es schwierig zu wissen, warum ein Modell immer so reagiert, wie es reagiert, als würde es Fakten aus einem Guss erfinden.

In dem Bemühen, die Schichten von LLMs abzuschälen, entwickelt OpenAI ein Tool, um automatisch zu identifizieren, welche Teile eines LLMs für welches seiner Verhaltensweisen verantwortlich sind. Die Ingenieure dahinter betonen, dass es sich in einem frühen Stadium befindet, aber der Code, um es auszuführen, ist seit heute Morgen als Open Source auf GitHub verfügbar.

„Wir versuchen es [develop ways to] antizipieren, was die Probleme mit einem KI-System sein werden“, sagte William Saunders, Manager des Interpretability-Teams bei OpenAI, Tech in einem Telefoninterview. „Wir wollen wirklich sicher sein können, dass wir darauf vertrauen können, was das Modell tut und welche Antwort es liefert.“

Zu diesem Zweck verwendet das Tool von OpenAI (ironischerweise) ein Sprachmodell, um die Funktionen der Komponenten anderer, architektonisch einfacherer LLMs herauszufinden – insbesondere von OpenAIs eigenem GPT-2.

Das Tool von OpenAI versucht, das Verhalten von Neuronen in einem LLM zu simulieren.

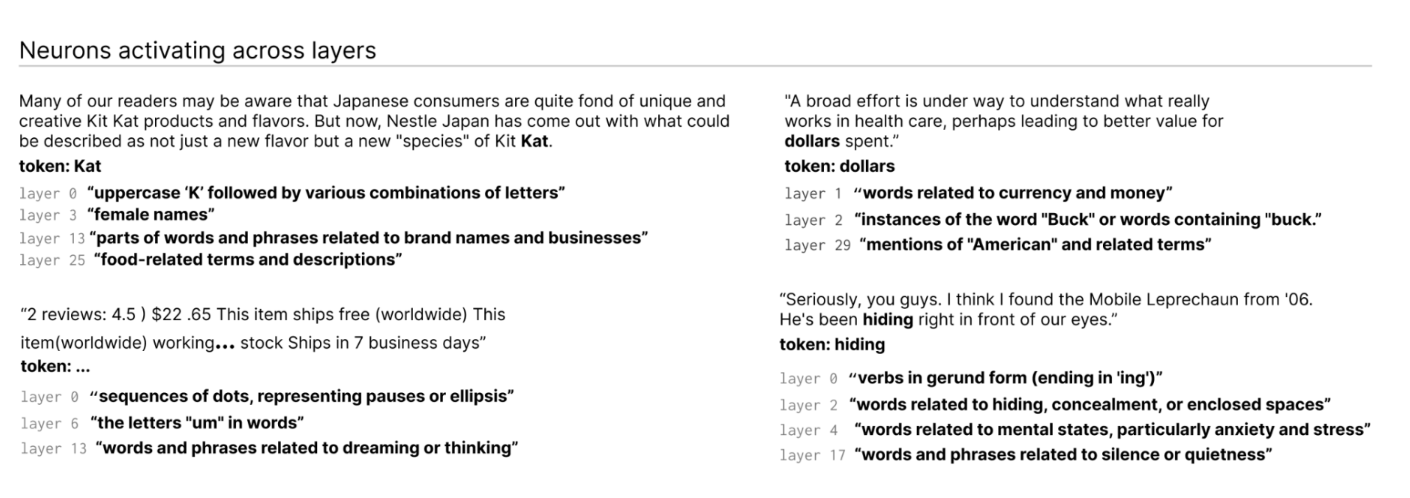

Wie? Zunächst eine kurze Erläuterung zu LLMs als Hintergrund. Wie das Gehirn bestehen sie aus „Neuronen“, die bestimmte Muster im Text beobachten, um zu beeinflussen, was das Gesamtmodell als nächstes „sagt“. Beispielsweise könnte ein „Marvel-Superhelden-Neuron“ bei einer Aufforderung zu Superhelden (z. B. „Welche Superhelden haben die nützlichsten Superkräfte?“) die Wahrscheinlichkeit erhöhen, dass das Modell bestimmte Superhelden aus Marvel-Filmen nennt.

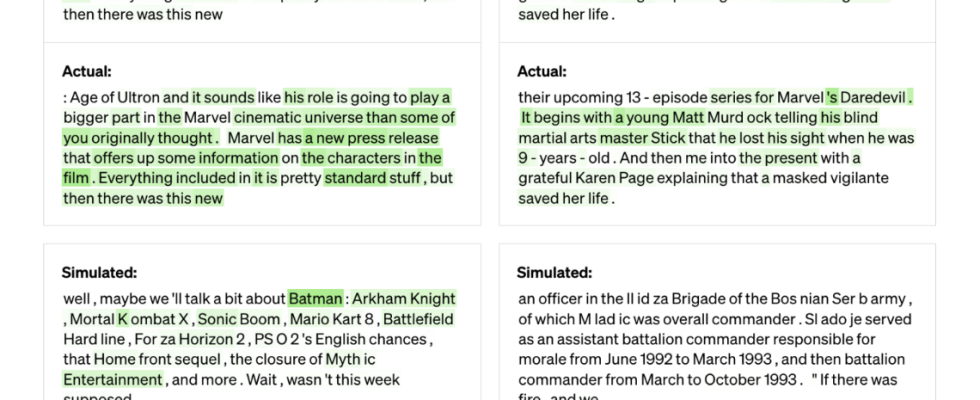

Das Tool von OpenAI nutzt dieses Setup, um Modelle in ihre Einzelteile zu zerlegen. Zunächst lässt das Tool Textsequenzen durch das zu evaluierende Modell laufen und wartet auf Fälle, in denen ein bestimmtes Neuron häufig „aktiviert“ wird. Als nächstes „zeigt“ es GPT-4, dem neuesten texterzeugenden KI-Modell von OpenAI, diese hochaktiven Neuronen und lässt GPT-4 eine Erklärung generieren. Um festzustellen, wie genau die Erklärung ist, versorgt das Tool GPT-4 mit Textsequenzen und lässt es vorhersagen oder simulieren, wie sich das Neuron verhalten würde. In vergleicht dann das Verhalten des simulierten Neurons mit dem Verhalten des tatsächlichen Neurons.

„Mit dieser Methodik können wir im Grunde für jedes einzelne Neuron eine Art vorläufige Erklärung in natürlicher Sprache dafür finden, was es tut, und auch eine Bewertung dafür haben, wie gut diese Erklärung mit dem tatsächlichen Verhalten übereinstimmt“, leitet Jeff Wu das Scalable-Alignment-Team bei OpenAI, sagte. „Wir verwenden GPT-4 als Teil des Prozesses, um Erklärungen dafür zu liefern, wonach ein Neuron sucht, und dann zu bewerten, wie gut diese Erklärungen mit der Realität dessen übereinstimmen, was es tut.“

Die Forscher konnten Erklärungen für alle 307.200 Neuronen in GPT-2 generieren, die sie in einem Datensatz zusammenstellten, der zusammen mit dem Tool-Code veröffentlicht wurde.

Tools wie dieses könnten eines Tages verwendet werden, um die Leistung eines LLM zu verbessern, sagen die Forscher – zum Beispiel, um Verzerrungen oder Toxizität zu reduzieren. Aber sie erkennen an, dass es noch ein langer Weg ist, bevor es wirklich nützlich ist. Das Tool war zuversichtlich in seinen Erklärungen für etwa 1.000 dieser Neuronen, einen kleinen Bruchteil der Gesamtzahl.

Eine zynische Person könnte auch argumentieren, dass das Tool im Wesentlichen eine Werbung für GPT-4 ist, da es GPT-4 benötigt, um zu funktionieren. Andere LLM-Interpretierbarkeitstools sind weniger abhängig von kommerziellen APIs wie DeepMind Tracrein Compiler, der Programme in neuronale Netzwerkmodelle übersetzt.

Wu sagte, das sei nicht der Fall – die Tatsache, dass das Tool GPT-4 verwende, sei nur „zufällig“ – und zeige im Gegenteil die Schwächen von GPT-4 in diesem Bereich. Er sagte auch, dass es nicht für kommerzielle Anwendungen entwickelt wurde und theoretisch angepasst werden könnte, um neben GPT-4 auch LLMs zu verwenden.

Das Tool identifiziert Neuronen, die über Schichten im LLM aktiviert werden.

„Die meisten Erklärungen schneiden ziemlich schlecht ab oder erklären nicht so viel vom Verhalten des tatsächlichen Neurons“, sagte Wu. „Viele der Neuronen zum Beispiel sind auf eine Weise aktiv, bei der es sehr schwer zu sagen ist, was vor sich geht – als würden sie bei fünf oder sechs verschiedenen Dingen aktiviert, aber es gibt kein erkennbares Muster. Manchmal dort Ist ein erkennbares Muster, aber GPT-4 kann es nicht finden.“

Ganz zu schweigen von komplexeren, neueren und größeren Modellen oder Modellen, die das Internet nach Informationen durchsuchen können. Aber zu diesem zweiten Punkt glaubt Wu, dass das Surfen im Internet die zugrunde liegenden Mechanismen des Tools nicht wesentlich ändern würde. Es könnte einfach optimiert werden, sagt er, um herauszufinden, warum Neuronen sich entscheiden, bestimmte Suchmaschinenanfragen zu stellen oder auf bestimmte Websites zuzugreifen.

„Wir hoffen, dass dies einen vielversprechenden Weg eröffnet, um die Interpretierbarkeit auf automatisierte Weise anzugehen, auf der andere aufbauen und zu der sie beitragen können“, sagte Wu. „Die Hoffnung ist, dass wir wirklich gute Erklärungen dafür haben, nicht nur worauf Neuronen reagieren, sondern insgesamt das Verhalten dieser Modelle – welche Arten von Schaltkreisen sie berechnen und wie bestimmte Neuronen andere Neuronen beeinflussen.“