Wie ein kommerziell ziemlich erfolgreicher Autor einmal schrieb: „Die Nacht ist dunkel und voller Schrecken, der Tag hell und schön und voller Hoffnung.“ Es ist eine passende Bildsprache für KI, die wie alle Technologien ihre Vor- und Nachteile hat.

Kunstgenerierende Modelle wie Stable Diffusion zum Beispiel haben zu unglaublichen Kreativitätsschüben geführt, die Apps und sogar völlig neue Geschäftsmodelle vorantreiben. Auf der anderen Seite ermöglicht es seine Open-Source-Natur schlechten Schauspielern, Deepfakes in großem Umfang zu erstellen – und das alles, während Künstler protestieren, dass es von ihrer Arbeit profitiert.

Was steht 2023 für KI an? Wird die Regulierung das Schlimmste von dem, was KI bringt, eindämmen, oder sind die Schleusen offen? Werden leistungsstarke, transformative neue Formen der KI entstehen, a la ChatGPT, und Branchen stören, die einst vor der Automatisierung sicher geglaubt wurden?

Erwarten Sie mehr (problematische) kunstgenerierende KI-Apps

Mit dem Erfolg von Lensa, der KI-gestützten Selfie-App von Prisma Labs, die viral wurde, können Sie viele Me-too-Apps in dieser Richtung erwarten. Und erwarten Sie, dass sie auch in der Lage sein werden, NSFW-Bilder zu erstellen, und dazu überproportional sexualisieren und verändern das Aussehen von Frauen.

Maximilian Gahntz, Senior Policy Researcher bei der Mozilla Foundation, sagte, er erwarte, dass die Integration generativer KI in die Verbrauchertechnologie die Auswirkungen solcher Systeme verstärken werde, sowohl die guten als auch die schlechten.

Stable Diffusion beispielsweise wurde mit Milliarden von Bildern aus dem Internet gefüttert, bis es „lernte“, bestimmte Wörter und Konzepte bestimmten Bildern zuzuordnen. Textgenerierende Modelle wurden routinemäßig leicht dazu verleitet, anstößige Ansichten zu vertreten oder irreführende Inhalte zu produzieren.

Mike Cook, ein Mitglied der offenen Forschungsgruppe Knives and Paintbrushes, stimmt Gahntz zu, dass sich die generative KI weiterhin als wichtige – und problematische – Kraft für Veränderungen erweisen wird. Aber er denkt, dass 2023 das Jahr sein muss, in dem die generative KI „endlich ihr Geld dort hinlegt, wo ihr Mund ist“.

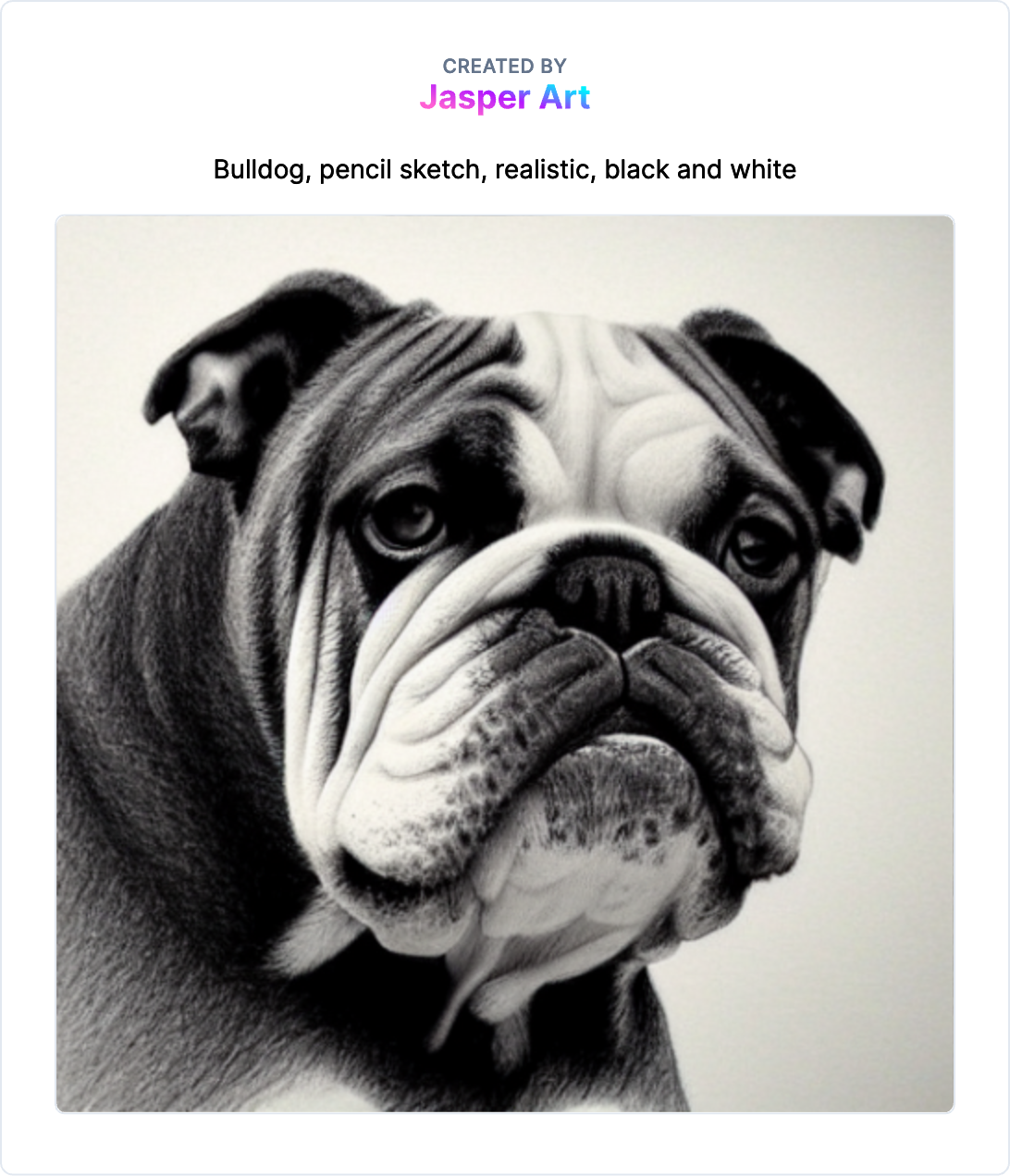

Prompt von Tech, Modell von Stability AI, generiert im kostenlosen Tool Dream Studio.

„Es reicht nicht aus, eine Gemeinschaft von Spezialisten zu motivieren [to create new tech] – Damit Technologie zu einem langfristigen Teil unseres Lebens wird, muss sie entweder jemandem viel Geld einbringen oder einen bedeutenden Einfluss auf das tägliche Leben der Allgemeinheit haben“, sagte Cook. „Ich sage also voraus, dass wir einen ernsthaften Vorstoß sehen werden, um generative KI tatsächlich eines dieser beiden Dinge zu erreichen, mit gemischtem Erfolg.“

Künstler führen die Bemühungen an, sich von Datensätzen abzumelden

DeviantArt hat einen KI-Kunstgenerator veröffentlicht, der auf Stable Diffusion basiert und auf Kunstwerken der DeviantArt-Community abgestimmt ist. Der Kunstgenerator stieß bei den langjährigen Bewohnern von DeviantArt auf lautstarke Ablehnung, die die mangelnde Transparenz der Plattform bei der Verwendung ihrer hochgeladenen Kunst zum Trainieren des Systems kritisierten.

Die Schöpfer der beliebtesten Systeme – OpenAI und Stability AI – sagen, dass sie Schritte unternommen haben, um die Menge an schädlichen Inhalten zu begrenzen, die ihre Systeme produzieren. Aber nach vielen Generationen in den sozialen Medien zu urteilen, ist klar, dass es noch viel zu tun gibt.

„Die Datensätze erfordern eine aktive Pflege, um diese Probleme anzugehen, und sollten einer eingehenden Prüfung unterzogen werden, auch von Communities, die dazu neigen, den Kürzeren zu ziehen“, sagte Gahntz und verglich den Prozess mit anhaltenden Kontroversen über die Moderation von Inhalten in sozialen Medien.

Stability AI, das die Entwicklung von Stable Diffusion weitgehend finanziert, hat sich kürzlich dem öffentlichen Druck gebeugt und signalisiert, dass es Künstlern ermöglichen würde, sich gegen den Datensatz zu entscheiden, der zum Trainieren des Stable Diffusion-Modells der nächsten Generation verwendet wird. Über die Website HaveIBeenTrained.com können Rechteinhaber Opt-outs beantragen, bevor das Training in einigen Wochen beginnt.

OpenAI bietet keinen solchen Opt-out-Mechanismus, sondern zieht es stattdessen vor, mit Organisationen wie Shutterstock zusammenzuarbeiten, um Teile ihrer Bildergalerien zu lizenzieren. Aber angesichts des rechtlichen und rein öffentlichen Gegenwinds, dem es neben Stability AI ausgesetzt ist, ist es wahrscheinlich nur eine Frage der Zeit, bis es nachzieht.

Die Gerichte können letztendlich seine Hand zwingen. In den USA sind Microsoft, GitHub und OpenAI dabei verklagt in einer Sammelklage angeklagt, in der sie beschuldigt werden, gegen das Urheberrecht verstoßen zu haben, indem sie Copilot, den Dienst von GitHub, der intelligent Codezeilen vorschlägt, Abschnitte des lizenzierten Codes ohne Angabe von Quellen wieder hervorwürgen.

Vielleicht in Erwartung der rechtlichen Anfechtung hat GitHub kürzlich Einstellungen hinzugefügt, um zu verhindern, dass öffentlicher Code in den Vorschlägen von Copilot auftaucht, und plant die Einführung einer Funktion, die auf die Quelle von Codevorschlägen verweist. Aber sie sind unvollkommene Maßnahmen. In mindestens einem Fall führte die Filtereinstellung dazu, dass Copilot große Teile urheberrechtlich geschützten Codes ausgab, einschließlich aller Zuordnungs- und Lizenztexte.

Erwarten Sie im kommenden Jahr eine Zunahme der Kritik, insbesondere da das Vereinigte Königreich über Regeln nachdenkt, die die Anforderung beseitigen würden, dass Systeme, die durch öffentliche Daten trainiert werden, streng nicht kommerziell verwendet werden.

Open Source und dezentralisierte Bemühungen werden weiter zunehmen

2022 dominierte eine Handvoll KI-Unternehmen die Bühne, vor allem OpenAI und Stability AI. Aber das Pendel könnte 2023 wieder in Richtung Open Source schwingen, da die Fähigkeit, neue Systeme zu bauen, über „ressourcenreiche und leistungsstarke KI-Labore“ hinausgeht, wie Gahntz es ausdrückte.

Ein Community-Ansatz kann zu einer genaueren Prüfung von Systemen führen, während sie gebaut und bereitgestellt werden, sagte er: „Wenn Modelle offen sind und wenn Datensätze offen sind, wird dies viel mehr kritische Forschung ermöglichen, die auf viele Mängel und Schäden im Zusammenhang mit generativer KI hingewiesen hat und die oft viel zu schwierig durchzuführen war.“

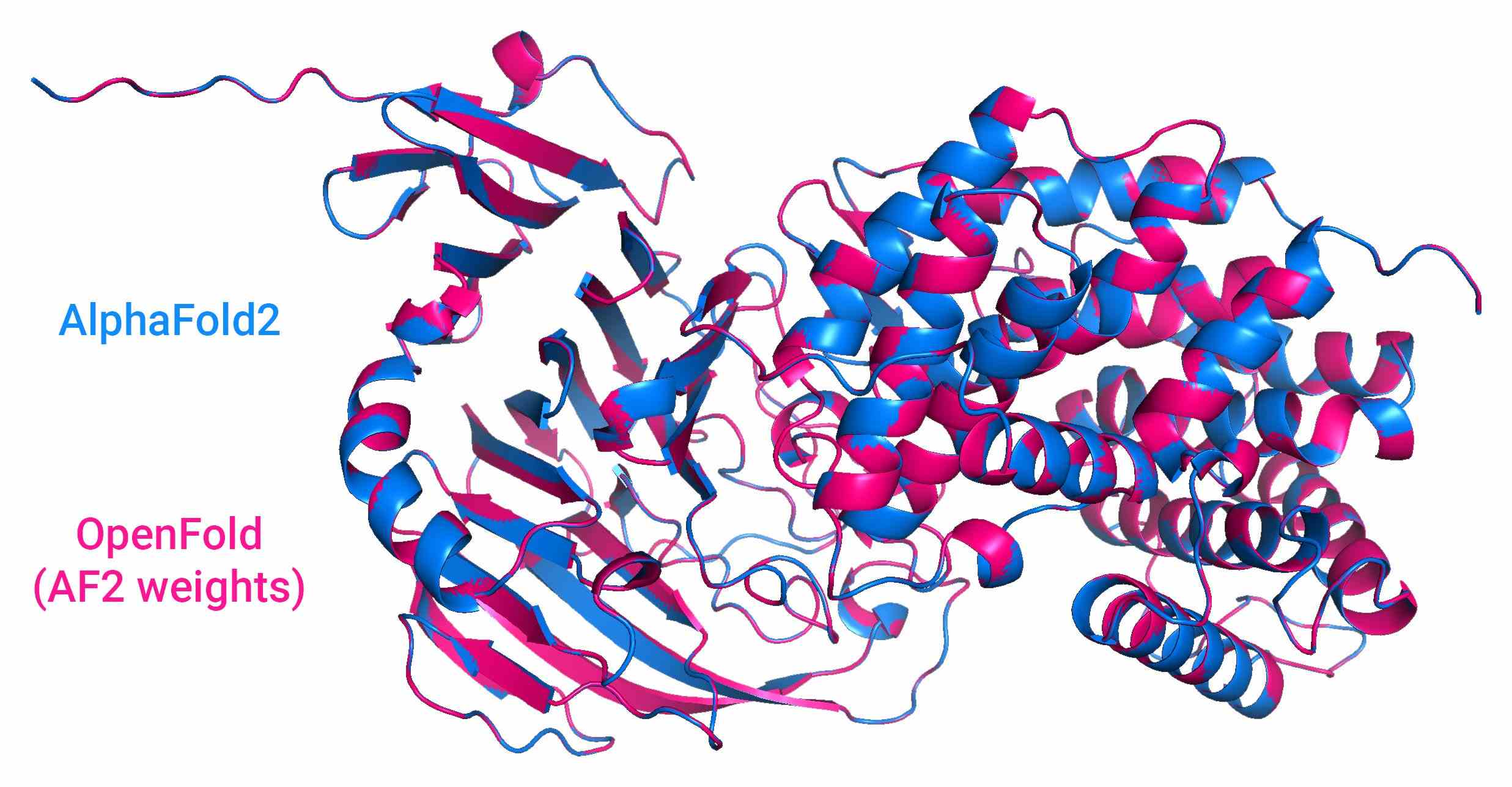

Bildnachweis: Ergebnisse von OpenFold, einem Open-Source-KI-System, das die Formen von Proteinen vorhersagt, im Vergleich zu AlphaFold2 von DeepMind.

Beispiele für solche gemeinschaftsorientierten Bemühungen sind große Sprachmodelle von EleutherAI und BigScience, eine Initiative, die vom KI-Startup Hugging Face unterstützt wird. Stability AI finanziert selbst eine Reihe von Gemeinschaften, wie das auf die Musikgeneration ausgerichtete Harmonai und OpenBioML, eine lose Sammlung von Biotech-Experimenten.

Geld und Fachwissen sind immer noch erforderlich, um anspruchsvolle KI-Modelle zu trainieren und auszuführen, aber dezentralisiertes Computing kann traditionelle Rechenzentren herausfordern, wenn Open-Source-Bemühungen ausgereift sind.

BigScience hat mit der kürzlichen Veröffentlichung des Open-Source-Projekts Petals einen Schritt in Richtung Ermöglichung einer dezentralen Entwicklung getan. Petals ermöglicht es Menschen, ihre Rechenleistung, ähnlich wie Folding@home, einzusetzen, um große KI-Sprachmodelle auszuführen, die normalerweise eine High-End-GPU oder einen Server erfordern würden.

„Moderne generative Modelle sind rechenintensiv zu trainieren und auszuführen. Einige Schätzungen auf der Rückseite des Umschlags beziffern die täglichen ChatGPT-Ausgaben auf etwa 3 Millionen US-Dollar“, sagte Chandra Bhagavatula, eine leitende Forschungswissenschaftlerin am Allen Institute for AI, per E-Mail. „Um dies kommerziell rentabel und breiter zugänglich zu machen, wird es wichtig sein, dies anzugehen.“

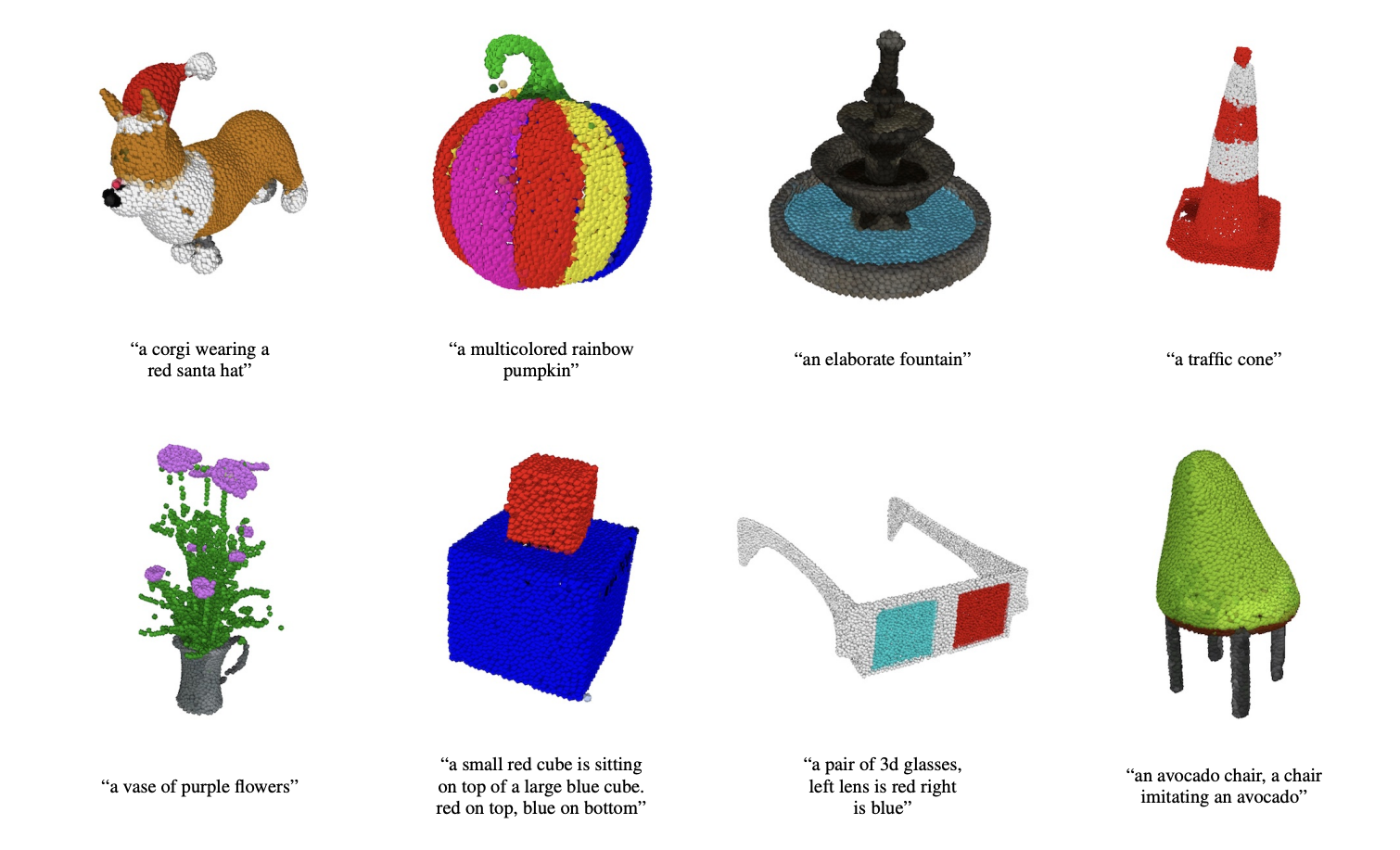

Chandra weist jedoch darauf hin, dass große Labore weiterhin Wettbewerbsvorteile haben werden, solange die Methoden und Daten proprietär bleiben. In einem aktuellen Beispiel veröffentlichte OpenAI Point-E, ein Modell, das 3D-Objekte bei einer Texteingabeaufforderung generieren kann. Aber während OpenAI das Modell als Open Source veröffentlichte, gab es die Quellen der Trainingsdaten von Point-E nicht bekannt oder veröffentlichte diese Daten nicht.

Point-E erzeugt Punktwolken.

„Ich denke, die Bemühungen um Open Source und die Dezentralisierung sind absolut lohnenswert und kommen einer größeren Anzahl von Forschern, Praktikern und Benutzern zugute“, sagte Chandra. „Trotz Open Source sind die besten Modelle jedoch für eine große Anzahl von Forschern und Praktikern aufgrund ihrer Ressourcenbeschränkungen immer noch nicht zugänglich.“

KI-Unternehmen beugen sich eingehenden Vorschriften

Regulierungen wie das KI-Gesetz der EU können die Entwicklung und den Einsatz von KI-Systemen in Zukunft durch Unternehmen verändern. Könnten also weitere lokale Bemühungen wie das KI-Einstellungsgesetz von New York City erfolgen, das vorschreibt, dass KI- und algorithmenbasierte Technologien für die Rekrutierung, Einstellung oder Beförderung auf Voreingenommenheit geprüft werden, bevor sie verwendet werden.

Chandra hält diese Vorschriften für notwendig, insbesondere angesichts der zunehmend offensichtlichen technischen Mängel der generativen KI, wie ihrer Tendenz, sachlich falsche Informationen zu verbreiten.

„Dies erschwert die Anwendung generativer KI in vielen Bereichen, in denen Fehler sehr hohe Kosten verursachen können – z. B. im Gesundheitswesen. Darüber hinaus schafft die Leichtigkeit, falsche Informationen zu generieren, Herausforderungen im Zusammenhang mit Fehlinformationen und Desinformationen“, sagte sie. „[And yet] KI-Systeme treffen bereits Entscheidungen, die mit moralischen und ethischen Implikationen behaftet sind.“

Das nächste Jahr wird jedoch nur die Androhung einer Regulierung bringen – erwarten Sie viel mehr Spitzfindigkeiten über Regeln und Gerichtsverfahren, bevor jemand mit einer Geldstrafe belegt oder angeklagt wird. Aber Unternehmen können immer noch um Positionen in den vorteilhaftesten Kategorien kommender Gesetze kämpfen, wie z. B. den Risikokategorien des KI-Gesetzes.

Die derzeitige Regel teilt KI-Systeme in eine von vier Risikokategorien mit jeweils unterschiedlichen Anforderungen und Prüfungsebenen ein. Systeme der höchsten Risikokategorie, „High-Risk“-KI (z. B. Kreditwürdigkeitsalgorithmen, Roboterchirurgie-Apps), müssen bestimmte rechtliche, ethische und technische Standards erfüllen, bevor sie auf den europäischen Markt gelangen dürfen. Die niedrigste Risikokategorie, „minimales oder kein Risiko“, KI (z. B. Spamfilter, KI-fähige Videospiele), erlegt nur Transparenzverpflichtungen auf, wie z. B. die Information der Benutzer, dass sie mit einem KI-System interagieren.

Os Keyes, ein Ph.D. Ein Kandidat an der University of Washington äußerte sich besorgt darüber, dass Unternehmen das niedrigste Risikoniveau anstreben, um ihre eigene Verantwortung und Sichtbarkeit für die Aufsichtsbehörden zu minimieren.

„Abgesehen von dieser Sorge, [the AI Act] wirklich das Positivste, was ich auf dem Tisch sehe“, sagten sie. „Ich habe nicht viel gesehen irgendetwas aus dem Kongress.“

Aber Investitionen sind keine sichere Sache

Gahntz argumentiert, dass, selbst wenn ein KI-System für die meisten Menschen gut genug funktioniert, für einige jedoch zutiefst schädlich ist, „noch viele Hausaufgaben übrig bleiben“, bevor ein Unternehmen es allgemein verfügbar machen sollte. „Für all das gibt es auch einen Business Case. Wenn Ihr Modell eine Menge durcheinandergebrachtes Zeug erzeugt, werden die Verbraucher es nicht mögen“, fügte er hinzu. „Aber natürlich geht es auch um Fairness.“

Es ist unklar, ob die Unternehmen von diesem Argument im nächsten Jahr überzeugt werden, zumal die Investoren offenbar bestrebt sind, ihr Geld über eine vielversprechende generative KI hinaus zu investieren.

Inmitten der Stable Diffusion-Kontroversen sammelte Stability AI 101 Millionen US-Dollar bei einer Bewertung von über 1 Milliarde US-Dollar von prominenten Unterstützern, darunter Coatue und Lightspeed Venture Partners. OpenAI ist sagte bei Eintritt auf 20 Milliarden Dollar geschätzt werden fortgeschrittene Gespräche mehr Mittel von Microsoft zu beschaffen. (vorher Microsoft investiert 1 Milliarde US-Dollar in OpenAI im Jahr 2019.)

Das können natürlich Ausnahmen von der Regel sein.

Bildnachweis: Jaspis

Abgesehen von den selbstfahrenden Unternehmen Cruise, Wayve und WeRide und dem Robotikunternehmen MegaRobo waren laut Crunchbase die leistungsstärksten KI-Unternehmen in Bezug auf das in diesem Jahr gesammelte Geld softwarebasiert. Contentsquare, das einen Dienst verkauft, der KI-gesteuerte Empfehlungen für Webinhalte bereitstellt, schloss im Juli eine 600-Millionen-Dollar-Runde ab. Uniphore, das Software für „Conversational Analytics“ (denken Sie an Call-Center-Metriken) und Gesprächsassistenten verkauft, gelandet 400 Millionen Dollar im Februar. In der Zwischenzeit bietet Highspot, dessen KI-gestützte Plattform Vertriebsmitarbeitern und Vermarktern datengesteuerte Empfehlungen in Echtzeit liefert, geschnappt 248 Millionen Dollar im Januar.

Investoren können durchaus sicherere Wetten wie die automatisierte Analyse von Kundenbeschwerden oder die Generierung von Verkaufskontakten verfolgen, auch wenn diese nicht so „sexy“ sind wie die generative KI. Das soll nicht heißen, dass es keine großen aufmerksamkeitsstarken Investitionen geben wird, aber sie werden Spielern mit Schlagkraft vorbehalten sein.