Die Forschung auf dem Gebiet des maschinellen Lernens und der KI, mittlerweile eine Schlüsseltechnologie in praktisch jeder Branche und jedem Unternehmen, ist viel zu umfangreich, als dass jemand sie vollständig lesen könnte. Diese Kolumne, Perceptron, zielt darauf ab, einige der relevantesten jüngsten Entdeckungen und Artikel zu sammeln – insbesondere in, aber nicht beschränkt auf, künstliche Intelligenz – und zu erklären, warum sie wichtig sind.

In den letzten Wochen haben Wissenschaftler einen Algorithmus entwickelt, um faszinierende Details über die schwach beleuchteten – und in einigen Fällen pechschwarzen – Asteroidenkrater des Mondes aufzudecken. An anderer Stelle haben MIT-Forscher ein KI-Modell mit Lehrbüchern trainiert, um zu sehen, ob es die Regeln einer bestimmten Sprache selbstständig herausfinden kann. Und Teams von DeepMind und Microsoft untersuchten, ob Bewegungserfassungsdaten verwendet werden könnten, um Robotern beizubringen, wie sie bestimmte Aufgaben wie Gehen ausführen.

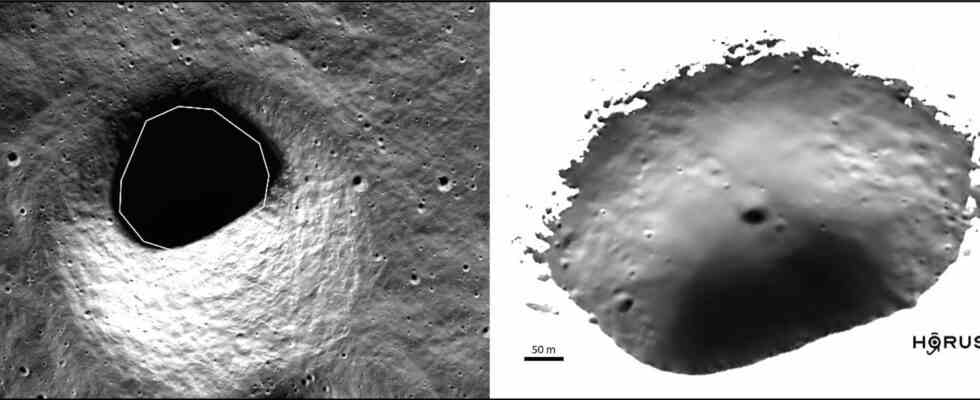

Mit dem bevorstehenden (und vorhersehbar verzögerten) Start von Artemis I steht die Mondwissenschaft wieder im Rampenlicht. Ironischerweise sind jedoch die dunkelsten Regionen des Mondes möglicherweise die interessantesten, da sie möglicherweise Wassereis beherbergen, das für unzählige Zwecke verwendet werden kann. Es ist leicht, die Dunkelheit zu erkennen, aber was ist da drin? Ein internationales Team von Bildexperten hat ML mit einigem Erfolg auf das Problem angewendet.

Obwohl die Krater in tiefster Dunkelheit liegen, fängt der Lunar Reconnaissance Orbiter immer noch das gelegentliche Photon von innen ein, und das Team hat jahrelange dieser unterbelichteten (aber nicht völlig schwarzen) Aufnahmen mit einer „physikbasierten, auf tiefem Lernen basierenden Nachbearbeitung“ zusammengestellt Werkzeug“ beschrieben in Geophysical Research Letters. Das Ergebnis ist, dass „sichtbare Routen in die permanent schattigen Regionen jetzt entworfen werden können, wodurch die Risiken für Artemis-Astronauten und Roboterforscher erheblich reduziert werden“. nach David Kring vom Lunar and Planetary Institute.

Es werde Licht! Das Innere des Kraters wird aus Streuphotonen rekonstruiert.

Sie werden Taschenlampen haben, stellen wir uns vor, aber es ist gut, vorher eine allgemeine Vorstellung davon zu haben, wohin sie gehen müssen, und natürlich könnte dies Auswirkungen darauf haben, worauf sich die Robotererkundung oder Lander konzentrieren.

So nützlich es auch sein mag, es ist nichts Mysteriöses daran, spärliche Daten in ein Bild umzuwandeln. Aber in der Welt der Linguistik macht KI faszinierende Fortschritte in der Frage, wie und ob Sprachmodelle wirklich wissen, was sie wissen. Im Fall des Erlernens der Grammatik einer Sprache stellte ein MIT-Experiment fest, dass ein Modell, das mit mehreren Lehrbüchern trainiert wurde, in der Lage war, ein eigenes Modell der Funktionsweise einer bestimmten Sprache zu erstellen, bis zu dem Punkt, an dem seine Grammatik für Polnisch beispielsweise erfolgreich Lehrbuchprobleme lösen konnte darüber.

„Linguisten haben gedacht, dass man menschlich sein muss, um die Regeln einer menschlichen Sprache wirklich zu verstehen, um sich in das einzufühlen, was das System zum Ticken bringt. Wir wollten sehen, ob wir die Arten von Wissen und Argumentation nachahmen können, die Menschen (Linguisten) für diese Aufgabe mitbringen.“ sagte Adam Albright vom MIT in einer Pressemitteilung. Es ist eine sehr frühe Forschung an dieser Front, aber vielversprechend, da sie zeigt, dass subtile oder versteckte Regeln von KI-Modellen ohne explizite Anweisung in ihnen „verstanden“ werden können.

Das Experiment befasste sich jedoch nicht direkt mit einer zentralen, offenen Frage in der KI-Forschung: Wie kann verhindert werden, dass Sprachmodelle giftige, diskriminierende oder irreführende Sprache ausgeben? Neu Arbeit aus DeepMind tut Gehen Sie dies an, indem Sie einen philosophischen Ansatz für das Problem der Ausrichtung von Sprachmodellen an menschlichen Werten verfolgen.

Die Forscher des Labors gehen davon aus, dass es keinen einheitlichen Weg zu besseren Sprachmodellen gibt, da die Modelle je nach Kontext, in dem sie eingesetzt werden, unterschiedliche Eigenschaften aufweisen müssen. Beispielsweise würde ein Modell zur Unterstützung wissenschaftlicher Studien idealerweise nur wahre Aussagen treffen, während ein Agent, der die Rolle eines Moderators in einer öffentlichen Debatte spielt, Werte wie Toleranz, Höflichkeit und Respekt praktizieren würde.

Wie können diese Werte also in ein Sprachmodell eingeflößt werden? Die DeepMind-Koautoren schlagen keinen bestimmten Weg vor. Stattdessen implizieren sie, dass Models im Laufe der Zeit durch Prozesse, die sie aufrufen, „robustere“ und „respektvollere“ Gespräche pflegen können Kontextkonstruktion und Aufklärung. Wie die Co-Autoren erklären: „Selbst wenn sich eine Person der Werte nicht bewusst ist, die eine bestimmte Gesprächspraxis regeln, kann der Agent dem Menschen dennoch helfen, diese Werte zu verstehen, indem er sie im Gespräch vorwegnimmt, wodurch der Kommunikationsverlauf tiefer und fruchtbarer für den Menschen wird menschlicher Sprecher.“

Das LaMDA-Sprachmodell von Google, das auf eine Frage antwortet.

Die Suche nach den vielversprechendsten Methoden zur Ausrichtung von Sprachmodellen erfordert viel Zeit und Ressourcen – finanziell und anderweitig. Aber in Bereichen jenseits der Sprache, insbesondere in wissenschaftlichen Bereichen, ist dies möglicherweise nicht mehr lange der Fall, dank eines 3,5-Millionen-Dollar-Zuschusses der National Science Foundation (NSF), der einem Team von Wissenschaftlern der University of Chicago, des Argonne National Laboratory und gewährt wurde MIT.

Mit dem NSF-Stipendium planen die Empfänger, das zu bauen, was sie als „Modellgärten“ oder Aufbewahrungsorte von KI-Modellen bezeichnen, die entwickelt wurden, um Probleme in Bereichen wie Physik, Mathematik und Chemie zu lösen. Die Repositories werden die Modelle mit Daten- und Rechenressourcen sowie automatisierten Tests und Screens verknüpfen, um ihre Genauigkeit zu validieren, was es idealerweise für wissenschaftliche Forscher einfacher macht, die Tools in ihren eigenen Studien zu testen und einzusetzen.

„Ein Benutzer kann zu dem kommen [model] Garten und sehen Sie all diese Informationen auf einen Blick“, Ben Blaiszik, ein Data-Science-Forscher bei Globus Labs, der an dem Projekt beteiligt ist, sagte in einer Pressemitteilung. „Sie können das Modell zitieren, sie können sich über das Modell informieren, sie können die Autoren kontaktieren und sie können das Modell selbst in einer Webumgebung, auf Führungsrechnern oder auf ihrem eigenen Computer aufrufen.“

In der Zwischenzeit bauen Forscher im Bereich der Robotik eine Plattform für KI-Modelle nicht mit Software, sondern mit Hardware – neuromorphe Hardware, um genau zu sein. Intel Ansprüche Die neueste Generation seines experimentellen Loihi-Chips kann es einem Objekterkennungsmodell ermöglichen, ein Objekt zu „lernen“, das es noch nie zuvor gesehen hat, und dabei bis zu 175-mal weniger Energie verbraucht, als wenn das Modell auf einer CPU laufen würde.

Ein humanoider Roboter, der mit einem der experimentellen neuromorphen Chips von Intel ausgestattet ist.

Neuromorphe Systeme versuchen, die biologischen Strukturen im Nervensystem nachzuahmen. Während traditionelle maschinelle Lernsysteme entweder schnell oder energieeffizient sind, erreichen neuromorphe Systeme sowohl Geschwindigkeit als auch Effizienz, indem sie Knoten zur Verarbeitung von Informationen und Verbindungen zwischen den Knoten verwenden, um elektrische Signale unter Verwendung analoger Schaltungen zu übertragen. Die Systeme können die zwischen den Knoten fließende Strommenge modulieren, sodass jeder Knoten die Verarbeitung durchführen kann – jedoch nur bei Bedarf.

Intel und andere glauben, dass neuromorphes Computing Anwendungen in der Logistik hat, zum Beispiel als Antrieb für einen Roboter, der gebaut wurde, um bei Fertigungsprozessen zu helfen. An diesem Punkt ist es theoretisch – neuromorphes Computing hat seine Schattenseiten – aber vielleicht wird diese Vision eines Tages Wirklichkeit werden.

Bildnachweis: DeepMind

Näher an der Realität ist DeepMinds jüngste Arbeit in „verkörperter Intelligenz“ oder die Verwendung menschlicher und tierischer Bewegungen, um Robotern beizubringen, einen Ball zu dribbeln, Kisten zu tragen und sogar Fußball zu spielen. Die Forscher des Labors entwickelten ein Setup zur Aufzeichnung von Daten von Bewegungstrackern, die von Menschen und Tieren getragen wurden, aus denen ein KI-System lernte, neue Aktionen auszuführen, wie z. B. das Gehen in einer kreisförmigen Bewegung. Die Forscher behaupten, dass sich dieser Ansatz gut auf Roboter in der realen Welt übertragen lässt, da er beispielsweise einem vierbeinigen Roboter ermöglicht, wie ein Hund zu laufen und gleichzeitig einen Ball zu dribbeln.

Zufälligerweise Microsoft Anfang dieses Sommers veröffentlicht eine Bibliothek mit Bewegungserfassungsdaten, die die Erforschung von Robotern vorantreiben soll, die wie Menschen gehen können. Die Bibliothek namens MoCapAct enthält Motion-Capture-Clips, die, wenn sie mit anderen Daten verwendet werden, verwendet werden können, um agile zweibeinige Roboter zu erstellen – zumindest in der Simulation.

„[Creating this data set] hat gegenüber vielen GPU-Ausstattungen umgerechnet 50 Jahre gedauert [servers] … ein Beweis für die Rechenhürde, die MoCapAct für andere Forscher beseitigt“, schrieben die Co-Autoren der Arbeit in einem Blogbeitrag. „Wir hoffen, dass die Community auf unserem Datensatz aufbauen und daran arbeiten kann, unglaubliche Forschungen zur Steuerung humanoider Roboter zu betreiben.“

Die Peer-Review von wissenschaftlichen Arbeiten ist eine unschätzbare menschliche Arbeit, und es ist unwahrscheinlich, dass die KI dort übernehmen wird, aber es kann tatsächlich dazu beitragen, sicherzustellen, dass Peer-Reviews tatsächlich hilfreich sind. Eine Schweizer Forschungsgruppe hat sich das angeschaut modellbasierte Auswertung von Peer-Reviews, und ihre ersten Ergebnisse sind gemischt – auf eine gute Art und Weise. Es gab keine offensichtlich guten oder schlechten Methoden oder Trends, und die Bewertung der Veröffentlichung schien nicht vorherzusagen, ob eine Überprüfung gründlich oder hilfreich war. Das ist jedoch in Ordnung, denn obwohl die Qualität der Rezensionen unterschiedlich ist, möchten Sie nicht, dass es überall einen systematischen Mangel an guten Rezensionen gibt, außer beispielsweise in großen Zeitschriften. Ihre Arbeit dauert an.

Zu guter Letzt, für alle, die sich Gedanken über Kreativität in diesem Bereich machen, Hier ist ein persönliches Projekt von Karen X. Cheng Das zeigt, wie ein bisschen Einfallsreichtum und harte Arbeit mit KI kombiniert werden können, um etwas wirklich Originelles zu produzieren.